Ceph

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

Ceph는 분산 스토리지 시스템으로, 클러스터 모니터, OSD, 메타데이터 서버, HTTP 게이트웨이, 관리자 등 여러 데몬을 사용한다. 데이터를 여러 스토리지 장치에 분산하여 처리량을 높이고, 객체 스토리지, 블록 스토리지, 파일 스토리지를 지원하며, 아마존 S3 또는 OpenStack Swift API와 호환되는 인터페이스를 제공한다. Ceph는 2004년 세이지 웨일에 의해 개발되었으며, 2014년 레드햇에 인수되었고, 현재는 Ceph 재단에서 관리하고 있다.

더 읽어볼만한 페이지

- 네트워크 파일 시스템 - 클라우드 스토리지

클라우드 스토리지는 가상화 기술을 기반으로 데이터를 분산 저장하여 관리하며, 웹 또는 앱을 통해 파일 작업이 가능하고 용량 확장이 유연하며, 객체, 파일, 블록 스토리지의 세 가지 유형으로 발전했다. - 네트워크 파일 시스템 - 아마존 S3

아마존 S3는 AWS에서 제공하는 객체 스토리지 서비스로, 데이터 액세스 빈도 및 성능 요구 사항에 따라 다양한 스토리지 클래스를 제공하며 높은 확장성, 고가용성, 낮은 지연 시간, 높은 내구성을 제공한다. - 레드햇 소프트웨어 - 매니지IQ

매니지IQ는 IT 부서의 효율적인 운영을 지원하는 소프트웨어로, 셀프 서비스, 규정 준수, 최적화 기능을 제공하며, 다양한 플랫폼을 지원하고 AI, 머신러닝 기술을 활용하여 클라우드 관리 기능을 개선하고 있지만, 기능 부족, 시스템 성능, 보안 취약점 등의 비판도 존재한다. - 레드햇 소프트웨어 - 시그윈

Cygwin은 윈도우에서 유닉스 시스템과 유사한 환경을 제공하는 소프트웨어로, POSIX API 구현 및 다양한 개발 도구를 통해 유닉스 기반 소프트웨어의 개발, 빌드, 실행을 지원한다. - 자유 소프트웨어 - 김프

김프(GIMP)는 GNU 프로젝트에서 개발된 크로스 플랫폼 기반의 무료 오픈소스 래스터 그래픽 편집기로, 다양한 운영체제를 지원하며 풍부한 기능을 제공하지만 사용자 인터페이스에 대한 비판과 일부 기능의 부족함에 대한 평가도 존재한다. - 자유 소프트웨어 - PHP

PHP는 라스무스 러도프가 개발한 범용 스크립팅 언어로, 웹 개발에 널리 사용되며 LAMP 아키텍처의 핵심 요소이다.

| Ceph - [IT 관련 정보]에 관한 문서 | |

|---|---|

| 일반 정보 | |

| |

| 종류 | 분산 객체 저장소 |

| 라이선스 | LGPLv2.1 |

| 웹사이트 | Ceph 공식 웹사이트 |

| 개발 | |

| 개발자 | 잉크탱크 스토리지 (Sage Weil, Yehuda Sadeh Weinraub, Gregory Farnum, Josh Durgin, Samuel Just, Wido den Hollander) |

| 개발 원조 | Red Hat Intel CERN Cisco Fujitsu SanDisk Canonical SUSE |

| 프로그래밍 언어 | C++ Python |

| 기술 정보 | |

| 운영체제 | Linux FreeBSD Windows |

| 릴리스 정보 | |

| 최신 버전 | 17.2.6 "Quincy" |

| 최신 릴리스 날짜 | 2023년 4월 10일 |

2. 디자인

Ceph는 클러스터 모니터, 메타데이터 서버, 객체 스토리지 장치, RESTful 게이트웨이 등 여러 데몬으로 구성되어 높은 가용성과 확장성을 제공하는 분산 스토리지 시스템이다. Ceph는 데이터를 여러 스토리지 장치와 노드에 분산하는 스트라이핑 기술을 통해 RAID와 유사한 방식으로 높은 처리량을 제공한다.

2. 1. 구성 요소

Ceph는 다섯 가지 종류의 데몬을 사용한다:[15]

- 클러스터 모니터 (ceph-mon): 활성 및 실패한 클러스터 노드, 클러스터 구성, 데이터 배치 및 글로벌 클러스터 상태에 대한 정보를 추적한다.

- OSD (ceph-osd): BlueStore 백 엔드를 통해 벌크 데이터 저장 장치를 직접 관리한다.[16] v12.x 릴리스 이후, 기존 파일 시스템 위에 구현된 Filestore[17] 백 엔드를 대체한다.

- 메타데이터 서버 (ceph-mds): CephFS 파일 시스템 내의 아이노드와 디렉터리에 대한 접근을 유지하고 중개한다.

- HTTP 게이트웨이 (ceph-rgw): 오브젝트 스토리지 계층을 아마존 S3 또는 OpenStack Swift API와 호환되는 인터페이스로 노출한다.

- 관리자 (ceph-mgr): 클러스터 모니터링, 장부 정리 및 유지 관리 작업을 수행하며, 외부 모니터링 시스템 및 관리 (예: 밸런서, 대시보드, Prometheus, Zabbix 플러그인)와 인터페이스한다.[18]

이들은 모두 완전히 분산되어 있으며, 개별적인 전용 서버 또는 컨버지드 토폴로지에 배포될 수 있다. 다양한 요구 사항을 가진 클라이언트는 적절한 클러스터 구성 요소와 직접 상호 작용한다.[19]

Ceph는 스트라이핑을 사용하여 여러 스토리지 장치와 노드에 데이터를 분산하여 RAID와 유사한 방식으로 더 높은 처리량을 달성한다. 빈번하게 접근하는 서비스는 더 많은 노드에 복제될 수 있도록 적응형 로드 밸런싱이 지원된다.[20]

2017년 9월 기준으로, BlueStore는 프로덕션 환경에서 기본적으로 권장되는 스토리지 백 엔드이며,[21] 이전 Filestore 백 엔드보다 더 나은 지연 시간과 구성 가능성을 제공하고, 추가 처리 및 캐싱 계층을 포함하는 파일 시스템 기반 스토리지의 단점을 피한다. Filestore 백 엔드는 2023년 중반 Reef 릴리스부터 사용이 중단될 예정이다. XFS는 Filestore OSD에 권장되는 기본 파일 시스템이었으며, Btrfs는 사용자의 책임 하에 사용할 수 있었다. ext4 파일 시스템은 제한된 메타데이터 용량으로 인해 권장되지 않았다.[22] BlueStore 백 엔드는 여전히 작은 메타데이터 파티션에 XFS를 사용한다.[23]

2. 2. 스토리지 백엔드

2017년 9월부터 프로덕션 환경에서 기본적으로 권장되는 스토리지 백엔드는 BlueStore이다.[21] BlueStore는 이전 Filestore 백엔드보다 지연 시간이 더 짧고 구성 가능성이 높다. 파일 시스템 기반 스토리지의 단점인 추가 처리 및 캐싱 계층이 필요 없다는 장점이 있다. Filestore 백엔드는 2023년 중반 Reef 릴리스부터 사용이 중단될 예정이다.[21]Filestore 백엔드를 사용할 때는 XFS가 Filestore OSD에 권장되는 기본 파일 시스템이었다. Btrfs는 사용자가 직접 위험을 감수하고 사용할 수 있었으며, ext4 파일 시스템은 메타데이터 용량이 제한되어 권장되지 않았다.[22] BlueStore 백엔드는 작은 메타데이터 파티션에 여전히 XFS를 사용한다.[23]

3. Object storage S3

Ceph는 RADOS 게이트웨이를 통해 분산 객체 스토리지를 구현하며, 이는 아마존 S3 또는 OpenStack Swift와 호환되는 인터페이스를 통해 기본 스토리지 계층을 노출한다.[24]

Ceph RGW 배포는 쉽게 확장되며, 빅 데이터 (데이터 레이크), 백업 및 아카이브, IoT, 미디어, 비디오 녹화, 가상 머신 및 컨테이너를 위한 배포 이미지와 같은 대규모 사용 사례에 대용량 및 고밀도 저장 매체를 자주 활용한다.[24]

3. 1. librados

Ceph는 분산 객체 스토리지를 구현하고 있다. Ceph의 소프트웨어 라이브러리가 제공하는 클라이언트 애플리케이션 `librados`를 이용하여 RADOS (''reliable autonomic distributed object store; 신뢰성 있는 자율 분산 객체 스토어'')라고 불리는 Ceph 고유의 객체 기반 스토리지 시스템에 직접 접근할 수 있다. 또한, `librados`는 ''RADOS 블록 장치 (RBD)'', ''RADOS Gateway'', ''Ceph File System (CephFS)'' 등의 Ceph의 주요 인터페이스 기반을 제공한다.`librados` 소프트웨어 라이브러리는 C, C++, 자바, PHP, 및 파이썬에서의 접근을 제공한다. RADOS Gateway는 RADOS 객체 스토어를 네이티브 Amazon S3 API와 OpenStack Swift API 모두에서 사용할 수 있는 RESTful 인터페이스로 공개한다.

4. Block storage

Ceph는 클라이언트에 씬 프로비저닝된 블록 장치를 제공한다. 애플리케이션이 블록 장치를 사용하여 Ceph에 데이터를 쓰면 Ceph는 자동으로 클러스터 전체에 데이터를 스트라이핑하고 복제한다. Ceph의 ''RADOS 블록 장치''(RBD)는 커널 기반 가상 머신(KVM)과도 통합된다.[1]

RBD는 librados 위에 구축되어 읽기 전용 스냅샷 생성 및 스냅샷 복원 등의 기능을 상속받는다. Ceph는 클러스터 전체에 이미지를 스트라이핑하여 대용량 블록 장치 이미지의 읽기 액세스 성능을 향상시킨다.[1]

4. 1. 사용 사례

Ceph 블록 스토리지는 데이터베이스, 가상 머신, 데이터 분석, 인공 지능 및 기계 학습 등 다양한 사용 사례에 적합하다. Ceph의 블록 스토리지는 기존 HDD 및/또는 SSD와 연결되어 사용될 수 있으며, 고성능을 위해 NVMe 인터페이스를 갖춘 SSD를 점점 더 많이 활용하고 있다.[1]Ceph는 씬 프로비저닝된 블록 장치를 제공하며, 애플리케이션이 블록 장치를 통해 Ceph에 데이터를 쓰면 자동으로 클러스터 전체에 데이터를 스트라이핑하고 복제한다. Ceph의 ''RADOS 블록 장치''(RBD)는 KVM과 통합될 수 있다.[1]

RBD는 librados를 기반으로 구축되어 클론 및 스냅샷과 같은 기능을 상속받는다. Ceph는 클러스터 전체에 볼륨을 스트라이핑하여 대형 블록 장치 이미지의 성능을 향상시킨다.[1]

Ceph-iSCSI는 마이크로소프트 윈도우 및 VMware vSphere 서버 또는 iSCSI 프로토콜을 사용할 수 있는 클라이언트에서 분산된 고가용성 블록 스토리지에 대한 액세스를 가능하게 하는 게이트웨이이다. 하나 이상의 iSCSI 게이트웨이 호스트에서 ceph-iscsi를 사용하면 Ceph RBD 이미지를 iSCSI 대상과 관련된 논리 단위(LU)로 사용할 수 있으며, 필요에 따라 로드 밸런싱되고 고가용성 방식으로 액세스할 수 있다.[1]

블록 장치는 가상화될 수 있으며, 오픈시프트, 오픈스택, 쿠버네티스, 오픈네뷸라, 가네티, 아파치 클라우드스택 및 프록스목스 가상 환경과 같은 가상화 플랫폼에서 가상 머신에 블록 스토리지를 제공한다.[1]

4. 2. Ceph-iSCSI

Ceph-iSCSI는 마이크로소프트 윈도우 및 VMware vSphere 서버 또는 iSCSI 프로토콜을 사용할 수 있는 클라이언트에서 분산된 고가용성 블록 스토리지에 대한 액세스를 가능하게 하는 게이트웨이이다. 하나 이상의 iSCSI 게이트웨이 호스트에서 ceph-iscsi를 사용하면 Ceph RBD 이미지를 iSCSI 대상과 관련된 논리 단위(LU)로 사용할 수 있으며, 필요에 따라 로드 밸런싱되고 고가용성 방식으로 액세스할 수 있다.ceph-iscsi 구성은 Ceph RADOS 객체 저장소에 저장되므로 ceph-iscsi 게이트웨이 호스트는 본질적으로 영구 상태가 없으므로 언제든지 교체, 보강 또는 축소할 수 있다. 결과적으로 Ceph Storage를 사용하면 고객이 상용 하드웨어 및 완전한 오픈 소스 플랫폼에서 진정한 분산형, 고가용성, 탄력적이고 자체 복구 엔터프라이즈 스토리지 기술을 실행할 수 있다.

4. 3. 가상화 플랫폼 통합

Ceph는 씬 프로비저닝된 블록 장치를 제공하며, 애플리케이션이 데이터를 쓰면 Ceph는 자동으로 클러스터 전체에 데이터를 스트라이핑하고 복제한다. Ceph의 ''RADOS 블록 장치''(RBD)는 KVM과 통합된다.Ceph 블록 스토리지는 오픈시프트, 오픈스택, 쿠버네티스, 오픈네뷸라, 가네티, 아파치 클라우드스택, 프록스목스 가상 환경과 같은 가상화 플랫폼에서 가상 머신에 블록 스토리지를 제공할 수 있도록 가상화될 수 있다.

5. File storage

Ceph의 파일 시스템(CephFS)은 Ceph의 객체 저장소 및 블록 장치 서비스와 동일한 RADOS 기반에서 실행된다. CephFS 메타데이터 서버(MDS)는 파일 시스템의 디렉토리와 파일 이름을 RADOS 클러스터 내에 저장된 객체에 매핑하는 서비스를 제공한다. 메타데이터 서버 클러스터는 확장 또는 축소될 수 있으며, 클러스터 호스트 간에 데이터를 균등하게 분산하기 위해 파일 시스템 메타데이터 랭크를 동적으로 재분배할 수 있다. 이는 높은 성능을 보장하고 클러스터 내 특정 호스트에 과도한 부하가 걸리는 것을 방지한다.[69]

5. 1. 클라이언트 마운트

클라이언트는 리눅스 커널 클라이언트를 사용하여 POSIX 호환 파일 시스템으로 마운트한다. 2010년 3월 19일, 리누스 토르발스는 2010년 5월 16일에 릴리스된 리눅스 커널 버전 2.6.34에 Ceph 클라이언트를 병합했다.[69] 또한, 구형 FUSE 기반 클라이언트도 사용할 수 있다. 서버는 일반적인 Unix 데몬으로 동작한다.5. 2. 사용 사례

Ceph의 파일 스토리지는 종종 로그 수집, 메시징 및 파일 스토리지와 관련이 있다.[69] Ceph 파일 시스템(CephFS)은 객체 스토리지 및 블록 장치 인터페이스를 제공하는 것과 동일한 Ceph 객체 스토리지 시스템에서 작동한다. Ceph 메타데이터 서버 클러스터는 파일 시스템의 디렉토리와 파일 이름을 RADOS 클러스터 내에 저장된 객체에 매핑하는 서비스를 제공한다. 메타데이터 서버 클러스터는 확장 및 축소가 가능하며, 파일 시스템을 동적으로 재분산하여 클러스터 호스트 간에 데이터를 균등하게 분산시킬 수 있다. 이 기능 덕분에 높은 성능을 유지하고 클러스터 내 특정 호스트에 큰 부하가 걸리는 것을 방지할 수 있다.클라이언트는 리눅스 커널 클라이언트를 사용하여 POSIX 호환 파일 시스템으로 마운트한다. 2010년 3월 19일, 리누스 토르발스는 2010년 5월 16일에 릴리스된 리눅스 커널 버전 2.6.34에 Ceph 클라이언트를 머지했다.[69] 또한, 구형 FUSE 기반 클라이언트도 사용할 수 있다. 서버는 일반적인 Unix 데몬으로 동작한다.

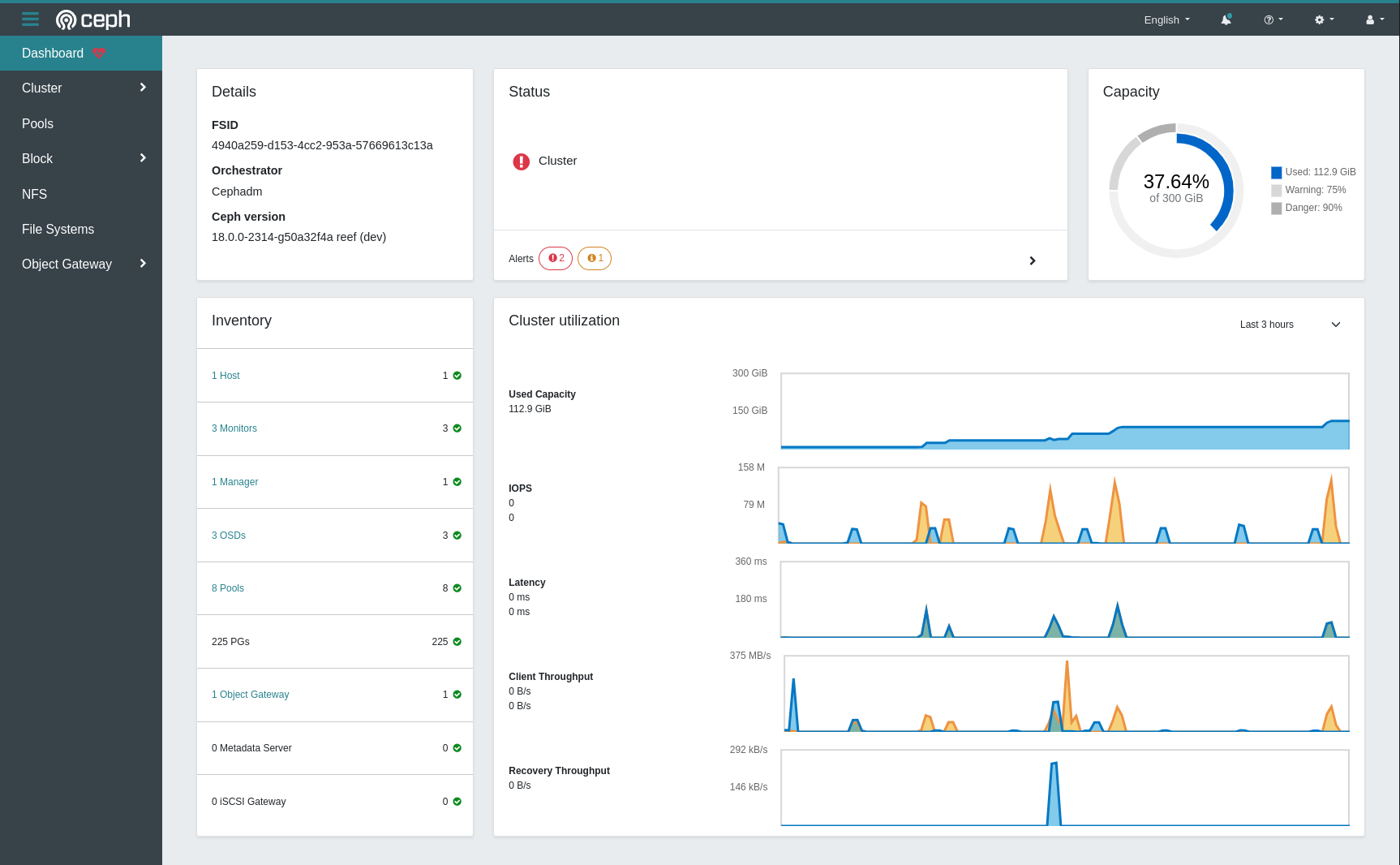

6. Dashboard

2018년부터 클러스터 관리를 위한 대시보드 웹 UI 프로젝트가 진행되고 있다. 이 프로젝트는 LGPL-3 라이선스 하에 Ceph 커뮤니티에서 개발되었으며, Ceph-mgr, 파이썬, 앵귤러 프레임워크, Grafana를 사용한다.[25] 2023년 초에 시작 페이지가 새로워졌다.[26]

이전에 개발되었으나 현재는 종료된 대시보드 프로젝트는 다음과 같다:[27]

- Calamari (2013–2018)

- OpenAttic (2013–2019)

- VSM (2014–2016)

- Inkscope (2015–2016)

- Ceph-Dash (2015–2017)

7. Crimson

2019년부터 Crimson 프로젝트는 OSD 데이터 경로를 재구현하고 있다. Crimson의 목표는 대기 시간과 CPU 오버헤드를 최소화하는 것이다. NVMe 및 3D XPoint를 포함한 최신 스토리지 장치 및 인터페이스는 HDD와 SAS/SATA SSD보다 훨씬 빨라졌지만, CPU 성능은 그 속도를 따라가지 못했다. 또한 Crimson은 이전 버전의 ceph-osd와 호환되는 드롭인 교체를 목표로 한다. Crimson은 BlueStore 백 엔드(AlienStore를 통해)와 함께 작동할 수 있지만, 테스트를 위해 CyanStore와 함께 SeaStore라는 새로운 네이티브 ObjectStore 구현도 개발 중이다. SeaStore를 만드는 한 가지 이유는 BlueStore 백 엔드의 트랜잭션 지원이 RocksDB에 의해 제공되며, 더 나은 병렬 처리를 달성하기 위해 다시 구현해야 하기 때문이다.[28][29][30]

8. 역사

Ceph는 세이지 웨일(Sage Weil)이 캘리포니아 대학교, 산타크루즈(UCSC) 잭 바스킨 공과대학에서 박사 학위 논문을 위해 만든 분산 스토리지 시스템이다.[31] 이 프로젝트는 스콧 A. 브란트 교수의 지도를 받았으며, 고급 시뮬레이션 및 컴퓨팅 프로그램(ASC)의 후원을 받았다. 여기에는 로스 알라모스 국립 연구소(LANL), 샌디아 국립 연구소(SNL), 로렌스 리버모어 국립 연구소(LLNL)가 포함되었다.[32] Ceph의 초기 코드는 2004년 세이지 웨일이 LLNL에서 여름 인턴십을 하면서 작성되었으며, 확장 가능한 파일 시스템 메타데이터 관리(현재 Ceph의 MDS)에 대한 작업을 수행했다.[33]

2005년, 세이지 웨일은 스콧 A. 브란트와 카를로스 말츠한이 이끈 여름 프로젝트의 일환으로 Ceph라는 이름을 가진 완전한 기능을 갖춘 파일 시스템 프로토타입을 만들었다. Ceph는 2006년 11월 USENIX OSDI 2006[34]과 SC'06[35]에서 발표되었다.

2007년 가을, 웨일은 대학원 졸업 후에도 Ceph 개발에 전념했으며, 예후다 사데 웨인라웁과 그레고리 파넘이 핵심 개발팀에 합류했다. 2010년 3월 19일, 리누스 토르발스는 Ceph 클라이언트를 리눅스 커널 버전 2.6.34에 병합했다.[36][37]

2012년, 웨일은 Ceph에 대한 전문 서비스 및 지원을 제공하기 위해 잉크탱크 스토리지(Inktank Storage)를 설립했다.[38][39] 2014년 4월, 레드햇(Red Hat)은 잉크탱크를 인수하여 Ceph 개발의 대부분을 사내로 가져왔다.[40]

2015년 10월, Ceph 커뮤니티 자문 위원회가 결성되어 오픈 소스 소프트웨어 정의 스토리지 기술의 방향을 이끌도록 커뮤니티를 지원했다. 이 위원회에는 레드햇, 인텔, 캐노니컬(Canonical), CERN, 시스코, 후지쯔, SanDisk, SUSE 등 Ceph 프로젝트에 헌신하는 글로벌 IT 조직의 구성원들이 참여했다.[41]

2018년 11월, 리눅스 재단은 Ceph 커뮤니티 자문 위원회의 후속 조직으로 Ceph 재단을 출범시켰다. Ceph 재단의 창립 멤버로는 Amihan, 캐노니컬, 차이나 모바일, 디지털오션, 인텔, OVH, ProphetStor 데이터 서비스, 레드햇, SoftIron, SUSE, 웨스턴 디지털, XSKY 데이터 기술 및 ZTE가 포함되었다.[42]

2021년 3월, SUSE는 Rancher의 Longhorn을 선호하여 Ceph를 통합한 엔터프라이즈 스토리지 제품을 중단했다.[43]

8. 1. 릴리스 기록

9. 지원 플랫폼

Ceph는 기본적으로 리눅스용으로 구축되었지만, 윈도우 플랫폼으로도 부분적으로 이식되었다. Windows Server 2016(UNIX 소켓 구현 부족으로 일부 명령을 사용하지 못할 수 있음), Windows Server 2019, Windows Server 2022에서 프로덕션 환경으로 사용할 수 있으며, Windows 10, Windows 11에서도 테스트/개발이 가능하다. 윈도우에서는 Ceph RBD와 CephFS를 사용할 수 있지만, OSD는 지원되지 않는다.[52][53][54]

Ceph의 FreeBSD 구현도 존재한다.[3]

10. 어원

"Ceph"라는 이름은 두족류(cephalopod)의 줄임말이며, 이는 연체동물에 속하는 오징어, 갑오징어, 앵무조개, 문어 등을 포함하는 분류이다. 이 이름은 (로고에도 나타나 있듯이) 문어의 고도로 병렬적인 행동을 암시하며, 파일 시스템을 UCSC의 마스코트인 바나나 민달팽이 "Sammy"와 연관시키기 위해 선택되었다.[15] 두족류와 바나나 민달팽이는 모두 연체동물이다.

참조

[1]

웹사이트

Ceph Community Forms Advisory Board

http://www.storagere[...]

2015-10-28

[2]

웹사이트

GitHub Repository

https://github.com/c[...]

[3]

웹사이트

FreeBSD Quarterly Status Report

https://www.freebsd.[...]

[4]

웹사이트

LGPL2.1 license file in the Ceph sources

https://github.com/c[...]

2014-10-24

[5]

뉴스

The History Boys: Object storage ... from the beginning

https://www.theregis[...]

2016-07-15

[6]

웹사이트

Ceph Distributed Network File System

http://kerneltrap.or[...]

KernelTrap

2007-11-15

[7]

웹사이트

Ceph Clusters

https://cephdocs.s3-[...]

2022-11-12

[8]

Youtube

Ceph Operations at CERN: Where Do We Go From Here? - Dan van der Ster & Teo Mouratidis, CERN

https://www.youtube.[...]

2019-05-24

[9]

웹사이트

Journey to next-gen Ceph storage at OVHcloud with LXD

https://blog.ovhclou[...]

2020-06-15

[10]

웹사이트

CephFS distributed filesystem

https://docs.ovh.com[...]

[11]

Youtube

Ceph - Distributed Storage System in OVH [en] - Bartłomiej Święcki

https://www.youtube.[...]

2016-04-07

[12]

Youtube

200 Clusters vs 1 Admin - Bartosz Rabiega, OVH

https://www.youtube.[...]

2019-05-24

[13]

웹사이트

Why We Chose Ceph to Build Block Storage

https://www.digitalo[...]

2018-05-31

[14]

Youtube

Ceph Tech Talk: Ceph at DigitalOcean

https://www.youtube.[...]

2021-10-07

[15]

웹사이트

Ceph: A Linux petabyte-scale distributed file system

http://www.ibm.com/d[...]

IBM

2010-06-04

[16]

웹사이트

BlueStore

http://docs.ceph.com[...]

Ceph

[17]

웹사이트

BlueStore Migration

https://docs.ceph.co[...]

2020-04-12

[18]

웹사이트

Ceph Manager Daemon — Ceph Documentation

http://docs.ceph.com[...]

2019-01-31

[19]

웹사이트

The Ceph filesystem

https://lwn.net/Arti[...]

LWN.net

2007-11-14

[20]

웹사이트

Learning Ceph, Second Edition

https://www.packtpub[...]

Packt

2017-10-01

[21]

웹사이트

v12.2.0 Luminous Released

http://ceph.com/rele[...]

Ceph Blog

2017-08-29

[22]

웹사이트

Hard Disk and File System Recommendations

http://docs.ceph.com[...]

ceph.com

2017-06-26

[23]

웹사이트

BlueStore Config Reference

https://docs.ceph.co[...]

2020-04-12

[24]

웹사이트

10th International Conference "Distributed Computing and Grid Technologies in Science and Education" (GRID'2023)

https://indico.jinr.[...]

2023-07-03

[25]

웹사이트

Ceph Dashboard

https://docs.ceph.co[...]

2023-04-11

[26]

뉴스

Introducing the new Dashboard Landing Page

https://ceph.io/en/n[...]

2023-02-23

[27]

Youtube

Operating Ceph from the Ceph Dashboard: past, present and future

https://www.youtube.[...]

2022-11-22

[28]

웹사이트

Crimson: evolving Ceph for high performance NVMe

https://next.redhat.[...]

2021-01-18

[29]

Youtube

What's new with Crimson and Seastore?

https://www.youtube.[...]

2022-11-10

[30]

웹사이트

Crimson: Next-generation Ceph OSD for Multi-core Scalability

https://ceph.io/en/n[...]

Ceph

2023-02-07

[31]

웹사이트

Ceph: Reliable, Scalable, and High-Performance Distributed Storage

https://ceph.com/wp-[...]

University of California, Santa Cruz

2007-12-01

[32]

웹사이트

The ASCI/DOD Scalable I/O History and Strategy

https://www.dtc.umn.[...]

2004-05-01

[33]

논문

Dynamic Metadata Management for Petabyte-Scale File Systems

Proc. SC'04, Pittsburgh, PA

2004-11-01

[34]

논문

"Ceph: A scalable, high-performance distributed file system,"

Proc. OSDI, Seattle, WA

2006-11-01

[35]

논문

"CRUSH: Controlled, scalable, decentralized placement of replicated data,"

SC'06, Tampa, FL

2006-11-01

[36]

웹사이트

Client merged for 2.6.34

https://web.archive.[...]

ceph.newdream.net

2010-03-21

[37]

웹사이트

New version of Linux OS includes Ceph file system developed at UCSC

https://news.ucsc.ed[...]

news.ucsc.edu

2010-05-20

[38]

웹사이트

And It All Comes Together

https://web.archive.[...]

Inktank Blog

2012-07-10

[39]

뉴스

The 10 Coolest Storage Startups Of 2012 (So Far)

http://www.crn.com/s[...]

CRN

2013-07-19

[40]

웹사이트

Red Hat to Acquire Inktank, Provider of Ceph

http://www.redhat.co[...]

Red Hat

2014-08-19

[41]

웹사이트

Ceph Community Forms Advisory Board

https://web.archive.[...]

2016-01-20

[42]

웹사이트

The Linux Foundation Launches Ceph Foundation To Advance Open Source Storage

https://www.linuxfou[...]

2018-11-12

[43]

웹사이트

SUSE says tschüss to Ceph-based enterprise storage product – it's Rancher's Longhorn from here on out

https://www.theregis[...]

[44]

웹사이트

SUSE Enterprise Software-Defined Storage

https://www.suse.com[...]

[45]

웹사이트

v16.2.0 Pacific released

https://ceph.io/rele[...]

[46]

웹사이트

v17.2.0 Quincy released

https://ceph.com/en/[...]

[47]

웹사이트

v18.2.0 Reef released

https://ceph.com/en/[...]

2023-08-26

[48]

웹사이트

Active Releases

https://docs.ceph.co[...]

2024-10-03

[49]

웹사이트

v19.2.0 Squid released

https://ceph.io/en/n[...]

2024-10-03

[50]

웹사이트

Active Releases

https://docs.ceph.co[...]

2024-10-03

[51]

웹사이트

Ceph Developer Summit - Tentacle

https://ceph.io/en/c[...]

2024-10-03

[52]

웹사이트

Ceph for Windows

https://cloudbase.it[...]

Cloudbase Solutions

2023-07-02

[53]

웹사이트

Installing Ceph on Windows

https://docs.ceph.co[...]

2023-07-02

[54]

웹사이트

Ceph on Windows

https://www.youtube.[...]

2023-07-02

[55]

웹사이트

Ceph Community Forms Advisory Board

http://www.storagere[...]

2016-01-20

[56]

웹사이트

17.2.6 Quincy released

https://ceph.com/en/[...]

2023-04-10

[57]

웹사이트

v13.1.0 Mimic RC1 released

https://ceph.com/rel[...]

2019-01-28

[58]

웹사이트

GitHub Repository

https://github.com/c[...]

2019-01-28

[59]

웹사이트

FreeBSD Quarterly Status Report

https://www.freebsd.[...]

2019-01-28

[60]

웹사이트

LGPL2.1 license file in the Ceph sources

https://github.com/c[...]

2014-10-24

[61]

웹사이트

Ceph Distributed Network File System

http://kerneltrap.or[...]

KernelTrap

2007-11-15

[62]

웹사이트

v10.2.0 Infernalis Released

http://ceph.com/rele[...]

Ceph Blog

2016-04-21

[63]

웹사이트

v12.2.0 Luminous Released

http://ceph.com/rele[...]

Ceph Blog

2017-08-29

[64]

웹사이트

Ceph: A Linux petabyte-scale distributed file system

http://www.ibm.com/d[...]

IBM

2010-06-04

[65]

웹사이트

BlueStore

http://docs.ceph.com[...]

Ceph

2017-09-29

[66]

웹사이트

Hard Disk and File System Recommendations

http://docs.ceph.com[...]

2017-03-17

[67]

웹사이트

The Ceph filesystem

https://lwn.net/Arti[...]

LWN.net

2007-11-14

[68]

웹사이트

Hard Disk and File System Recommendations

http://docs.ceph.com[...]

ceph.com

2017-06-26

[69]

웹사이트

Client merged for 2.6.34

http://ceph.newdream[...]

ceph.newdream.net

2010-02-19

[70]

문서

Ceph:スケーラブルで高性能な分散ファイルシステム、SA Weil、SA Brandt、EL Miller、DDE Long、C Maltzahn、Proc。

[71]

웹사이트

Ceph: Reliable, Scalable, and High-Performance Distributed Storage

https://ceph.com/wp-[...]

University of California, Santa Cruz

2019-01-28

[72]

웹사이트

And It All Comes Together

http://www.inktank.c[...]

Inktank Blog

2012-07-10

[73]

뉴스

The 10 Coolest Storage Startups Of 2012 (So Far)

http://www.crn.com/s[...]

2013-07-19

[74]

웹사이트

Red Hat to Acquire Inktank, Provider of Ceph

http://www.redhat.co[...]

レッドハット

2014-08-19

[75]

웹사이트

v0.48 "Argonaut" Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[76]

웹사이트

v0.56 Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[77]

웹사이트

v0.61 "Cuttlefish" Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[78]

웹사이트

v0.67 Dumpling Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[79]

웹사이트

v0.72 Emperor Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[80]

웹사이트

v0.80 Firefly Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[81]

웹사이트

v0.87 Giant Released

http://ceph.com/unca[...]

Ceph Blog

2019-01-28

[82]

웹사이트

v0.94 Hammer Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[83]

웹사이트

v9.2.0 Infernalis Released

http://ceph.com/rele[...]

Ceph Blog

2019-01-28

[84]

웹사이트

v11.2.0 Kraken Released

https://ceph.com/rel[...]

Ceph Blog

2019-01-28

[85]

웹사이트

v13.2.0 Mimic Released

https://ceph.com/rel[...]

Ceph Blog

2019-01-28

[86]

웹인용

Ceph Community Forms Advisory Board

https://web.archive.[...]

2016-01-20

[87]

웹인용

v16.2.6 Octopus released

https://ceph.io/rele[...]

[88]

웹인용

GitHub Repository

https://github.com/c[...]

[89]

웹인용

FreeBSD Quarterly Status Report

https://www.freebsd.[...]

[90]

웹인용

LGPL2.1 license file in the Ceph sources

https://github.com/c[...]

2014-10-24

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com