메트로폴리스-헤이스팅스 알고리즘

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

메트로폴리스-헤이스팅스 알고리즘은 확률 밀도 함수에 비례하는 함수를 계산할 수 있을 때, 특정 확률 분포에서 난수열을 생성하는 데 사용되는 마르코프 연쇄 몬테카를로(MCMC) 방법이다. 이 알고리즘은 1953년 니컬러스 메트로폴리스 등에 의해 제안되었고, 1970년 W.K. 헤이스팅스에 의해 일반화되었다. 메트로폴리스-헤이스팅스 알고리즘은 현재 상태와 제안된 후보 상태의 확률 밀도 함수 비율을 기반으로 후보 상태를 수락 또는 거부하는 과정을 반복하며, 목표 분포를 근사하는 난수열을 생성한다. 이 알고리즘은 베이즈 추론, 적분 계산 등 다양한 분야에서 활용되며, 깁스 샘플링, 메트로폴리스법 등과 관련이 있다.

더 읽어볼만한 페이지

- 통계 알고리즘 - 기댓값 최대화 알고리즘

- 몬테카를로 방법 - 피셔-예이츠 셔플

피셔-예이츠 셔플은 유한 집합에서 임의의 순열을 생성하는 알고리즘으로, 피셔와 예이츠가 처음 소개한 후 더스텐펠트에 의해 컴퓨터에 최적화되었으며, 구현 시 편향 요인을 주의해야 한다. - 몬테카를로 방법 - 파티클 필터

파티클 필터는 칼만 필터와 유사하게 상태 공간 모델에서 관측 불가능한 상태 열의 확률 분포를 추정하는 알고리즘으로, 비선형 및 비가우시안 시스템에도 적용 가능한 장점이 있어 로봇 공학, 신호 처리, 금융 공학 등 다양한 분야에서 활용된다.

| 메트로폴리스-헤이스팅스 알고리즘 |

|---|

2. 역사

1953년 니컬러스 메트로폴리스와 동료들이 볼츠만 분포의 특별한 경우를 위해 메트로폴리스-헤이스팅스 알고리즘을 처음 제안하였고, 1970년 W.K. 헤이스팅스가 이를 일반화하였다.[1][2]

메트로폴리스-헤이스팅스 알고리즘은 확률 분포에서 난수열을 생성하는 방법이다. 이 알고리즘은 확률 밀도 함수(또는 확률 함수)에 비례하는 함수를 알고 있다면, 어떤 확률 분포에서도 난수열을 생성할 수 있게 해준다.[9][10] 이 방법은 특히 실제로는 계산하기 어려운 경우가 많은 확률 밀도의 정규화 인자를 계산할 필요가 없다는 장점이 있다.

알고리즘 개발에 대한 기여에 대해서는 약간의 논쟁이 있다. 마셜 로젠블루스는 자신과 아내 아리아나 W. 로젠블루스가 실제 작업을 수행했으며, 메트로폴리스는 컴퓨터 시간 제공 외에는 개발에 아무런 역할이 없었다고 주장한다. 에드워드 텔러는 회고록에서 1953년 논문의 다섯 명의 저자가 며칠 동안 함께 작업했다고 주장한다. 반대로, 로젠블루스의 상세한 설명은 텔러에게 초기 제안의 공을 돌리고, 자신에게는 문제를 해결한 공을, 아리아나에게는 컴퓨터 프로그래밍을 한 공을 돌렸다.

3. 알고리즘 설명

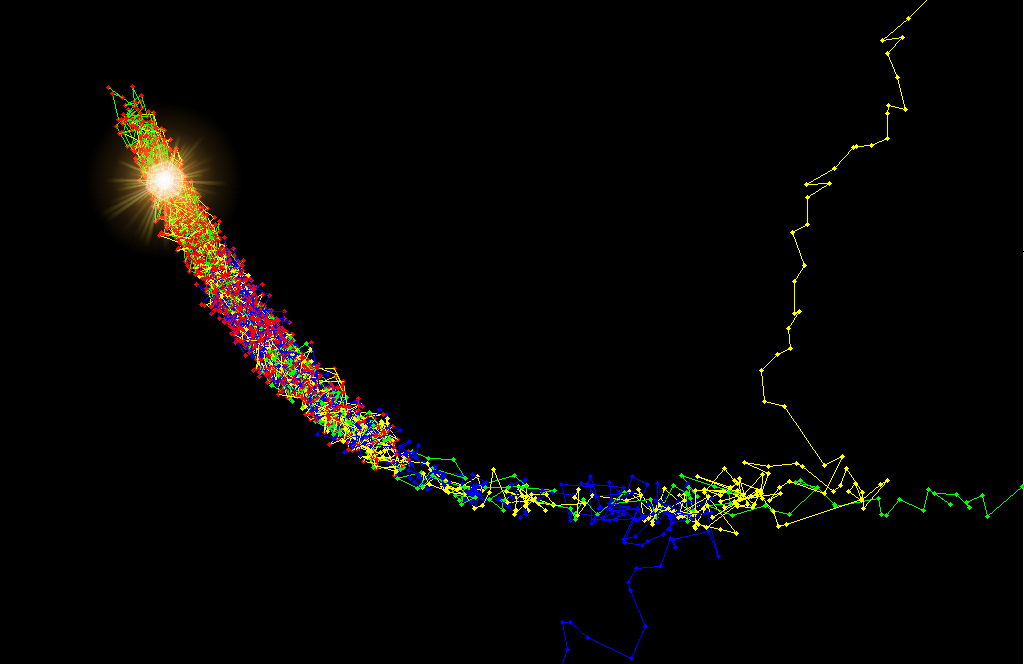

이 알고리즘은 다음 표본의 분포가 현재 표본 값에만 의존하는 마르코프 연쇄를 생성한다. 난수열의 길이가 길수록 목표 분포 P(x)를 더 잘 근사하게 된다. 반복 계산은 다음 상태 후보를 계산하고, 이를 채택하거나 기각하는 절차로 구성된다. 채택 확률은 P(x)에 관한 현재 상태와 다음 상태의 확률 밀도 함수를 비교하여 결정된다.

핵심 아이디어는 다음과 같다.

1. 무작위 이동: 표본 공간을 무작위로 이동하면서, 때로는 이동을 수락하고 때로는 제자리에 머무른다.

2. 채택률: 특정 점 x에서 P(x)는 알고리즘이 해당 점에 소요한 반복 횟수에 비례한다. 채택률은 새로운 제안된 표본이 현재 표본과 비교하여 얼마나 가능한지를 나타낸다.

3. 고밀도 영역 선호: 현재 점보다 더 가능성이 높은 점(즉, P(x)의 고밀도 영역)으로 이동하려고 하면 항상 이동을 수락한다. 덜 가능성이 높은 점으로 이동하려고 하면 때때로 이동을 거부하며, 확률의 상대적 감소가 클수록 새로운 점을 거부할 가능성이 더 커진다.

이러한 방식으로 알고리즘은 P(x)의 고밀도 영역에 머무르면서(많은 수의 표본을 반환) 가끔 저밀도 영역을 방문하는 경향을 보인다. 이것이 이 알고리즘이 작동하여 밀도 P(x)로 원하는 분포를 따르는 표본을 반환하는 이유이다.

하지만 다음과 같은 단점도 존재한다.

그럼에도 불구하고, 메트로폴리스-헤이스팅스 알고리즘은 기각 표본 추출과 같은 다른 방법에 비해 "차원의 저주"를 덜 겪기 때문에, 고차원 확률 분포에서 표본을 추출하는 데 유용한 방법이다.

3. 1. 메트로폴리스 알고리즘 (대칭 제안 분포)

를 목표 분포 의 확률 밀도 함수에 비례하는 함수로 정의한다.

1. 초기화: 초기값 과 제안 분포 를 결정한다. 제안 분포는 과거 상태 가 주어졌을 때, 후보 상태 를 생성하는 함수이다. 메트로폴리스 알고리즘에서는 는 대칭이어야 한다. 즉, 를 만족해야 한다. 일반적인 선택은 를 평균으로 하는 가우스 분포이며, 이 경우 근처의 값이 다음으로 선택되기 쉽다.

2. 번째 갱신:

이러한 반복 계산을 통해 난수는 상태 공간을 무작위로 이동하며, 때로는 이동을 수락하고 때로는 제자리에 머무른다. 채택률은 현재 상태와 다음 상태 후보의 확률 밀도 함수를 비교하여 생성된 후보가 얼마나 채택될 가능성이 높은지를 나타낸다. 현재 상태보다 다음 후보의 확률 밀도 함수가 높으면 항상 다음 상태를 채택한다. 그러나 다음 후보의 확률 밀도 함수가 높지 않은 경우, 때때로 이동하지 않고 후보를 기각한다. 따라서 높은 확률 밀도 함수 영역에서는 많은 난수를 생성하고, 낮은 확률 밀도 함수 영역에서는 적은 난수를 생성하게 된다. 이것이 이 알고리즘의 작동 원리이며, 목적 확률 분포에 따른 난수를 근사적으로 생성하는 방법이다.[3]

3. 2. 일반적인 메트로폴리스-헤이스팅스 알고리즘

확률 분포의 확률 밀도 에서 표본을 추출하는 메트로폴리스-헤이스팅스 알고리즘은, 확률 밀도 에 비례하는 함수 를 알고 있고 의 값을 계산할 수 있을 때 사용 가능하다. 가 정확히 와 같을 필요 없이 비례하기만 하면 되기 때문에, 정규화 인자를 계산할 필요가 없어 매우 유용하다.

메트로폴리스-헤이스팅스 알고리즘은 표본 값의 분포가 원하는 분포에 점차 근사되는 방식으로 표본 값의 시퀀스를 생성한다. 이 표본 값들은 반복적으로 생성되며, 다음 표본의 분포는 현재 표본 값에만 의존하는 마르코프 연쇄를 이룬다. 각 반복에서 알고리즘은 현재 표본 값을 기반으로 다음 표본 값에 대한 후보를 제안하고, 특정 확률로 후보를 수락하거나 거부한다. 후보가 수락되면 다음 반복에서 사용되고, 거부되면 현재 값이 다음 반복에서 재사용된다. 수락 확률은 현재 및 후보 표본 값의 함수 값을 비교하여 결정된다.

새로운 후보를 제안하는 방법은 이전 표본 가 주어졌을 때 새로운 제안된 표본 의 확률 분포 로 특징지어진다. 이를 "제안 밀도" 또는 "점핑 분포"라고 한다. 일반적인 선택은 를 중심으로 하는 가우스 분포이며, 이는 에 가까운 점이 다음에 방문될 가능성이 높게 만들어 표본의 시퀀스를 가우스 확률 보행으로 만든다.

제안 함수가 대칭인 메트로폴리스-헤이스팅스 알고리즘의 특수한 경우인 메트로폴리스 알고리즘은 다음과 같다.

;메트로폴리스 알고리즘(대칭 제안 분포):

를 원하는 확률 밀도 함수 에 비례하는 함수로 정의한다.

# 초기화: 표본에서 첫 번째 관측값으로 임의의 점 를 선택하고, 대칭적인 제안 함수 (를 만족)를 선택한다.

# 각 반복 ''t''에 대해:

#* 분포에서 다음 표본에 대한 후보 를 ''제안''한다.

#* 수락 비율 를 ''계산''한다. 는 의 밀도에 비례하므로, 이다.

#* ''수락 또는 거부'':

#** 균일한 난수 를 생성한다.

#** 이면 후보를 ''수락''하고 로 설정한다.

#** 이면 후보를 ''거부''하고 로 설정한다.

이 알고리즘은 표본 공간을 무작위로 이동하며, 때로는 이동을 수락하고 때로는 제자리에 머무른다. 수락 비율 는 새로운 제안된 표본이 현재 표본과 관련하여 얼마나 가능성이 높은지를 나타낸다. 현재 점보다 더 가능성이 높은 점으로 이동하는 경우 항상 이동을 수락하고, 덜 가능성이 높은 점으로 이동하는 경우 확률적으로 이동을 거부한다.

메트로폴리스-헤이스팅스 알고리즘은 다음과 같은 단점이 있다.

반면, 기각 표본 추출 방법은 "차원의 저주"를 겪는 반면, 메트로폴리스-헤이스팅스는 이러한 문제를 어느 정도 겪지 않아 고차원 분포에서 유용하다.

다변량 분포에서 고전적인 메트로폴리스-헤이스팅스 알고리즘은 새로운 다차원 표본점을 선택하는 것을 포함한다. 차원 수가 높을 때 적절한 점핑 분포를 찾는 것은 어려울 수 있다. 깁스 표본 추출은 각 차원에 대한 새로운 표본을 별도로 선택하여 이 문제를 해결한다.[5]

메트로폴리스-헤이스팅스 알고리즘의 목적은 원하는 분포 에 따라 일련의 상태를 생성하는 것이다. 이를 위해 마르코프 과정을 사용하며, 이는 점근적으로 인 고유한 정상 분포 에 도달한다.

마르코프 과정은 전이 확률 에 의해 정의된다. 고유한 정상 분포 를 가지려면 다음 두 가지 조건이 충족되어야 한다.

# ''정상 분포의 존재'': 상세 균형 조건()을 만족하면 충분하다.

# ''정상 분포의 고유성'': 에르고드성에 의해 보장된다.

메트로폴리스-헤이스팅스 알고리즘은 위 두 조건을 충족하는 마르코프 과정을 설계한다. 상세 균형 조건에서 시작하여 전이 확률을 제안 분포 와 수락 분포 의 곱으로 표현한다.

:

이를 통해 다음 관계를 얻는다.

:

일반적인 메트로폴리스 선택은 다음과 같다.

:

따라서 메트로폴리스-헤이스팅스 알고리즘은 다음과 같이 요약된다.

# 초기화: 초기 상태 를 선택하고 으로 설정한다.

# 반복:

저장된 상태 의 경험적 분포는 에 접근한다. 를 효과적으로 추정하는 데 필요한 반복 횟수()는 여러 요인에 따라 달라진다.[7]

일반적인 문제에서 어떤 분포 를 사용해야 하는지 또는 적절한 추정에 필요한 반복 횟수가 명확하지 않다는 점에 유의하는 것이 중요하다.

가장 최근에 추출된 값이 일 때, 메트로폴리스-헤이스팅스 알고리즘은 확률 밀도 로 새로운 제안 상태 를 추출하고 다음 값을 계산한다.

:

여기서

:

는 제안된 표본과 이전 표본 사이의 확률 비율이고,

:

는 두 방향의 제안 밀도 비율이다. 제안 밀도가 대칭이면 1과 같다. 그런 다음 새 상태 는 다음 규칙에 따라 선택된다.

: 이면:

:

: else:

:

마르코프 연쇄는 임의의 초기 값 에서 시작하며, 초기 상태가 "잊혀질" 때까지 알고리즘이 여러 번 반복된다. 버려지는 표본은 ''번인''이라고 한다. 남은 의 허용된 값 집합은 분포 에서 표본을 나타낸다.

알고리즘은 대상 분포 의 모양과 제안 밀도가 일치하는 경우 가장 잘 작동한다. 가우시안 제안 밀도 를 사용하는 경우, 분산 매개변수 는 번인 기간 동안 조정해야 한다. 이는 ''수용률''을 계산하여 수행된다. 원하는 수용률은 대상 분포에 따라 다르지만, 일차원 가우시안 분포의 경우 약 50%, 차원 가우시안 대상 분포의 경우 약 23%가 이상적이다.

가 너무 작으면 연쇄는 ''느리게 혼합''되고, 가 너무 크면 수용률이 매우 낮아진다.

4. 알고리즘의 장단점

메트로폴리스-헤이스팅스 알고리즘(M-H 알고리즘)은 확률 밀도 함수를 직접 계산하기 어려울 때, 그 함수에 비례하는 함수를 이용하여 원하는 확률 분포를 따르는 난수열을 생성하는 방법이다. 이는 통계학 및 통계물리학에서 상수배를 모르는 확률 밀도 함수로부터 난수를 생성해야 할 때 유용하게 사용된다.

M-H 알고리즘은 다음과 같은 장단점을 갖는다.

장점:

- 상수배를 모르는 확률 밀도 함수에서도 난수 생성이 가능하다. 이는 확률 밀도 함수의 정확한 형태를 알기 어려운 경우에 매우 유용하다.

- 알고리즘의 구조가 직관적이고, 구현이 비교적 간단하다.

단점:

- 생성된 난수열이 서로 상관관계를 가질 수 있다. 즉, 인접한 난수들이 독립적이지 않고 서로 영향을 줄 수 있다. 이 때문에 목표 확률 분포를 정확하게 근사하기 위해서는 많은 반복 계산이 필요할 수 있다. 상관관계를 줄이기 위해, 일정 간격으로 난수를 추출하거나, 다음 상태 후보를 현재 상태와 적절히 멀리 제안하는 방법 등이 사용될 수 있다.

- 반복 계산 초기에는 생성된 난수열이 목표 분포와 큰 차이를 보일 수 있다. 이를 '번인(burn-in)' 기간이라고 하며, 이 기간 동안 생성된 난수는 버리고, 일정 시간이 지난 후의 난수들만 사용하는 것이 일반적이다.

- 고차원 공간에서는 차원의 저주로 인해 효율성이 떨어질 수 있다. 이 경우, 깁스 샘플링 등 다른 방법을 고려해 볼 수 있다.

- 제안 분포의 선택이 알고리즘의 성능에 큰 영향을 미친다. 목표 분포와 유사한 형태의 제안 분포를 선택하는 것이 좋지만, 고차원 문제에서는 적절한 제안 분포를 찾기 어려울 수 있다.

5. 활용 분야

메트로폴리스-헤이스팅스 알고리즘(M-H 알고리즘)은 확률 분포에서 난수열을 생성하는 데 사용되며, 이는 통계학이나 통계물리학 등 다양한 분야에서 활용된다. 특히, 확률 밀도 함수의 상수배를 몰라도 난수 생성이 가능하다는 점이 큰 장점이다.

M-H 알고리즘으로 생성하는 난수열은 목표 분포를 근사하며, 이는 마르코프 연쇄의 원리를 이용한다. 즉, 다음 난수의 확률 분포는 현재 난수의 값에만 의존한다. 알고리즘의 핵심은 다음 상태 후보를 계산하고 채택 또는 기각하는 과정을 반복하는 것이다. 채택 확률은 현재 상태와 다음 상태 후보의 확률 밀도 함수를 비교하여 결정된다.

하지만 M-H 알고리즘에는 몇 가지 단점이 있다.

- 난수열이 상관관계를 가질 수 있다. 인접한 난수들은 서로 상관관계를 가지므로, 목표 분포를 정확하게 근사하려면 많은 반복 계산이 필요할 수 있다.

- 초기값이 목표 분포와 멀리 떨어져 있으면, 목표 분포에 수렴하는 데 시간이 오래 걸릴 수 있다.

이러한 단점에도 불구하고, M-H 알고리즘은 고차원 확률 분포를 다루는 데 효과적이다. 차원의 저주의 영향을 덜 받기 때문에, 계층적 베이즈 모델과 같은 고차원 통계 모델의 사후 분포를 근사하는 데 자주 사용된다.

고차원 문제에서는 깁스 샘플링과 같은 다른 방법들이 대안으로 사용될 수 있다. 깁스 샘플링은 각 차원별로 샘플링을 수행하여 느린 혼합 문제를 해결하는 데 도움을 줄 수 있다. 또한, 적응적 기각 샘플링, 일차원 M-H 스텝, 슬라이스 샘플링 등도 고려될 수 있다.

6. 관련 알고리즘

다음은 메트로폴리스-헤이스팅스 알고리즘과 관련된 알고리즘들이다.

- 깁스 샘플링: 모든 차원에 대해 한 번에 샘플링하는 대신, 각 차원별로 새로운 샘플을 선택한다. 다변량 분포에서 각 변수가 소수의 다른 변수에만 조건부로 지정된 경우에 유용하다.

- 해밀토니안 몬테카를로법

- 슬라이스 샘플링

- 담금질 기법

- 메트로폴리스법

- MTM 알고리즘

MCMC가 아닌 방법

- 역함수법: 구하려는 분포의 확률 밀도 함수의 역함수를 얻을 수 있는 경우에 사용한다.

- 기각 샘플링: 구하려는 분포에 비례하는 함수를 얻을 수 있는 경우에 사용한다.

- 적응적 기각 샘플링: 적응적으로 포락선을 정해 기각을 줄이는 방법이다.

- 중요도 샘플링: 중요도 가중치를 고려하여 기댓값을 얻는 방법이다.

- SIR sampling-importance-resampling

몬테카를로 EM 알고리즘: E-스텝을 샘플링으로 한 EM 알고리즘이다.

7. 추가 정보

마르코프 연쇄 몬테카를로(MCMC) 방법은 차원의 저주에 덜 민감하여 고차원 문제에 유용하다. 제안 분포의 선택은 알고리즘의 효율성에 큰 영향을 미치며, 알고리즘의 수렴 속도를 높이기 위한 다양한 개선 방법들이 연구되고 있다.

메트로폴리스-헤이스팅스 알고리즘은 다음과 같은 단점이 있다.

- 표본은 자기상관된다. 인접한 표본 집합은 서로 상관되어 분포를 올바르게 반영하지 않는다.

- 마르코프 연쇄는 결국 원하는 분포로 수렴하지만, 시작점이 저밀도 영역에 있는 경우 특히 초기 표본은 매우 다른 분포를 따를 수 있다. 결과적으로 초기 표본 수를 버리는 ''번인'' 기간이 일반적으로 필요하다.[4]

반면, 기각 표본 추출 방법은 차원 수의 함수로 기각 확률이 기하급수적으로 증가하는 "차원의 저주"를 겪는다. 메트로폴리스-헤이스팅스는 다른 MCMC 방법과 함께 이러한 문제를 어느 정도 겪지 않으므로, 추출할 분포의 차원 수가 높은 경우 종종 사용 가능한 유일한 솔루션이다.

다변량 분포에서 고전적인 메트로폴리스-헤이스팅스 알고리즘은 새로운 다차원 표본점을 선택하는 것을 포함한다. 차원 수가 높을 때, 적절한 점핑 분포를 찾는 것은 어려울 수 있다. 이러한 상황에서 더 나은 결과를 얻는 경우가 많은 대체 접근 방식인 깁스 표본 추출은 한 번에 모든 차원에 대한 표본을 선택하는 대신, 다른 차원과 별도로 각 차원에 대한 새로운 표본을 선택하는 것을 포함한다.

일반적인 문제에서 어떤 분포를 사용해야 하는지 또는 적절한 추정에 필요한 반복 횟수가 명확하지 않다는 점에 유의하는 것이 중요하다. 둘 다 특정 문제에 맞게 조정해야 하는 방법의 자유 매개변수이다.

가우시안 제안 밀도를 사용하는 경우, 분산 매개변수는 번인 기간 동안 조정해야 한다. 이는 일반적으로 ''수용률''을 계산하여 수행된다. 원하는 수용률은 대상 분포에 따라 다르지만, 일차원 가우스 분포의 이상적인 수용률은 약 50%이고, 다차원 가우스 대상 분포의 경우 약 23%로 감소하는 것으로 이론적으로 밝혀졌다.

분산 매개변수가 너무 작으면 연쇄는 ''느린 혼합''이 된다. 반면에, 분산 매개변수가 너무 크면 수용률이 매우 낮아져 연쇄가 매우 느리게 수렴한다. 일반적으로 알고리즘이 모든 표본의 약 30%를 수용하도록 제안 분포를 조정한다.

참조

[1]

서적

Monte Carlo Methods Volume I: Basics

Wiley

[2]

논문

Markov chains for exploring posterior distributions

https://projecteucli[...]

1994

[3]

논문

Adaptive Rejection Sampling for Gibbs Sampling

1992-01-01

[4]

서적

Bayesian data analysis

Chapman & Hall / CRC

2004

[5]

논문

Gibbs sampler and coordinate ascent variational inference: A set-theoretical review

[6]

논문

Adaptive Rejection Metropolis Sampling within Gibbs Sampling

1995-01-01

[7]

간행물

How Many Iterations in the Gibbs Sampler?

[8]

논문

Optimal scaling of random walk Metropolis algorithms using Bayesian large-sample asymptotics

2022-04-15

[9]

논문

Equation of State Calculations by Fast Computing Machines

[10]

논문

Monte Carlo Sampling Methods Using Markov Chains and Their Applications

[11]

서적

Monte Carlo Statistical Methods

Springer

[12]

서적

Ergodic Behavior of Markov Processes: With Applications to Limit Theorems

De Gruyter

[13]

서적

Monte Carlo Methods in Statistical Physics

Oxford University Press

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com