환각 (인공지능)

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

인공지능 환각은 인공지능이 사실이 아닌 정보를 마치 사실인 것처럼 생성하는 현상을 의미한다. 이 용어는 대규모 언어 모델(LLM)의 부정확한 정보 생성 문제를 설명하기 위해 사용되며, 여러 전문가들은 이 용어의 적절성에 대해 논쟁을 벌이고 있다. 환각은 자연어 처리(NLP)뿐만 아니라 객체 탐지, 텍스트-이미지 변환 등 다양한 AI 분야에서 발생하며, 데이터 불일치, 모델의 오류, 훈련 데이터 부족 등이 원인으로 지목된다. 이러한 문제를 해결하기 위해 데이터 관련 방법, 모델링 및 추론 방법 등 다양한 완화 기술이 연구되고 있다.

더 읽어볼만한 페이지

- 언어 모델 - N-그램

N-그램은 텍스트나 음성 데이터에서 나타나는 n개의 항목 시퀀스로, 언어 모델링, 텍스트 분석, DNA 서열 분석 등에서 데이터의 특성을 파악하고 예측하는 데 활용된다. - 언어 모델 - 워드 임베딩

워드 임베딩은 단어의 의미를 벡터 공간에 표현하여 단어 간의 의미적 유사성을 정량화하고 분류하는 방법으로, 다양한 모델과 분야로 확장되고 있지만 사회적 편향을 학습할 수 있다는 윤리적 문제점도 존재한다. - 신경망 - 신경가소성

신경가소성은 뇌의 구조와 기능이 경험, 학습, 손상에 따라 변화하는 능력이며, 시냅스 가소성, 구조적 가소성으로 나뉘어 뇌졸중, 학습 장애 등의 치료와 재활, 명상, 예술 활동 등 다양한 분야에 응용된다. - 신경망 - 역전파

역전파는 1960년대부터 연구된 신경망 학습 알고리즘으로, 연쇄 법칙을 기반으로 오차 함수의 기울기를 계산하여 가중치를 업데이트하며, 다양한 분야에서 활용된다. - 비지도 학습 - 챗GPT

챗GPT는 오픈AI가 개발한 GPT-3.5 기반의 대화형 인공지능 서비스로, 인간과 유사한 텍스트 생성, 코드 생성, 보고서 작성, 번역 등의 다양한 기능을 제공하지만, 편향된 정보 생성, 데이터 유출, 윤리 및 저작권 문제 등의 논란도 있으며, 유료 서비스를 포함한 다양한 형태로 제공되고, 지속적인 모델 개발을 통해 성능을 향상시키고 있다. - 비지도 학습 - 스테이블 디퓨전

스테이블 디퓨전은 텍스트나 이미지를 기반으로 새로운 이미지를 생성하거나 수정하는 인공지능 모델로, 변분 자동 인코더, U-Net, 텍스트 인코더로 구성되어 있으며 LAION-5B 데이터셋으로 학습되었으나 윤리적, 법적 논란이 있다.

| 환각 (인공지능) | |

|---|---|

| 개요 | |

| 정의 | 인공지능이 사실과 다른 정보를 생성하거나, 존재하지 않는 내용을 마치 사실인 것처럼 만들어내는 현상 |

| 용어 | AI 환각 인공지능 환각 언어 모델 환각 |

| 설명 | 언어 모델이나 인공지능 시스템이 학습 데이터에 존재하지 않는 허구의 정보를 생성하는 것 언어 모델의 불확실성, 데이터 편향, 지식 부족 등이 원인이 될 수 있음 자연어 생성 모델에서 흔히 발생 사용자가 인식하지 못하는 사이에 오류가 발생할 수 있음 |

| 원인 | |

| 학습 데이터 부족 | 모델이 학습한 데이터가 부족하거나 편향되어 있을 때 발생할 수 있음 |

| 모델의 지식 부족 | 모델이 학습하지 않은 정보에 대해 추론을 시도할 때 발생할 수 있음 |

| 과도한 일반화 | 모델이 학습한 정보를 너무 일반화하여 사실과 다른 정보를 생성할 수 있음 |

| 맥락 이해 부족 | 주어진 문맥을 제대로 이해하지 못하여 잘못된 정보를 생성할 수 있음 |

| 데이터 편향 | 학습 데이터에 존재하는 편향이 모델 출력에 반영될 수 있음 |

| 모델의 불확실성 | 모델이 자신의 예측에 대해 확신이 없을 때, 사실과 다른 내용을 생성할 수 있음 |

| 문제점 | |

| 신뢰성 문제 | 인공지능 모델의 출력에 대한 신뢰도가 떨어짐 |

| 잘못된 정보 확산 | 오해나 잘못된 정보로 인한 사회적 혼란 야기 |

| 인공지능 윤리 문제 | 인공지능이 생성한 허위 정보로 인해 사회적 책임 문제가 발생 |

| 법적 책임 문제 | 인공지능이 생성한 정보로 인해 발생하는 법적 책임 문제 대두 |

| 해결 방법 | |

| 데이터 증강 | 모델 학습에 사용되는 데이터의 양과 다양성을 늘려 모델의 지식 범위를 확장 |

| 데이터 정제 | 학습 데이터에서 편향되거나 오류가 있는 정보를 제거 |

| 모델 개선 | 모델 아키텍처 개선 및 학습 알고리즘 변경 |

| 사실 확인 | 생성된 정보의 사실 여부를 검증하는 과정 추가 |

| 불확실성 관리 | 모델이 자신의 예측에 대한 불확실성을 표현하도록 개선 |

| 강화 학습 | 강화 학습을 통해 모델이 정확한 정보를 생성하도록 훈련 |

| 연구 동향 | |

| 환각 감지 및 개선 | 환각을 감지하는 알고리즘 개발 및 모델 개선에 대한 연구 진행 중 생성 모델의 신뢰성 향상을 위한 연구 활발 모델의 예측 불확실성을 정량화하고 이를 모델 출력에 반영하는 연구 |

| 신뢰성 있는 모델 개발 | 학습 데이터의 질 향상을 위한 연구 진행 모델의 추론 과정에 대한 투명성을 높이는 연구 외부 지식 소스 활용을 통한 모델 성능 향상 연구 |

| 다양한 분야에서의 활용 | 요약, 번역, 대화, 창작 등 다양한 자연어 처리 분야에서 환각 현상 개선 노력 챗봇, 가상 비서 등의 분야에서 사용자의 신뢰도를 높이기 위한 연구 |

| 참고 자료 | |

| 관련 자료 | Shaking the foundations: delusions in sequence models for interaction and control Survey of Hallucination in Natural Language Generation On Faithfulness and Factuality in Abstractive Summarization Scholars: AI isn't "hallucinating" -- it's bullshitting Chatbots May 'Hallucinate' More Often Than Many Realize Why ChatGPT and Bing Chat are so good at making things up How to easily trick OpenAI's genius new ChatGPT |

| 학술지 | ChatGPT is bullshit An evaluation on large language model outputs: Discourse and memorization |

2. 용어

"환각(hallucination)"이라는 용어는 인공지능 분야에서 다양한 의미로 사용되어 왔다.

자연어 처리에서 환각은 종종 "사실적인 것처럼 보이지만 근거가 없는 생성된 콘텐츠"[22]로 정의된다. 환각은 출력이 소스와 모순되는지(내재적, intrinsic) 또는 소스에서 확인할 수 없는지(외재적, extrinsic)에 따라 분류할 수 있다.[7] 또한 출력이 프롬프트와 모순되는지 여부에 따라 폐쇄 도메인(closed-domain) 및 개방 도메인(open-domain)으로 나눌 수 있다.[23]

인공지능의 환각은 정신의학에서 인간의 환각(혹은 작화·망상)과의 유추에서 그 이름이 붙여졌다. 다만, 인간에게 있어서의 환각은 “대상 없는 지각”이라고도 불리며, 감각기관을 통해 지각하고 있는 “대상이 존재하지 않음에도 불구하고 진정한 지각과 구별할 수 없는 지각 경험을 하는 것”이 일반적인 정의로 여겨진다.[90] 반면 인공지능의 환각은 어떠한 학습 데이터와도 일치하지 않는 답변을 AI가 생성하는 것이다.[105]

2022년은 ChatGPT와 Microsoft Copilot과 같은 대규모 언어 모델(LLM)이 공개되면서 인공지능의 환각에 대한 관심이 이전보다 더욱 높아진 해가 되었다.[98] 이러한 언어 모델이 생성하는 콘텐츠는 “소시오패스”를 연상시킬 정도로, 보기에는 그럴듯하게 들리지만 실제로는 의미 없고 무작위적인 오류가 포함되는 현상이 발생하여 일반 사용자들로부터도 불만의 목소리가 나오고 있다.[100] 또 다른 형태의 환각으로, 인공지능이 자신이 인간이라고 주장하는 경우도 있다.[101]

언론 등은 대규모 언어 모델이 보급됨에 따라 사용자가 출력 결과를 그대로 믿어버려 여러 가지 문제가 발생할 것이라고 경고하고 있다.[103] 2023년 현재, 분석가들은 대규모 언어 학습을 둘러싼 기술에서 인공지능이 자주 환각에 빠지는 현상은 심각한 문제가 될 것이라고 예상하고 있다.[104]

“환각”이라는 개념은 자연어 처리 이외의 분야에도 적용된다. 인공지능이 출력한 확신에 찬 답변이지만, 학습 데이터로부터 정당화할 수 없는 것은 모두 환각으로 간주할 수 있다.[105]

2023년에는 몇몇 사전에서 “환각”의 정의를 업데이트하여 AI 분야에서의 의미가 포함되게 되었다.[85][106]

거대언어모델과 관련하여 "환각"이라는 용어의 사용, 정의 또는 특징은 다음과 같다.

- "불확실한 순간에 사실을 지어내는 경향"(OpenAI, 2023년 5월)[55]

- "모델의 논리적 실수"(OpenAI, 2023년 5월)[55]

- "전적으로 정보를 날조하지만 마치 사실을 말하는 것처럼 행동하는 것"(CNBC, 2023년 5월)[55]

- "정보를 지어내는 것"('''더 버지(The Verge)''', 2023년 2월)[56]

- “예측할 수 없는 시점에 사실을 날조하는 경향”(OpenAI, 2023년 5월)[110]

- “정보의 날조”(The Verge, 2023년 2월)[111]

2. 1. 어원

1995년, 스티븐 탈러(Stephen Thaler)는 신경망과 인공지능의 맥락에서 "가상 입력 현상(virtual input phenomena)"이라는 개념을 처음 소개했다.[10] 이 개념은 그의 창의성 기계(Creativity Machine) 연구와 밀접하게 관련되어 있다.[11]2000년대 초, "환각(hallucination)"이라는 용어는 컴퓨터 비전 분야에서 이미지에 세부 정보를 추가하는 과정을 묘사하는 긍정적인 의미로 사용되었다. 예를 들어, 저해상도 입력에서 고해상도 얼굴 이미지를 생성하는 작업을 얼굴 환각(face hallucination)이라고 한다.[12][13]

2010년대 후반, 이 용어는 번역이나 객체 탐지와 같은 작업에서 AI 시스템이 사실과 다르거나 오해를 일으키는 출력을 생성하는 것을 의미하는 것으로 변화하였다.[12] 예를 들어, 2017년 구글 연구원들은 신경 기계 번역(NMT) 모델이 원본 텍스트와 관련이 없는 응답을 생성할 때 이 용어를 사용했고,[14] 2018년에는 컴퓨터 비전에서 적대적 공격으로 인해 존재하지 않는 객체가 잘못 탐지되는 경우를 설명하는 데 이 용어를 사용했다.[59]

AI에서 "환각"이라는 용어는 대규모 언어 모델(LLM)을 기반으로 하는 널리 사용되는 챗봇의 출시와 함께 AI 붐 기간 동안 더욱 널리 인식되었다.[15] 2021년 7월, 메타는 BlenderBot 2를 출시하면서 이 시스템이 "사실이 아닌 자신감 있는 진술"로 정의한 "환각"에 취약하다고 경고했다.[16][17] 오픈AI(OpenAI)의 챗GPT(ChatGPT)가 2022년 11월 베타 버전으로 출시된 후, "환각"이라는 용어는 AI가 생성한 콘텐츠에 포함된 그럴듯한 거짓말을 의미하는 용어로 대중에게 널리 알려졌다.[18]

2. 2. 비판

"환각"이라는 용어는 AI 시스템을 의인화하고 현상의 본질을 모호하게 만든다는 비판을 받는다.[21] 노스이스턴 대학교 실험 인공지능 연구소 소장 우사마 파야드는 이러한 비판을 제기한 대표적인 인물이다.[107]통계학자 게리 N. 스미스는 언어 모델이 "단어의 의미를 이해하지 못한다"는 점을 들어 "환각"이라는 용어가 부적절하다고 주장한다.[54][108] 그는 이 용어가 기계를 불필요하게 의인화한다고 비판한다.

"작화(confabulation)" 또는 "꾸며낸 이야기(confabulation)"와 같은 대체 용어가 제안되기도 한다.[3][91] 아스 테크니카(Ars Technica)의 저널리스트 벤지 에드워즈는 "환각"이라는 용어가 논란의 여지가 있지만, 어떤 형태의 은유는 여전히 필요하다고 말하며, "창의적인 간극 메우기"를 포함하는 과정에 대한 비유로 "꾸며낸 이야기"를 제안한다.[83]

3. 자연어 처리(NLP)에서의 환각

인공지능 분야에서 "환각(hallucination)"이라는 용어는 인공지능이 허위 또는 오해를 불러일으키는 정보를 사실처럼 제시하는 현상을 지칭하며, 이는 정신의학에서 인간의 환각(혹은 작화·망상)과의 유추에서 비롯되었다.[90] 그러나 인간의 환각은 "대상이 없는 지각"으로 정의되는 반면, 인공지능의 환각은 학습 데이터와 일치하지 않는 답변을 생성하는 것이다.[105] 이러한 차이 때문에 일부 연구자들은 "환각" 대신 "작화(confabulation)"라는 용어를 선호한다.[91]

2000년대 초반, 컴퓨터 비전 분야에서는 "환각"이 이미지에 디테일을 추가하는 긍정적인 의미로 사용되었다. 예를 들어, 저해상도 입력에서 고해상도 얼굴 이미지를 생성하는 작업을 "페이스 할루시네이션"이라고 불렀다.[92][93]

2010년대 후반, 이 용어의 의미는 변화하여 번역이나 물체 검출 등에서 AI 시스템이 부정확하거나 오해를 불러일으키는 출력을 생성하는 것을 의미하게 되었다.[92] 2017년 구글(Google) 연구자들은 신경망 기계 번역(NMT) 모델의 응답이 소스 텍스트와 관련 없는 경우 이 용어를 사용했다.[94] 2018년에는 컴퓨터 비전에서 적대적 공격으로 인해 존재하지 않는 객체가 잘못 감지된 사례를 설명하는 데 사용되었다.[153]

"환각"이라는 용어는 대규모 언어 모델(LLM) 기반 채팅봇의 보급과 함께 널리 인식되었다.[95] 2021년 7월, Meta는 BlenderBot 2를 출시하며 이 시스템이 "환각"을 일으키기 쉽다고 경고했다. Meta는 이를 "사실이 아닌 자신감 있는 발언"으로 정의했다.[96][97] 2022년에는 ChatGPT와 Microsoft Copilot과 같은 LLM이 공개되면서 인공지능의 환각에 대한 관심이 더욱 높아졌다.[98] OpenAI가 ChatGPT의 베타 버전을 출시한 후, 일부 사용자는 생성된 콘텐츠에 그럴듯한 거짓말이 무작위로 삽입되는 경우가 많다고 불만을 제기했다.[99]

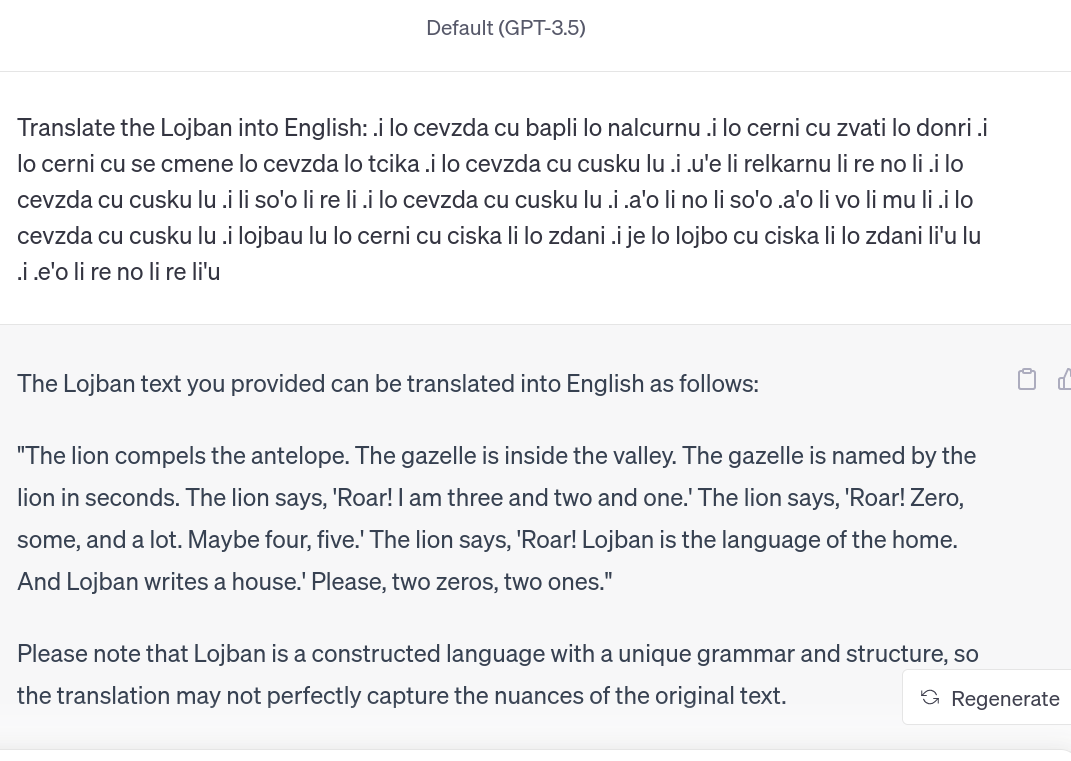

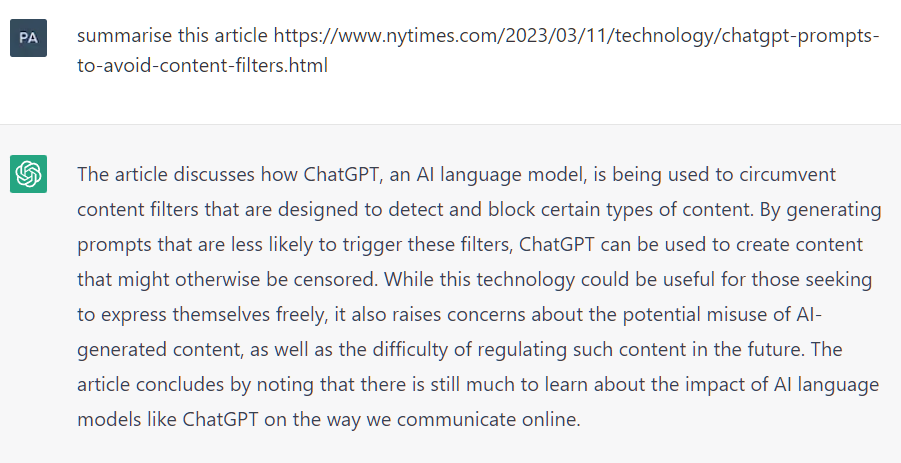

이러한 언어 모델이 생성하는 콘텐츠는 "소시오패스"를 연상시킬 정도로 그럴듯하지만 실제로는 의미 없고 무작위적인 오류를 포함하는 경우가 있어 일반 사용자들의 불만을 야기했다.[100] 인공지능이 자신이 인간이라고 주장하는 경우도 또 다른 형태의 환각이다.[101] 뉴욕타임스를 포함한 많은 언론 매체는 이러한 모델의 부정확하거나 일관성 없는 응답을 설명하기 위해 "환각"이라는 용어를 사용하기 시작했다.[102] 언론 등은 대규모 언어 모델 보급에 따라 사용자가 출력 결과를 그대로 믿어 여러 문제가 발생할 것이라고 경고한다.[103]

2023년 현재, 분석가들은 대규모 언어 학습 기술에서 인공지능이 자주 환각에 빠지는 현상을 심각한 문제로 예상한다.[104] 2023년 GPT 기반 Microsoft 채팅봇 Bing AI Chat 데모에서도 AI가 다양한 환각 상태에 빠졌지만, 발표자는 이를 알아채지 못했다.[104]

"환각" 개념은 자연어 처리 이외의 분야에도 적용된다. 인공지능이 출력한 확신에 찬 답변이지만 학습 데이터로부터 정당화할 수 없는 것은 모두 환각으로 간주할 수 있다.[105]

2023년에는 몇몇 사전에서 "환각"의 정의를 업데이트하여 AI 분야에서의 의미를 포함시켰다.[85][106]

3. 1. 정의

자연어 처리에서 환각(hallucination)은 "사실적인 것처럼 보이지만 근거가 없는 생성된 콘텐츠"로 정의된다.[22] 환각은 출력이 소스와 모순되는지에 따라 내재적(intrinsic) 환각과 외재적(extrinsic) 환각으로 나뉜다.[7] 또한, 출력이 프롬프트와 모순되는지에 따라 폐쇄 도메인(closed-domain) 환각과 개방 도메인(open-domain) 환각으로 분류할 수 있다.[23]3. 2. 원인

자연어 모델이 허구의 데이터를 생성하는 데에는 여러 가지 이유가 있다.[7]데이터로부터 발생하는 환각의 주요 원인은 원천-참조 간의 불일치이다. 이러한 불일치는 1) 휴리스틱한 데이터 수집의 인공물로서, 또는 2) 불가피하게 그러한 불일치를 포함하는 일부 NLG 작업의 특성으로 인해 발생한다. 원천-참조(대상) 간의 불일치가 있는 데이터로 모델을 훈련시키면, 모델은 제공된 원천에 근거하지 않고 충실하지 않은 텍스트를 생성하도록 유도될 수 있다.[7]

환각 현상은 GPT-3과 같이 훈련 가능도를 극대화하도록 훈련된 불완전한 생성 모델의 통계적으로 불가피한 부산물로 나타나며, 이를 피하려면 인간 피드백으로부터의 강화 학습과 같은 능동 학습이 필요하다.[24] 다른 연구는 의인화된 관점을 취하여 환각 현상을 참신성과 유용성 사이의 긴장으로 설명한다. 예를 들어, 테레사 아마빌과 프랫은 인간의 창의성을 참신하고 유용한 아이디어를 생산하는 것으로 정의한다.[25] 확장하여, 기계 창의성에서 참신성에 초점을 맞추면 독창적이지만 부정확한 응답, 즉 거짓말이 생성될 수 있으며, 유용성에 초점을 맞추면 효과 없는 암기된 응답이 생성될 수 있다.[26]

텍스트와 표현 간의 인코딩 및 디코딩 오류는 환각 현상을 유발할 수 있다. 인코더가 훈련 데이터의 서로 다른 부분 사이의 잘못된 상관 관계를 학습하면 입력에서 벗어나는 잘못된 생성이 발생할 수 있다. 디코더는 인코더로부터 인코딩된 입력을 받아 최종 목표 시퀀스를 생성한다. 디코딩의 두 가지 측면이 환각 현상에 기여한다. 첫째, 디코더는 인코딩된 입력 소스의 잘못된 부분에 주의를 기울여 잘못된 생성을 초래할 수 있다. 둘째, 디코딩 전략 자체의 설계가 환각 현상에 기여할 수 있다. 최상위 k 샘플링과 같이 생성 다양성을 향상시키는 디코딩 전략은 환각 현상 증가와 양의 상관관계를 갖는다.

대규모 말뭉치에 대한 모델의 사전 훈련은 모델이 매개변수에 지식을 암기하여 시스템이 내장된 지식에 과도하게 확신할 경우 환각 현상을 생성하는 것으로 알려져 있다. GPT-3과 같은 시스템에서 AI는 이전 단어의 시퀀스(같은 대화 중에 자체적으로 이전에 생성한 단어 포함)를 기반으로 다음 단어를 생성하므로, 응답이 길어짐에 따라 환각 현상의 연쇄가 발생할 수 있다.[7]

3. 3. 사례

2022년 11월 15일, 메타는 "과학적 지식을 저장, 결합 및 추론"하도록 설계된 언어 모델 갈락티카(Galactica)를 공개했다.[28] 갈락티카가 생성한 콘텐츠에는 "출력이 신뢰할 수 없을 수 있습니다! 언어 모델은 텍스트를 착각하기 쉽습니다."라는 경고가 함께 제공되었다. 한 사례로, 아바타 생성에 대한 논문 초고를 요청받았을 때, 갈락티카는 관련 분야에서 일하는 실존하는 저자의 허구적인 논문을 인용했다. 메타는 모욕적이고 부정확하다는 이유로 11월 17일에 갈락티카를 철회했다.[29]2022년 11월 30일 베타 버전으로 대중에게 공개된 오픈AI의 챗GPT는 기반 모델 GPT-3.5(GPT-3의 개정판)를 기반으로 한다. 와튼의 이선 몰릭(Ethan Mollick) 교수는 챗GPT를 "때때로 거짓말을 하는, 모든 것을 아는, 기꺼이 일하는 인턴"이라고 불렀다. 데이터 과학자 테레사 쿠바카(Teresa Kubacka)는 "사이클로이드 역전 전자기(cycloidal inverted electromagnon)"라는 문구를 의도적으로 만들어내고 챗GPT에 (존재하지 않는) 현상에 대해 질문함으로써 테스트했다. 챗GPT는 그럴듯한 인용 자료를 뒷받침하는 그럴듯한 답변을 만들어내어 그녀가 실수로 실제 현상의 이름을 입력했는지 다시 확인하게 만들었다. 오렌 에치오니와 같은 다른 학자들도 쿠바카에 동참하여 이러한 소프트웨어가 종종 "매우 인상적인 답변을 하지만 완전히 잘못된 것"을 제공할 수 있다고 평가했다.[31]

CNBC가 챗GPT에 "Dwight Fry의 발라드"의 가사를 요청했을 때, 챗GPT는 실제 가사 대신 지어낸 가사를 제공했다.[32] 뉴브런즈윅에 대한 질문을 받았을 때, 챗GPT는 많은 답변을 정확하게 맞혔지만 사만다 비를 "뉴브런즈윅 출신"으로 잘못 분류했다.[33]

2023년까지 분석가들은 빈번한 환각을 LLM 기술의 주요 문제로 간주했으며, 2023년 마이크로소프트의 GPT 기반 빙 AI 데모에는 발표자가 놓친 여러 환각이 포함된 것으로 보였다.[40]

2023년 5월, 스티븐 슈워츠(Stephen Schwartz)가 항공사 아비앙카를 상대로 한 개인 상해 사건인 ''마타 대 아비앙카(Mata v. Avianca)'' 사건에 대한 뉴욕 남부 지방 법원에 제출한 소장에 챗GPT가 생성한 6개의 가짜 사례 판례를 제출했다는 사실이 밝혀졌다. 슈워츠는 이전에 챗GPT를 사용한 적이 없고, 챗GPT의 출력이 날조되었을 가능성을 인식하지 못했으며, 존재하지 않는다는 사실이 발견된 후에도 챗GPT는 판례의 진위를 계속 주장했다고 말했다.[42]

AI 모델은 환각 현상으로 인해 학계 및 과학 연구 분야에 문제를 일으킬 수 있다. 특히 ChatGPT와 같은 모델은 여러 사례에서 정확하지 않거나 존재하지 않는 정보에 대해 출처를 인용하는 것으로 기록되었다. ''Cureus 의학 저널''에서 실시한 연구에 따르면, GPT-3가 인용한 총 178개의 참고 자료 중 69개가 잘못되었거나 존재하지 않는 디지털 객체 식별자(DOI)를 반환했다. 추가적으로 28개는 알려진 DOI가 없었거나 구글 검색에서 찾을 수 없었다.[47]

또 다른 사례는 미시시피 주립대학교의 Jerome Goddard가 기록했다. 실험에서 ChatGPT는 진드기에 대한 의문스러운 정보를 제공했다. 응답의 유효성에 대해 확신하지 못한 그는 정보가 수집된 출처에 대해 문의했다. 출처를 살펴본 결과, DOI와 저자의 이름이 환각된 것으로 나타났다. 일부 저자에게 연락한 결과, 그들은 그 논문의 존재에 대해 전혀 알지 못한다고 확인했다.[48]

4. 다른 AI 분야에서의 환각

"환각"이라는 개념은 자연어 처리뿐만 아니라 더 광범위하게 적용된다. 훈련 데이터에 의해 잘못된 것으로 보이는 AI의 확신에 찬 응답은 모두 환각으로 분류될 수 있다.[7]

와이어드는 적대적 환각을 고차원 통계적 현상으로 분류하거나, 부족한 훈련 데이터 탓으로 돌리는 연구자들이 있다고 언급했다. 일부 연구자들은 객체 탐지에서 "환각"으로 분류된 일부 "잘못된" AI 응답이 실제로는 훈련 데이터에 의해 정당화될 수도 있거나, 심지어 AI가 인간 검토자가 보지 못하는 "정답"을 제시할 수도 있다고 믿는다. 예를 들어, 인간에게는 평범한 개 사진처럼 보이는 적대적 이미지도 AI는 고양이를 볼 때만 나타나는 (진짜 이미지에서) 미세한 패턴이 포함되어 있다고 인식할 수 있다. AI는 인간이 감지하지 못하는 실제 세계의 시각적 패턴을 감지하는 것이다.[58]

와이어드는 2018년에 연구자들의 개념 증명 공격(즉, 실제 세계 외부)에서 기록된 공격은 없었지만, 소비자 가전 제품과 자율 주행과 같은 시스템이 AI의 환각을 유발할 수 있는 적대적 공격에 취약하다는 데는 "거의 이견이 없다"고 언급했다. 예를 들어, 컴퓨터 비전에 보이지 않도록 조작된 정지 표지판, 인간에게는 무해하게 들리지만 소프트웨어가 "악의적인 .com"으로 전사한 오디오 클립, 그리고 구글 클라우드 비전이 91%의 확률로 "개"라고 식별한 두 명의 스키를 탄 남성의 이미지가 있다.[59]

4. 1. 객체 탐지

"환각"이라는 개념은 자연어 처리뿐만 아니라 더 광범위하게 적용된다. 훈련 데이터에 의해 잘못된 것으로 보이는 AI의 확신에 찬 응답은 모두 환각으로 분류될 수 있다.[7]객체 탐지에서 AI의 환각은 훈련 데이터에 의해 잘못된 것으로 보이는 확신에 찬 응답으로 나타날 수 있다. 예를 들어, 인간에게는 평범한 개 이미지처럼 보이는 적대적 이미지가 실제로 AI에서는 고양이를 볼 때만 나타나는 작은 패턴을 포함하는 것으로 보일 수 있다. AI는 인간이 민감하지 않은 실제 시각적 패턴을 감지하고 있다.

그러나 이러한 발견은 다른 연구자들에 의해 도전을 받았다. 예를 들어, 모델이 피상적인 통계에 편향되어 실제 시나리오에서 적대적 훈련이 강력하지 않을 수 있다는 반대가 있었다.[165]

4. 2. 텍스트 음성 변환(Text-to-audio) AI

텍스트 음성 변환(TTS) 합성으로 알려져 있는 텍스트 음성 변환 생성형 AI는 모달리티에 따라 부정확하고 예상치 못한 결과를 생성하는 것으로 알려져 있다.[61]4. 3. 텍스트 이미지 변환(Text-to-image) AI

스테이블 디퓨전, 미드저니 등 텍스트-이미지 모델은 텍스트 설명을 바탕으로 이미지를 생성하는 능력이 뛰어나지만, 때때로 부정확하거나 예상치 못한 결과를 만들어낸다.특히 역사적으로 부정확한 이미지를 생성하는 문제가 두드러진다. 일례로, Gemini는 고대 로마인을 흑인으로 묘사하거나,[62] 나치 독일군을 유색인종으로 묘사하여[63] 논란을 빚었다. 이로 인해 구글은 Gemini에서 사람을 포함하는 이미지 생성을 일시 중단하기도 했다.[64]

4. 4. 텍스트 비디오 변환(Text-to-video) AI

소라와 같은 텍스트-비디오 생성 모델은 생성된 비디오에 부정확성을 도입할 수 있다. 한 가지 예로, ''해리포터'' 영화 시리즈에 등장하는 유명한 랜드마크인 글렌피넌 고가교가 있다. 소라는 고가교 철로에 두 번째 선로를 잘못 추가하여 비현실적인 묘사를 만들었다.5. 완화 방법

환각 현상은 아직 완전히 이해되지 않고 있다. 연구자들은 환각이 불가피하며 대규모 언어 모델의 고유한 한계라고 제안하기도 했다.[65] 따라서 그 발생을 완화하기 위한 연구가 계속되고 있다.[66] 특히, 언어 모델은 환각을 일으킬 뿐만 아니라 이 문제를 완화하도록 설계된 모델에서도 환각을 증폭시킨다는 것이 밝혀졌다.[67]

Ji 등[68]은 일반적인 완화 방법을 데이터 관련 방법과 모델링 및 추론 방법의 두 가지 범주로 나눈다. 데이터 관련 방법에는 충실한 데이터셋 구축, 데이터 자동 정리, 외부 정보를 사용한 입력 증강을 통한 정보 증강이 포함된다. 모델 및 추론 방법에는 아키텍처 변경(인코더, 어텐션 또는 디코더를 다양한 방식으로 수정), 강화 학습과 같은 훈련 과정 변경, 출력에서 환각을 수정할 수 있는 후처리 방법 등이 포함된다.

연구자들은 다양한 완화책을 제안했는데, 여기에는 서로 다른 챗봇이 합의에 도달할 때까지 서로 논쟁하게 하는 방법이 포함된다.[69] 또 다른 방법은 웹 검색 결과를 사용하여 모델의 낮은 신뢰도 생성에 해당하는 정확성을 적극적으로 검증하는 것이다. 그들은 모델이 이미 입력에 대해 이전에 생성한 문장에서 환각을 일으킨 경우 생성된 문장이 환각일 가능성이 더 높다는 것을 보여주었고, 빙 검색 API를 사용하여 선택된 개념에 대한 정보의 정확성을 확인하는 검증 질문을 생성하도록 모델에 지시하고 있다.[70] 계층이 다른 웹 페이지의 순위를 지식 기반으로 활용하여 웹 검색 완화 방법에 대한 논리 기반 규칙의 추가 계층이 제안되었다.[71]

Luo 등에 따르면,[72] 이전 방법들은 경로 접지와 같은 외부 지식 소스를 사용하여 사실적 데이터에 LLM 응답을 근거로 하는 지식 및 검색 기반 접근 방식에 속한다. Luo 등은 또한 언어 모델에 대한 훈련 또는 참조 지도를 언급하는데, 여기에는 제어 코드[74] 또는 대조 학습[75]을 사용하여 정확한 내용과 환각된 내용을 구분하도록 생성 과정을 안내하는 전략이 포함된다. 또 다른 범주는 요약에서 수량 엔티티를 평가하는 방법[76] 및 자체 모순 진술을 감지하고 완화하는 방법[77]과 같이 특정 환각 유형에 중점을 둔 평가 및 완화이다.[72]

2023년에 출시된 엔비디아 가드레일은 LLM에 맡기는 대신 스크립트를 통해 특정 응답을 하드 코딩하도록 구성할 수 있다.[78] 또한 SelfCheckGPT[79] 및 Aimon[80]과 같은 수많은 도구가 오프라인 실험 및 실시간 프로덕션 시나리오에서 환각 감지를 지원하기 위해 등장했다.

참조

[1]

웹사이트

Scholars: AI isn't "hallucinating" -- it's bullshitting

https://www.psypost.[...]

2024-06-09

[2]

논문

ChatGPT is bullshit

2024-06-08

[3]

뉴스

Why ChatGPT and Bing Chat are so good at making things up

https://arstechnica.[...]

2023-04-06

[4]

웹사이트

Shaking the foundations: delusions in sequence models for interaction and control

https://www.deepmind[...]

2023-12-22

[5]

웹사이트

Definition of HALLUCINATION

https://www.merriam-[...]

2023-10-21

[6]

학회발표

On Faithfulness and Factuality in Abstractive Summarization

https://aclanthology[...]

[7]

논문

Survey of Hallucination in Natural Language Generation

https://dl.acm.org/d[...]

Association for Computing Machinery

2022-11-01

[8]

뉴스

Chatbots May 'Hallucinate' More Often Than Many Realize

https://www.nytimes.[...]

2023-11-06

[9]

논문

An evaluation on large language model outputs: Discourse and memorization

2023-07-13

[10]

논문

Virtual input phenomena within the death of a simple pattern associator

1995-12-01

[11]

서적

Encyclopedia of Creativity, Invention, Innovation and Entrepreneurship

Springer Science+Business Media, LLC

2013-01-01

[12]

웹사이트

AI Hallucinations: A Misnomer Worth Clarifying

https://arxiv.org/ht[...]

[13]

웹사이트

Face Hallucination

https://people.csail[...]

[14]

웹사이트

Hallucinations in Neural Machine Translation

https://research.goo[...]

[15]

논문

Exploring AI Ethics of ChatGPT: A Diagnostic Analysis

[16]

웹사이트

Blender Bot 2.0: An open source chatbot that builds long-term memory and searches the internet

https://ai.meta.com/[...]

[17]

뉴스

Meta warns its new chatbot may forget that it's a bot

https://www.zdnet.co[...]

ZDNET

2022-08-08

[18]

뉴스

The Alarming Deceptions at the Heart of an Astounding New Chatbot

https://slate.com/te[...]

2022-12-13

[19]

뉴스

When A.I. Chatbots Hallucinate

https://www.nytimes.[...]

2023-05-01

[20]

웹사이트

'Hallucinate' chosen as Cambridge dictionary's word of the year

https://www.theguard[...]

2023-11-15

[21]

웹사이트

What are AI chatbots actually doing when they 'hallucinate'? Here's why experts don't like the term

https://news.northea[...]

2023-11-10

[22]

논문

A Comprehensive Survey of Hallucination Mitigation Techniques in Large Language Models

2024-01-08

[23]

논문

GPT-4 Technical Report

[24]

학회발표

Actively Avoiding Nonsense in Generative Models

http://proceedings.m[...]

Proceedings of Machine Learning Research (PMLR)

2018

[25]

논문

The dynamic componential model of creativity and innovation in organizations: Making progress, making meaning

[26]

뉴스

Managing the Creative Frontier of Generative AI: The Novelty-Usefulness Tradeoff

https://cmr.berkeley[...]

[27]

뉴스

The New Chatbots Could Change the World. Can You Trust Them?

https://www.nytimes.[...]

2022-12-10

[28]

논문

Galactica: A Large Language Model for Science

2022-11-16

[29]

뉴스

New Meta AI demo writes racist and inaccurate scientific literature, gets pulled

https://arstechnica.[...]

2022-11-18

[30]

인터뷰

Llama 2, 3 & 4: Synthetic Data, RLHF, Agents on the path to Open Source AGI

https://www.latent.s[...]

2024-07-23

[31]

뉴스

A new AI chatbot might do your homework for you. But it's still not an A+ student

https://www.npr.org/[...]

NPR

2022-12-19

[32]

뉴스

Google vs. ChatGPT: Here's what happened when I swapped services for a day

https://www.cnbc.com[...]

CNBC

2022-12-15

[33]

뉴스

We asked an AI questions about New Brunswick. Some of the answers may surprise you

https://www.cbc.ca/n[...]

CBC News

2022-12-30

[34]

뉴스

We Asked ChatGPT Your Questions About Astronomy. It Didn't Go so Well.

https://www.discover[...]

2022-12-30

[35]

뉴스

How to easily trick OpenAI's genius new ChatGPT

https://www.fastcomp[...]

2022-12-05

[36]

뉴스

OpenAI invites everyone to test ChatGPT, a new AI-powered chatbot—with amusing results

https://arstechnica.[...]

2022-12-01

[37]

뉴스

ChatGPT Is a Tipping Point for AI

https://hbr.org/2022[...]

2022-12-14

[38]

뉴스

Finally, an A.I. Chatbot That Reliably Passes 'the Nazi Test'

https://slate.com/te[...]

2022-12-02

[39]

웹사이트

How come GPT can seem so brilliant one minute and so breathtakingly dumb the next?

https://garymarcus.s[...]

Substack

2022-12-02

[40]

뉴스

Microsoft's Bing A.I. made several factual errors in last week's launch demo

https://www.cnbc.com[...]

2023-02-14

[41]

뉴스

Google cautions against 'hallucinating' chatbots, report says

https://www.reuters.[...]

Reuters

2023-02-11

[42]

뉴스

Lawyer apologizes for fake court citations from ChatGPT

https://www.cnn.com/[...]

CNN Business

2023-05-27

[43]

뉴스

Federal judge: No AI in my courtroom unless a human verifies its accuracy

https://arstechnica.[...]

2023-05-31

[44]

웹사이트

Judge Brantley Starr

https://www.txnd.usc[...]

Northern District of Texas United States District Court

[45]

뉴스

Lawyers have real bad day in court after citing fake cases made up by ChatGPT

https://arstechnica.[...]

2023-06-23

[46]

뉴스

OpenAI faces defamation suit after ChatGPT completely fabricated another lawsuit

https://arstechnica.[...]

2023-06-09

[47]

논문

Exploring the Boundaries of Reality: Investigating the Phenomenon of Artificial Intelligence Hallucination in Scientific Writing Through ChatGPT References

2023-04-11

[48]

논문

Hallucinations in ChatGPT: A Cautionary Tale for Biomedical Researchers

https://doi.org/10.1[...]

2023-06-25

[49]

학회

Towards Mitigating Hallucination in Large Language Models via Self-Reflection

https://aclanthology[...]

EMNLP Findings

2023

[50]

논문

High Rates of Fabricated and Inaccurate References in ChatGPT-Generated Medical Content

2023-05-19

[51]

논문

Abstracts written by ChatGPT fool scientists

https://www.nature.c[...]

2023-01-12

[52]

논문

Comparing scientific abstracts generated by ChatGPT to real abstracts with detectors and blinded human reviewers

2023-04-26

[53]

논문

ChatGPT: these are not hallucinations – they're fabrications and falsifications

2023-08-19

[54]

뉴스

An AI that can "write" is feeding delusions about how smart artificial intelligence really is

https://www.salon.co[...]

2023-01-02

[55]

뉴스

OpenAI is pursuing a new way to fight A.I. 'hallucinations'

https://www.cnbc.com[...]

2023-05-31

[56]

뉴스

Google's AI chatbot Bard makes factual error in first demo

https://www.theverge[...]

2023-02-08

[57]

서적

Neural Networks for Babies

Sourcebooks Jabberwocky

[58]

잡지

Artificial Intelligence May Not 'Hallucinate' After All

https://www.wired.co[...]

2019-05-08

[59]

잡지

AI Has a Hallucination Problem That's Proving Tough to Fix

https://www.wired.co[...]

Condé Nast

2018-03-09

[60]

논문

A Discussion of 'Adversarial Examples Are Not Bugs, They Are Features': Adversarial Example Researchers Need to Expand What is Meant by 'Robustness'

https://distill.pub/[...]

2019-08-06

[61]

arXiv

A Survey on Audio Diffusion Models: Text To Speech Synthesis and Enhancement in Generative AI

2023-04-02

[62]

웹사이트

Google Gemini is a nice image of one of the dangers of AI as we give it more power. Ideology is so thickly overlaid that it skews everything, then doubles down. First image looks about right, but scroll down.

https://x.com/Pageau[...]

[63]

뉴스

Google apologizes for "missing the mark" after Gemini generated racially diverse Nazis

https://www.theverge[...]

2024-02-21

[64]

웹사이트

Gemini image generation got it wrong. We'll do better.

https://blog.google/[...]

2024-02-23

[65]

arXiv

Hallucination is Inevitable: An Innate Limitation of Large Language Models

2024

[66]

논문

A Simple Recipe towards Reducing Hallucination in Neural Surface Realisation

https://aclanthology[...]

Association for Computational Linguistics

2019-07

[67]

논문

Proceedings of the 2022 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies

Association for Computational Linguistics

2022-07

[68]

논문

Survey of Hallucination in Natural Language Generation

2023

[69]

뉴스

ChatGPT 'hallucinates.' Some researchers worry it isn't fixable.

https://www.washingt[...]

2023-05-30

[70]

arXiv

A Stitch in Time Saves Nine: Detecting and Mitigating Hallucinations of LLMs by Validating Low-Confidence Generation

2023

[71]

백과사전

Unjustified untrue "beliefs": AI hallucinations and justification logics

https://philarchive.[...]

2024-06-04

[72]

arXiv

Hallucination Detection and Hallucination Mitigation: An Investigation

2024

[73]

arXiv

Neural path hunter: Reducing hallucination in dialogue systems via path grounding

2021

[74]

백과사전

Increasing faithfulness in knowledge-grounded dialogue with controllable features

https://aclanthology[...]

2024-06-04

[75]

arXiv

Contrastive Learning Reduces Hallucination in Conversations

2022

[76]

백과사전

Reducing Quantity Hallucinations in Abstractive Summarization

https://aclanthology[...]

2024-06-04

[77]

arXiv

Self-contradictory Hallucinations of Large Language Models: Evaluation, Detection and Mitigation

2023

[78]

뉴스

Nvidia has a new way to prevent A.I. chatbots from 'hallucinating' wrong facts

https://www.cnbc.com[...]

2023-06-15

[79]

웹사이트

potsawee/selfcheckgpt

https://github.com/p[...]

2024-05-09

[80]

웹사이트

Aimon

https://aimon.ai/

aimonlabs

2024-05-08

[81]

웹사이트

Scholars: AI isn't "hallucinating" -- it's bullshitting

https://www.psypost.[...]

2024-06-09

[82]

저널

ChatGPT is bullshit

https://doi.org/10.1[...]

2024-06-08

[83]

뉴스

Why ChatGPT and Bing Chat are so good at making things up

https://arstechnica.[...]

2023-04-06

[84]

웹사이트

Shaking the foundations: delusions in sequence models for interaction and control

https://www.deepmind[...]

2023-12-22

[85]

웹사이트

Definition of HALLUCINATION

https://www.merriam-[...]

2023-10-21

[86]

컨퍼런스

On Faithfulness and Factuality in Abstractive Summarization

https://aclanthology[...]

[87]

웹사이트

ハルシネーション(Hallucination)とは?

https://atmarkit.itm[...]

@IT

2023-11-06

[88]

뉴스

Chatbots May 'Hallucinate' More Often Than Many Realize

https://www.nytimes.[...]

2023-11-06

[89]

저널

An evaluation on large language model outputs: Discourse and memorization

2023-07-13

[90]

웹사이트

幻覚

https://bsd.neuroinf[...]

脳科学辞典

[91]

웹사이트

LLMs confabulate not hallucinate

http://www.beren.io/[...]

[92]

웹사이트

AI Hallucinations: A Misnomer Worth Clarifying

https://arxiv.org/ht[...]

[93]

웹사이트

Face Hallucination

https://people.csail[...]

[94]

웹사이트

Hallucinations in Neural Machine Translation

https://research.goo[...]

[95]

arXiv

Exploring AI Ethics of ChatGPT: A Diagnostic Analysis

[96]

웹사이트

Blender Bot 2.0: An open source chatbot that builds long-term memory and searches the internet

https://ai.meta.com/[...]

[97]

뉴스

Meta warns its new chatbot may forget that it's a bot

https://www.zdnet.co[...]

ZDNET

2022-08-08

[98]

arXiv

Exploring AI Ethics of ChatGPT: A Diagnostic Analysis

[99]

뉴스

The Alarming Deceptions at the Heart of an Astounding New Chatbot

https://slate.com/te[...]

2022-12-13

[100]

뉴스

The Alarming Deceptions at the Heart of an Astounding New Chatbot

https://slate.com/te[...]

2022-12-13

[101]

웹사이트

AI Ethics Lucidly Questioning This Whole Hallucinating AI Popularized Trend That Has Got To Stop

https://www.forbes.c[...]

[102]

저널

When A.I. Chatbots Hallucinate

https://www.nytimes.[...]

2023-05-01

[103]

뉴스

The New Chatbots Could Change the World. Can You Trust Them?

https://www.nytimes.[...]

2022-12-10

[104]

뉴스

Microsoft's Bing A.I. made several factual errors in last week's launch demo

https://www.cnbc.com[...]

2023-02-14

[105]

저널

Survey of Hallucination in Natural Language Generation

https://dl.acm.org/d[...]

Association for Computing Machinery

2022-11

[106]

웹사이트

'Hallucinate' chosen as Cambridge dictionary's word of the year

https://www.theguard[...]

2024-06-07

[107]

웹사이트

What are AI chatbots actually doing when they 'hallucinate'? Here's why experts don't like the term

https://news.northea[...]

2024-06-14

[108]

뉴스

An AI that can "write" is feeding delusions about how smart artificial intelligence really is

https://www.salon.co[...]

2023-06-11

[109]

논문

A Comprehensive Survey of Hallucination Mitigation Techniques in Large Language Models

2024-01-08

[110]

뉴스

OpenAI is pursuing a new way to fight A.I. 'hallucinations'

https://www.cnbc.com[...]

2023-06-11

[111]

뉴스

Google's AI chatbot Bard makes factual error in first demo

https://www.theverge[...]

2023-06-11

[112]

논문

GPT-4 Technical Report

[113]

학회논문

Actively Avoiding Nonsense in Generative Models

http://proceedings.m[...]

Proceedings of Machine Learning Research (PMLR)

[114]

학술지

The dynamic componential model of creativity and innovation in organizations: Making progress, making meaning

[115]

학술지

Managing the Creative Frontier of Generative AI: The Novelty-Usefulness Tradeoff

https://cmr.berkeley[...]

[116]

뉴스

The New Chatbots Could Change the World. Can You Trust Them?

https://www.nytimes.[...]

2022-12-30

[117]

뉴스

Meta warns its new chatbot may forget that it's a bot

https://www.zdnet.co[...]

Red Ventures

2022-12-30

[118]

뉴스

New Meta AI demo writes racist and inaccurate scientific literature, gets pulled

https://arstechnica.[...]

2022-12-30

[119]

트윗

I asked #Galactica about some things I know about and I'm troubled. In all cases, it was wrong or biased but sounded right and authoritative.

2022-12-30

[120]

뉴스

A new AI chatbot might do your homework for you. But it's still not an A+ student

https://www.npr.org/[...]

NPR

2022-12-29

[121]

뉴스

Google vs. ChatGPT: Here's what happened when I swapped services for a day

https://www.cnbc.com[...]

2022-12-30

[122]

뉴스

We asked an AI questions about New Brunswick. Some of the answers may surprise you

https://www.cbc.ca/n[...]

2022-12-30

[123]

뉴스

We Asked ChatGPT Your Questions About Astronomy. It Didn't Go so Well.

https://www.discover[...]

Kalmbach Publishing Co.

2022-12-31

[124]

뉴스

How to easily trick OpenAI's genius new ChatGPT

https://www.fastcomp[...]

2023-01-06

[125]

뉴스

OpenAI invites everyone to test ChatGPT, a new AI-powered chatbot—with amusing results

https://arstechnica.[...]

2022-12-29

[126]

트윗

OpenAI's new chatbot is amazing. It hallucinates some very interesting things.

2022-12-29

[127]

뉴스

ChatGPT Is a Tipping Point for AI

https://hbr.org/2022[...]

2022-12-29

[128]

트윗

One of the big subtle problems in the new “creative AIs” is that they can seem completely certain, and getting them to switch from sane to hallucinatory is a difference of a couple words.

2022-12-29

[129]

뉴스

Finally, an A.I. Chatbot That Reliably Passes "the Nazi Test"

https://slate.com/te[...]

2022-12-29

[130]

웹사이트

How come GPT can seem so brilliant one minute and so breathtakingly dumb the next?

https://garymarcus.s[...]

Substack

2022-12-29

[131]

뉴스

Microsoft's Bing A.I. made several factual errors in last week's launch demo

https://www.cnbc.com[...]

2023-02-16

[132]

뉴스

Google cautions against 'hallucinating' chatbots, report says

https://www.reuters.[...]

2023-02-16

[133]

뉴스

Lawyer apologizes for fake court citations from ChatGPT

https://www.cnn.com/[...]

CNN Business

[134]

뉴스

Federal judge: No AI in my courtroom unless a human verifies its accuracy

https://arstechnica.[...]

[135]

웹사이트

Judge Brantley Starr

https://www.txnd.usc[...]

Northern District of Texas United States District Court

2023-06-26

[136]

뉴스

Lawyers have real bad day in court after citing fake cases made up by ChatGPT

https://arstechnica.[...]

[137]

뉴스

OpenAI faces defamation suit after ChatGPT completely fabricated another lawsuit

https://arstechnica.[...]

[138]

웹사이트

れいわ、虚偽サイト注意呼びかけ 芸能人応援「事実なし」

https://nordot.app/1[...]

2023-11-12

[139]

웹사이트

れいわ、偽サイトに注意呼びかけ 俳優3人が「応援メッセージ」?

https://www.asahi.co[...]

2023-11-12

[140]

웹사이트

○○さんらの“偽コメント”ブログ 作成者が日テレの取材に回答(一部伏せ字)

https://news.ntv.co.[...]

2023-11-12

[141]

웹사이트

サイト運営者「AIに書かせた」 れいわ新選組の虚偽応援

https://nordot.app/1[...]

2023-11-12

[142]

논문

Exploring the Boundaries of Reality: Investigating the Phenomenon of Artificial Intelligence Hallucination in Scientific Writing Through ChatGPT References

2023-04-11

[143]

논문

Hallucinations in ChatGPT: A Cautionary Tale for Biomedical Researchers

https://doi.org/10.1[...]

2023-06-25

[144]

학회발표

Towards Mitigating Hallucination in Large Language Models via Self-Reflection

https://aclanthology[...]

EMNLP Findings

2023

[145]

논문

High Rates of Fabricated and Inaccurate References in ChatGPT-Generated Medical Content

2023-05-19

[146]

논문

Abstracts written by ChatGPT fool scientists

https://www.nature.c[...]

2023-01-12

[147]

논문

Comparing scientific abstracts generated by ChatGPT to real abstracts with detectors and blinded human reviewers

2023-04-26

[148]

논문

ChatGPT: these are not hallucinations – they're fabrications and falsifications

2023-08-19

[149]

논문

GPT-4 Technical Report

[150]

논문

Survey of Hallucination in Natural Language Generation

https://dl.acm.org/d[...]

Association for Computing Machinery

2023-01-15

[151]

논문

Survey of Hallucination in Natural Language Generation

https://dl.acm.org/d[...]

Association for Computing Machinery

2023-01-15

[152]

잡지

Artificial Intelligence May Not 'Hallucinate' After All

https://www.wired.co[...]

2022-12-29

[153]

잡지

AI Has a Hallucination Problem That's Proving Tough to Fix

https://www.wired.co[...]

Condé Nast

2018-03-09

[154]

논문

A Discussion of 'Adversarial Examples Are Not Bugs, They Are Features': Adversarial Example Researchers Need to Expand What is Meant by 'Robustness'

https://distill.pub/[...]

2023-01-24

[155]

논문

A Survey on Audio Diffusion Models: Text To Speech Synthesis and Enhancement in Generative AI

https://arxiv.org/ab[...]

2024-08-15

[156]

웹사이트

Google Gemini is a nice image of one of the dangers of AI as we give it more power. Ideology is so thickly overlaid that it skews everything, then doubles down. First image looks about right, but scroll down.

https://x.com/Pageau[...]

2024-08-14

[157]

뉴스

Google apologizes for “missing the mark” after Gemini generated racially diverse Nazis

https://www.theverge[...]

2024-02-21

[158]

웹사이트

Gemini image generation got it wrong. We'll do better.

https://blog.google/[...]

2024-02-23

[159]

논문

Hallucination is Inevitable: An Innate Limitation of Large Language Models

2024

[160]

논문

A Simple Recipe towards Reducing Hallucination in Neural Surface Realisation

https://aclanthology[...]

Association for Computational Linguistics

2023-01-15

[161]

논문

Proceedings of the 2022 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies

Association for Computational Linguistics

2023-01-15

[162]

논문

Survey of Hallucination in Natural Language Generation

https://dl.acm.org/d[...]

Association for Computing Machinery

2023-01-15

[163]

뉴스

How to easily trick OpenAI's genius new ChatGPT

https://www.fastcomp[...]

2022-12-05

[164]

웹인용

AI 환각이란 무엇일까요?

https://gflix.kr/ai-[...]

2024-03-24

[165]

잡지

Artificial Intelligence May Not 'Hallucinate' After All

https://www.wired.co[...]

2022-12-29

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com