GPT-2

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

GPT-2는 OpenAI에서 개발한 텍스트 생성 인공지능 모델이다. 2018년 GPT-1의 확장판으로, 15억 개의 파라미터와 800만 웹 페이지 데이터 세트를 사용하여 훈련되었다. GPT-2는 주어진 텍스트를 바탕으로 다음 단어를 예측하여 자연어 문장을 생성하며, 제로 샷 학습을 통해 다양한 작업을 수행할 수 있다. 2019년 부분 공개되었으며, 이후 전체 모델이 공개되었다. 텍스트 생성 능력은 뛰어나지만, 긴 텍스트 생성 시 일관성이 떨어지는 한계가 있다.

더 읽어볼만한 페이지

- GPT (언어 모델) - GPT-3

GPT-3는 OpenAI가 개발한 1,750억 개의 매개변수를 가진 대규모 언어 모델로, 텍스트 생성, 코드 작성, 질문 응답 등 다양한 작업을 수행할 수 있지만, 윤리적 문제점과 사회적 비판도 존재한다. - GPT (언어 모델) - DALL-E

DALL-E는 OpenAI에서 개발한 텍스트 기반 이미지 생성 인공지능 모델로, GPT-3를 기반으로 하며 높은 해상도와 현실적인 이미지를 생성하도록 개선되었지만, 윤리적 문제점과 언어 이해 능력의 한계가 지적된다. - 대형 언어 모델 - 챗GPT

챗GPT는 오픈AI가 개발한 GPT-3.5 기반의 대화형 인공지능 서비스로, 인간과 유사한 텍스트 생성, 코드 생성, 보고서 작성, 번역 등의 다양한 기능을 제공하지만, 편향된 정보 생성, 데이터 유출, 윤리 및 저작권 문제 등의 논란도 있으며, 유료 서비스를 포함한 다양한 형태로 제공되고, 지속적인 모델 개발을 통해 성능을 향상시키고 있다. - 대형 언어 모델 - GPT-3

GPT-3는 OpenAI가 개발한 1,750억 개의 매개변수를 가진 대규모 언어 모델로, 텍스트 생성, 코드 작성, 질문 응답 등 다양한 작업을 수행할 수 있지만, 윤리적 문제점과 사회적 비판도 존재한다. - 오픈AI - 챗GPT

챗GPT는 오픈AI가 개발한 GPT-3.5 기반의 대화형 인공지능 서비스로, 인간과 유사한 텍스트 생성, 코드 생성, 보고서 작성, 번역 등의 다양한 기능을 제공하지만, 편향된 정보 생성, 데이터 유출, 윤리 및 저작권 문제 등의 논란도 있으며, 유료 서비스를 포함한 다양한 형태로 제공되고, 지속적인 모델 개발을 통해 성능을 향상시키고 있다. - 오픈AI - GPT-3

GPT-3는 OpenAI가 개발한 1,750억 개의 매개변수를 가진 대규모 언어 모델로, 텍스트 생성, 코드 작성, 질문 응답 등 다양한 작업을 수행할 수 있지만, 윤리적 문제점과 사회적 비판도 존재한다.

| GPT-2 - [IT 관련 정보]에 관한 문서 | |

|---|---|

| 개요 | |

| |

| 저자 | OpenAI |

| 출시일 | 2019년 2월 14일 |

| 저장소 | https://github.com/openai/gpt-2 |

| 이전 버전 | GPT-1 |

| 후속 버전 | GPT-3 |

| 종류 | Transformer 언어 모델 |

| 라이선스 | MIT 라이선스 |

| 웹사이트 | https://openai.com/blog/gpt-2-1-5b-release/ |

| 기술 정보 | |

| 장르 | 대규모 언어 모델 생성적 사전 훈련 트랜스포머 |

2. 역사적 배경

인공지능, 특히 자연어 처리 분야는 컴퓨터 과학의 초기부터 중요한 연구 주제였다. 인간의 언어를 이해하고 생성하려는 시도는 기계 학습과 신경망 기술의 발전을 통해 꾸준히 진화해왔다. 이러한 연구들은 초기의 규칙 기반 시스템에서 시작하여, 통계적 방법론을 거쳐 딥 러닝 기반의 복잡한 모델로 발전하는 과정을 거쳤다. GPT-2와 같은 대규모 언어 모델은 이러한 오랜 역사적 배경과 기술적 축적 위에서 탄생할 수 있었다. 구체적인 기술 발전의 역사는 다음 하위 섹션들에서 자세히 설명한다.

2. 1. 전산 언어학과 초기 인공지능

컴퓨팅 역사 초창기부터 인공지능은 중요한 연구 대상이었다. 1950년 앨런 튜링은 기계가 인간과 얼마나 비슷하게 대화할 수 있는지를 평가하는 "이미테이션 게임"(imitation game)을 제안했다. 이는 기계의 지적 능력을 판단하는 기준으로 제시되었다. 이후 1959년 IBM의 연구자 아서 새뮤얼은 컴퓨터가 명시적으로 프로그래밍되지 않고도 학습할 수 있는 능력을 설명하며 "기계 학습(machine learning)"이라는 용어를 처음 사용했다. 오늘날 기계 학습은 통계적 학습, 데이터 과학, 신경망 등 다양한 계산 기법을 포괄하는 분야로 발전했다.컴퓨터를 이용한 자연어 처리(NLP)는 초기 전산 언어학의 한 분야로 시작되었다. 컴퓨터 하드웨어 성능이 발전하면서 자연어 처리 시도가 이루어졌는데, 1948년 런던 버크벡 칼리지에서 개발된 사전 룩업 테이블이 초기 응용 사례 중 하나이다. 1954년에는 조지타운-IBM 실험이 진행되어, 60개의 러시아어 문장을 영어로 번역하는 완전 자동 기계 번역 시스템이 시연되었다. 이 시스템은 6개의 문법 규칙과 250개의 어휘만을 사용했으며, 문장 구조 분석 없이 주로 단어를 일대일로 대체하는 방식이었기 때문에 번역 품질은 높지 않았다. 그럼에도 불구하고 이 실험은 컴퓨터가 자연어를 해석하고 처리할 수 있다는 가능성을 보여주었고, 이후 연구를 위해 CIA의 자금 지원을 받는 계기가 되었다.

20세기 중반에는 자연어를 이용한 인간-컴퓨터 상호 작용(HCI) 시스템도 등장했다. 1968년부터 1970년 사이 MIT에서 개발된 SHRDLU는 가상 공간의 물체에 대해 사용자가 자연어로 명령을 내리고 대화하는 프로그램이었다. 1966년에 개발된 챗봇 ELIZA는 사용자가 입력한 텍스트에서 핵심 단어를 파악하여 적절한 응답을 생성했다. ELIZA와 대화한 많은 사람들이 실제 인간과 대화하는 것으로 착각하기도 했지만, 이것이 진정한 의미의 지능인지에 대해서는 논란이 있었다.

초기 기계 번역 연구가 주로 계산적인 접근에 집중했던 반면, 1950년대 전산 언어학 주류는 노엄 촘스키가 제시한 보편 문법 개념의 영향을 받았다. 당시 NLP 연구는 자연어 문장을 언어에 구애받지 않는 보편적인 논리 구조로 변환하려는 시도에 중점을 두었다. 1970년대에는 문장의 표면적인 구문 구조보다는 의미 자체에 초점을 맞춘 의미론적 NLP 시스템 개발이 시도되었다. 그러나 신경망 기술이 발전하기 전까지 대부분의 시스템은 사람이 직접 만든 방대한 규칙 목록에 의존해야 했고, 이는 시스템 확장에 큰 제약으로 작용했다.

인공 지능 분야는 20세기 후반에도 꾸준히 발전했지만, 연구 자금 지원 감소나 기술적 한계 등으로 인해 "AI의 겨울"이라 불리는 침체기를 겪기도 했다. 연구자마다 그 시기에 대한 의견은 다르지만, 이러한 정체기는 인공지능 연구 역사에서 여러 차례 나타났다.

2. 2. 신경망의 발전

인공지능의 초기 개념 중 하나인 커넥셔니즘은 생물학적 뇌의 뉴런(신경 세포) 활동을 모방하여 지능적인 행동을 구현하려는 인공 신경망을 통해 시도되었다. 최초의 인공 신경망 사례는 1951년에 만들어진 SNARC(Stochastic neural analog reinforcement calculator)이다. 이후 1957년, 심리학자 프랭크 로젠블라트는 이진 분류를 수행하는 퍼셉트론을 발표했다. 이 기계는 400개의 광전지를 '뉴런'처럼 연결하여 이미지 인식을 수행하도록 설계되었으며, 가중치는 전위차계를 통해 조절되었다. 퍼셉트론은 당시 큰 주목을 받았고, 뉴욕 타임스는 미래의 전자 컴퓨터가 걷고, 말하고, 보고, 쓰는 것은 물론 스스로를 복제하고 존재를 인식할 수도 있을 것이라고 보도하며 기대감을 나타냈다.그러나 1969년 마빈 민스키와 시모어 페퍼트가 출판한 저서 ''퍼셉트론: 컴퓨터 과학으로의 길''에서 당시 최첨단 기술이었던 단층 퍼셉트론의 한계, 특히 배타적 논리합(XOR) 함수를 처리하지 못한다는 점을 지적하면서 퍼셉트론 연구는 수십 년간 침체기를 맞았다. 이 책은 신경망 연구 전반에 대한 부정적인 인식을 확산시키는 계기가 되었다.

신경망은 "훈련(training)"과 "학습(learning)" 과정을 통해 다양한 입력을 분류하는 능력을 얻는다. 학습은 먼저 네트워크 내부의 가중치(각 뉴런의 활성화가 다음 층 뉴런에 미치는 영향력)를 무작위로 설정하는 것에서 시작한다. 이후 네트워크의 출력이 실제 목표값과 얼마나 차이 나는지를 측정하는 손실 함수를 정의하고, 이 함수값을 최소화하는 방향으로 가중치를 조정하여 성능을 개선해 나간다.

역전파 알고리즘은 1974년 폴 워보스(Paul Werbos)의 박사 학위 논문에서 기계 학습 시스템에 처음 적용된 지도 학습 방식으로, 주어진 입출력 데이터에 대해 네트워크 전체 가중치를 최적으로 조정하기 위한 방향("기울기")을 효율적으로 계산하는 방법을 제시했다. 이 기울기를 사용하여 신경망을 훈련하는 경사 하강법으로 더 복잡한 시스템 구축이 가능해졌고, 1980년대에는 신경망을 자연어 처리 분야에 응용하는 연구가 활발해졌다. 1985년 D.B. 파커가 워보스의 기법을 재발견했으며, 1986년에는 라멜하트, 힌턴, 로널드 J. 윌리엄스(Ronald J. Williams)가 여러 개의 은닉층을 가진 심층 신경망(딥 러닝)에서 입력 데이터의 내부 표현을 학습시키기 위해 이 기법을 성공적으로 적용했다. 이 연구는 이후 순환 신경망 발전의 중요한 토대가 되었다.

전통적인 순방향 신경망(FFNN)은 정보가 입력층에서 출력층으로 한 방향으로만 흐르며, 각 층은 이전 층의 출력을 받아 다음 층으로 전달하는 구조를 가진다. 정보가 역방향으로 흐르는 순환(cycle) 구조는 존재하지 않는다. 반면, 순환 신경망(RNN)은 네트워크 내부에 최소 하나 이상의 순환 구조를 가지고 있어 정보가 되돌아 흐를 수 있다. RNN은 이전 단계의 처리 결과를 현재 단계의 입력으로 함께 활용할 수 있기 때문에, 단어의 순서가 중요한 문장이나 시계열 데이터처럼 순서가 있는 정보를 처리하고 예측하는 데 효과적으로 사용되었다.

한편, 1979년 후쿠시마 쿠니히코는 포유류의 시각피질 신경 구조에서 영감을 받아 네오코그니트론을 제안했다. 이는 이미지 처리 분야에서 널리 사용되는 합성곱 신경망(CNN)의 기초를 마련한 중요한 연구로 평가받는다. CNN은 큰 입력 데이터(예: 이미지)에 대해 작은 크기의 필터(filter)를 이동시키면서 특징을 추출하는 방식으로 작동한다. 이를 통해 전체 데이터를 한 번에 처리하는 것보다 훨씬 적은 계산량으로 깊이 있는 정보 처리가 가능하다. 예를 들어, 100x100 픽셀 이미지 전체를 처리하는 완전 연결층은 10,000개의 가중치가 필요하지만, 5x5 크기의 필터를 사용하는 합성곱층은 단 25개의 학습 가능한 매개변수만으로도 에지 감지와 같은 중요한 시각적 특징을 추출할 수 있다. CNN은 일반적으로 이러한 합성곱층과 추출된 정보의 차원을 축소하는 "풀링층(pooling layer)"이 번갈아 나타나고, 마지막 단계에서 "완전 연결층"(주로 다층 퍼셉트론)을 통해 최종적인 분류나 예측 결과를 출력하는 구조를 가진다.

2. 3. 자연어 처리를 위한 머신러닝

회귀 신경망(RNN)은 시계열 정보를 처리할 수 있어 많은 자연어 처리(NLP) 응용 분야에서 사용된다. RNN은 순서가 있는 데이터 항목의 주변 상황에 따라 동일한 단어라도 다른 의미로 해석하고 다른 결과를 내놓을 수 있다. 예를 들어, RNN 시스템은 "검은 개"에서는 '털이 많은 다리'를, "핫도그"에서는 '케첩'을, "환일"에서는 '굴절'을 연상하는 것처럼, 같은 "개"라는 단어에서도 문맥에 따라 서로 다른 연관성을 파악할 수 있다. 또한 RNN은 이전 순서 항목의 정보를 재귀적으로 사용하여 과거의 정보를 기억하도록 설계될 수 있다. 가령, "톰은 검은 개를 봤다", "톰은 핫도그를 봤다", "톰은 환일을 봤다"와 같은 문장 뒤에 각각 "상냥하게", "배고프게", "간접적으로" 같은 단어가 이어질 수 있도록 문맥을 파악하는 것이다.그러나 다층 순방향 신경망(FFNN)과 RNN 모두 우수한 성능을 보일 수 있지만, 기울기 소실 문제에 취약하다는 단점이 있다. 기울기는 부동소수점 숫자로 표현되는데, 모델의 여러 층을 거치며 역전파될 때 그 값이 너무 작아져 0에 가까워지거나(소실), 너무 커져 무한대로 발산할 수 있다. 1995년에서 1997년 사이, 제프 호흐라이터와 위르겐 슈미트후버는 장단기 기억(LSTM) 네트워크를 제안하여 이 문제를 해결하고자 했다. LSTM은 "입력", "출력", "망각" 게이트를 가진 여러 개의 "셀"로 구성된 새로운 구조를 도입했다. 2009년에는 알렉스 그레이브스 팀이 개발한 LSTM 기반 모델이 손글씨 문자 인식 관련 국제 대회인 ICDAR에서 우승했으며, 다른 모델들은 각각 가장 정확하거나 가장 빠른 모델로 평가받았다.

RNN과 LSTM의 또 다른 한계는 주로 이전 순서의 정보만을 고려한다는 점이다. 예를 들어, "톰은 자전거를 타고 가게에 가서 킥 스탠드를 내리고 엔진을 껐다"와 같은 문장에서 '자전거'가 실제로는 '오토바이'를 의미한다는 중요한 문맥 정보가 문장 끝에 나올 경우, 이를 제대로 파악하기 어려울 수 있다. 이러한 문제를 해결하기 위해 양방향 LSTM(bidirectional LSTM)이 제안되었다. 이 모델은 양방향으로 정보를 처리하여 '과거'와 '미래'의 문맥 정보를 모두 활용할 수 있게 한다. 조건부 확률장(CRF)은 태그를 사용하여 입력과 출력을 직접 연결하는 방식이다. LSTM-CRF나 BI-LSTM-CRF와 같이 위의 접근 방식들을 결합한 네트워크도 존재한다. 그 외에도 RNN 모델을 개선하기 위한 방법으로 뉴럴 튜링 머신, 적응 계산 시간(adaptive computation time), 뉴럴 프로그래머(neural programmers), 그리고 어텐션 메커니즘 등이 개발되었다. 특히 어텐션 메커니즘은 GPT-2와 같은 후속 기술들의 중요한 기반이 되었다.

2010년대 초반, 신경망 기반 기계 번역 분야에서는 RNN과 LSTM을 사용한 "인코더-디코더" 모델이 최고의 성능을 보였다. 이 모델은 "인코더 네트워크"가 원문을 벡터로 변환하고, 이 벡터를 "디코더 네트워크"가 처리하여 번역 결과를 생성하는 방식이었다. 2014년에는 복잡한 "어텐션" 메커니즘이 도입되어 이러한 모델의 성능이 크게 향상되었다. 어텐션 메커니즘은 디코더 네트워크가 전체 텍스트를 단일 벡터로만 보는 대신, 원문의 특정 부분에 적응적으로 "주의(attention)"를 기울일 수 있도록 만들었다.

이후 2017년에는 어텐션 메커니즘을 더욱 발전시켜 RNN/LSTM 구조를 완전히 대체하는 트랜스포머(Transformer) 모델이 등장했다.

2. 4. 선택적 집중 (Attention)

2010년대 초반 기계 번역 분야에서는 순환 신경망(RNN)이나 LSTM 기반의 인코더-디코더 모델이 주로 사용되었으나, 긴 문장 처리에는 한계가 있었다. 이러한 문제를 해결하기 위해 2014년 어텐션 메커니즘이 도입되었다. 어텐션은 번역 과정에서 원본 문장의 특정 부분에 선택적으로 집중하여 관련성 높은 정보만을 활용하는 방식이다. 이를 통해 모델은 문장의 길이에 구애받지 않고 중요한 정보를 효과적으로 처리할 수 있게 되었으며, 이후 다양한 방식으로 발전하였다.2. 4. 1. 어텐션 메커니즘

인코더-디코더 모델은 긴 문장을 고정된 길이의 벡터로 압축하는 데 어려움이 있어 입력이 길어질수록 성능이 떨어지는 한계가 있었다. 2014년, Bahdanau 등은 "정렬과 번역을 공동으로 수행"할 수 있는 인코더-디코더 모델의 확장된 형태를 발표했다. 이 모델에서 인코더(각 방향으로 1000개의 은닉 유닛을 가진 양방향 RNN)는 번역할 원문의 각 단어에 대해 문장 전체를 탐색하여 관련 정보의 위치를 찾았다. 기존 방식처럼 입력 문장 전체를 고정 길이 벡터로 만드는 대신, 찾아낸 위치와 이전에 생성된 목표 단어를 연관시킨 "맥락 벡터"를 만들었다. 디코더(역시 1000개의 은닉 유닛을 가짐)는 이 맥락 벡터를 사용하여 어떤 부분에 "주의"를 기울일지 결정했다.이러한 "어텐션 메커니즘"에 대한 탐구는, Luong 등에 의한 2015년 논문에서도 이어졌다. 그들은 Bahdanau의 연구에 기반한 "글로벌" 접근 방식과 원문의 일부만 고려하는 "로컬" 접근 방식을 시도했다. 로컬 접근 방식은 구조적으로 더 복잡했지만, 계산 비용이 적고 훈련이 더 쉬운 장점이 있었다. 1초에 1,000개의 타겟어를 번역할 수 있도록 특별히 설계된 영어-독일어 번역 모델을 완전히 훈련하는 데 7~10일이 소요되었다. 그 정확도는, 2014년 ACL 기계 번역 워크숍(WMT'14)에서의 영어-독일어 문장 쌍의 과제에 대한 테스트에서, 23.0 BLEU라는 결과를 달성했다. 이는 이전 시도에서 달성한 최고 결과인 Buck et al. 2014에 의한 구 기반 언어 모델보다 2.1 BLEU 우수했다.

어텐션 메커니즘은 기존의 합성곱 신경망이나 순환 신경망의 아키텍처를 개선하는 데 사용하여 성능 향상에 효과적이었지만, 곧 아무런 기초 없이 어텐션 메커니즘만으로도 고성능 모델을 구축할 수 있다는 것을 알게 되었다.

2017년 6월, 구글 브레인, 구글 리서치, 및 토론토 대학교의 연구자가 발표한 논문에서 Transformer 아키텍처가 처음 소개되었다. Transformer는 합성곱이나 순환을 완전히 버리고 어텐션 메커니즘만을 기반으로 한 모델의 일종이다. 기존 RNN 기반 모델과 달리 Transformer는 순차적으로 입력되는 각 항목에 대해 차례로 계산할 필요 없이 처리할 수 있으므로, 대규모 병렬화가 가능하다는 것을 의미했다. WMT'14 프랑스어-영어 과제에서, Transformer 아키텍처를 사용하여 특별히 훈련한 프랑스어-영어 번역 모델이 41.8 BLEU라는 새로운 단일 모델 벤치마크를 달성할 수 있었다. Transformer는 도입 이후, 많은 자연어 처리(NLP) 애플리케이션에서 사용되고 있다.

2. 4. 2. 트랜스포머 (Transformers)

어텐션 메커니즘은 기존의 합성곱 신경망이나 순환 신경망 구조를 개선하는 데 효과적이었지만, 곧 어텐션 메커니즘만으로도 고성능 모델을 구축할 수 있다는 것을 알게 되었다.2017년 6월, 구글 브레인, 구글 리서치, 및 토론토 대학교의 연구자가 발표한 논문에서 트랜스포머 아키텍처가 처음 소개되었다. 트랜스포머는 합성곱이나 순환을 완전히 버리고 어텐션 메커니즘만을 기반으로 한 모델의 일종이다. 기존 RNN 기반 모델과 달리 트랜스포머는 순차적으로 입력되는 각 항목에 대해 차례로 계산할 필요 없이 처리할 수 있으므로, 대규모 병렬화가 가능하다는 것을 의미했다. WMT'14 프랑스어-영어 과제에서, 트랜스포머 아키텍처를 사용하여 특별히 훈련한 프랑스어-영어 번역 모델이 41.8 BLEU라는 새로운 단일 모델 벤치마크를 달성할 수 있었다. 트랜스포머는 도입 이후, 많은 자연어 처리 애플리케이션에서 사용되고 있다.

3. Generative Pre-trained Transformer (GPT)

| 아키텍처 | 파라미터 수 | 훈련용 데이터 | |

|---|---|---|---|

| GPT-1 | 12층, 12헤드의 트랜스포머 디코더(인코더 없음), 그 다음 선형 소프트맥스 | 1억 2천만 | BookCorpus: 4.5GB 텍스트, 다양한 장르의 미발표 소설 7000권 분량[43] |

| GPT-2 | GPT-1 변종 | 15억[44] | WebText 코퍼스 (40GB) |

| GPT-3 | GPT-2, 단, 스케일링이 크게 변경됨 | 1750억 | 570GB의 평문, 4,000억 개의 토큰. 주로 Common Crawl, WebText, 영어판 위키백과, 2개의 도서 코퍼스 (Books1, Books2) |

2018년 6월 11일, OpenAI는 "Improving Language Understanding by Generative Pre-Training"(생성적 사전 훈련을 통한 언어 이해력 향상)이라는 제목의 논문을 발표하며, ''Generative Pre-trained Transformer(GPT)''라는 새로운 자연어 처리(NLP) 모델을 세상에 선보였다. 당시 최고 성능을 내는 신경망 기반 NLP 모델들은 대부분 지도 학습 방식을 사용했는데, 이는 사람이 직접 레이블링한 대규모 데이터가 필요하다는 한계가 있었다. 이런 방식은 레이블이 부족한 데이터셋에는 적용하기 어려웠고, 매우 큰 모델을 훈련시키는 데 많은 비용과 시간이 들었다. 특히 스와힐리어나 아이티 크리올어처럼 텍스트 자료 자체가 부족한 언어의 경우, 기존 모델로는 번역이나 통역 같은 작업을 수행하기 어려웠다.

GPT는 이러한 문제를 해결하기 위해 '준지도 학습' 접근 방식을 채택했다. 이는 두 단계로 이루어진다. 첫 번째는 비지도 생성적 사전 훈련(pre-training) 단계로, 레이블이 없는 대규모 텍스트 데이터를 이용해 언어 자체의 패턴을 학습하여 모델의 초기 파라미터를 설정한다. 두 번째는 지도 식별적 미세 조정(fine-tuning) 단계로, 사전 훈련된 모델을 특정 과제(번역, 질문 답변 등)에 맞게 소량의 레이블된 데이터로 추가 학습시켜 파라미터를 조정한다.

GPT는 기존의 어텐션 강화 순환 신경망(RNN)과는 달리, 트랜스포머 아키텍처를 기반으로 만들어졌다. 이를 통해 모델은 더 구조화된 기억 능력을 갖추게 되었고, 다양한 종류의 NLP 과제에서 뛰어난 전이 학습 성능을 보여주었다. 논문에서는 전이 학습 시, 구조화된 텍스트 입력을 단일 연속 토큰 시퀀스로 처리하고 과제별 입력 적응 방식을 활용한다고 설명했다.

3. 1. 코퍼스 (Corpus)

GPT-1 모델은 사전 학습 단계에서 BookCorpus 데이터 세트를 사용했다.[43] BookCorpus는 다양한 장르의 미출판 소설 7,000여 권 분량으로, 약 4.5 GB의 텍스트 데이터로 구성되어 있다. 이 데이터 세트가 선택된 이유는 모델이 장거리 정보를 효과적으로 학습하기 위해서는 연속된 긴 텍스트가 필요했기 때문이다. 당시 다른 대규모 데이터 세트들은 문장 순서가 뒤섞여 있는 등 장기적인 구조 정보가 부족하여 제외되었다. BookCorpus의 텍스트 정제(구두점 및 공백 표준화)에는 'ftfy' 라이브러리가, 토큰화에는 'spaCy'가 사용되었다.GPT-2는 WebText라는 코퍼스를 기반으로 훈련되었다. 이 코퍼스는 약 40 GB 크기의 텍스트 데이터로 구성된다.[44]

3. 2. 아키텍처 (Architecture)

GPT-2는 GPT-1의 아키텍처를 기반으로 한 변종이다.[44] 기본적인 GPT 아키텍처는 12개의 디코더만으로 구성된 트랜스포머 모델이다. 각 디코더 층은 12개의 마스크된 셀프 어텐션 헤드를 사용하며, 각 헤드는 64차원의 상태를 가진다(총 768개).

훈련 과정에서는 단순한 확률적 경사 하강법 대신 Adam 최적화 알고리즘을 사용했다. 학습률은 처음 2,000번의 업데이트 동안 0에서 최대 2.5×10−4까지 선형적으로 증가시킨 후, 코사인 스케줄에 따라 0까지 점진적으로 감소시키는 어닐링 방식을 적용했다.

모델 전체적으로 레이어 정규화를 광범위하게 사용했으며, 가중치 초기화는 평균 0, 표준편차 0.02인 정규분포(N(0, 0.02))를 따랐다. 어휘 구축에는 40,000개의 바이트 쌍 인코딩(BPE) 병합 방식을 사용했다.

정규화 기법으로는 잔차 연결, 임베딩, 어텐션에 0.1 비율의 드롭아웃을 적용했다. 또한, Loshchilov 등이 2017년에 제안한 수정된 L2 정규화를 채택하여, 모든 비편향 가중치 및 게인 가중치에 대해 w=0.01 값을 사용했다. 위치 임베딩 방식으로는 기존의 사인파 방식 대신 학습된 임베딩을 사용했다.

GPT-2는 GPT-1보다 규모가 훨씬 크며, 총 15억 개의 파라미터를 가진다.[44]

3. 3. 성능 (Performance)

GPT-1 모델은 다양한 자연어 처리(NLP) 과제에서 기존 모델들의 성능을 뛰어넘는 성과를 보였다.- 자연어 추론: 문장 쌍의 관계를 "함의", "모순", "중립"으로 분류하는 능력 평가에서, 위키백과 기사 기반의 QNLI 데이터 세트에서는 기존 최고 기록보다 5.8%, 다양한 텍스트(속기, 대중 소설, 정부 보고 등)로 구성된 MultiNLI 데이터 세트에서는 1.5% 더 높은 성능을 달성했다.

- 질문 응답 및 상식 추론: 중고등학교 시험 문제로 구성된 RACE 데이터 세트에서는 5.7%, 클로즈 테스트에서는 8.9% 더 우수한 성능을 보였다.

- 의미적 유사성: 두 문장이 서로 바꿔 말하기(paraphrase) 관계인지 예측하는 과제에서, Quora 질문 쌍(QQP) 데이터 세트를 기준으로 기존 최고 성능 모델보다 4.2% 향상된 결과를 얻었다.

- 텍스트 분류: 문장의 문법적 정확성을 판단하는 Corpus of Linguistic Acceptability(CoLA) 데이터 세트에서는 기존 최고 점수인 35.0점을 크게 넘어서는 45.4점을 기록했다.

- 멀티태스크 평가: 여러 NLP 과제를 종합적으로 평가하는 GLUE 벤치마크에서는 이전 최고 기록인 68.9점을 넘어선 72.8점의 종합 점수를 달성했다.

4. GPT-2

GPT-2는 GPT-1을 기반으로 확장된 모델로, 파라미터 수와 훈련 데이터 세트의 크기를 GPT-1 대비 10배 늘렸다. 이 모델은 비지도 학습 방식을 사용하는 트랜스포머 아키텍처를 기반으로 하며, 주어진 텍스트(토큰 배열)에서 다음에 올 단어를 예측하도록 훈련되었다.

GPT-2는 15억 개의 파라미터를 가지고 있으며, Reddit 게시물 링크를 기반으로 구축된 ''WebText''라는 자체 개발 데이터 세트를 사용하여 훈련되었다. 이 데이터 세트는 약 800만 개의 웹 페이지로 구성되어 있다. 모델은 입력된 텍스트의 맥락을 파악하여 가장 확률 높은 다음 단어를 예측하는 과정을 반복함으로써, 문법적으로 자연스러우며 의미론적으로도 일관성 있는 문장이나 단락을 생성할 수 있다.

GPT-2의 주요 특징 중 하나는 특정 작업에 대한 별도의 미세 조정 없이도 다양한 자연어 처리 작업을 수행할 수 있다는 점이다. 이러한 일반화 능력을 평가하기 위해 제로 샷 학습(Zero-shot learning) 환경에서의 성능이 측정되었다.

4. 1. 데이터 세트 (Dataset)

GPT-2는 트랜스포머 아키텍처의 대규모 병렬 처리 능력을 활용하여 이전 자연어 처리(NLP) 모델보다 훨씬 큰 코퍼스에서 훈련될 수 있었다. GPT-1 모델의 성공 이후, GPT-2는 더 큰 규모의 데이터 세트에서 훈련된 모델의 새로운 가능성을 탐구하는 것을 목표로 했다.초기에는 웹 크롤링으로 구축된 대규모 코퍼스인 ''커먼 크롤'' 사용이 검토되었으나, 내용 품질 문제로 인해 채택되지 않았다.[20][23] 대신 OpenAI는 Reddit에서 높은 평가를 받은 링크를 기반으로 ''WebText''라는 새로운 코퍼스를 직접 개발하여 사용했다.[20]

GPT-2 모델은 이렇게 만들어진 800만 개의 웹 페이지로 구성된 WebText 데이터 세트를 기반으로 훈련되었으며, 모델의 파라미터 수는 15억 개에 달한다. 이는 파라미터 수와 데이터 세트 크기 모두 GPT-1에 비해 10배 증가한 규모이다.

GPT-2의 정확한 전체 훈련 비용은 공개되지 않았으나, 시간당 비용은 256USD로 알려져 있다.[31][30] 유사한 대규모 언어 모델인 BERT와 XLNet의 훈련에는 각각 약 6912USD와 24.5만달러 상당의 자원이 소요된 것으로 보고되었다.[30]

4. 1. 1. WebText 코퍼스

GPT-2 모델은 이전의 자연어 처리(NLP) 모델보다 훨씬 큰 코퍼스에서 훈련될 수 있었는데, 이는 트랜스포머 아키텍처가 대규모 병렬 처리를 가능하게 했기 때문이다. GPT-1 모델로 이러한 접근 방식의 가능성을 확인한 후, GPT-2는 매우 큰 코퍼스에서 훈련된 네트워크의 새로운 속성을 더 탐구하고자 했다. 처음에는 웹 크롤링으로 생성된 대규모 코퍼스인 ''커먼 크롤''(''CommonCrawl'')을 사용하는 것을 고려했지만, 검토 결과 이해하기 어려운 내용이 많다는 점 때문에 사용하지 않기로 결정했다.[20][23]대신 OpenAI는 ''WebText''라는 새로운 코퍼스를 직접 개발했다. WebText는 월드 와이드 웹에서 무작위로 콘텐츠를 수집하는 대신, 2017년 12월 이전에 레딧에서 3개 이상의 '찬성표'(upvote)를 받은 게시물에 연결된 웹 페이지만을 수집하여 만들었다. 이는 인간의 평가(추천)를 통해 어느 정도 품질이 보장된 콘텐츠를 선별하려는 시도였다.[48][49] 수집된 데이터는 후처리 과정을 거쳤다. HTML 문서는 일반 텍스트로 변환되었고, 중복된 페이지는 제거되었다. 또한, 다른 많은 데이터 세트에도 포함되어 과적합을 유발할 수 있는 위키백과 문서는 제외되었다.[20][50] 이러한 정제 과정을 거쳐 최종적으로 약 800만 개의 웹 페이지에서 추출된 약 40GB의 고품질 자연어 텍스트가 WebText 코퍼스로 완성되었다.[45][51]

4. 2. 모델 (Model)

GPT-2는 GPT-1의 스케일 업 버전으로, 파라미터 수와 데이터 세트 크기를 모두 10배로 늘려 제작되었다. 두 모델 모두 비지도 학습 기반의 트랜스포머 모델이며, 일련의 토큰 배열에서 다음 단어를 예측하여 텍스트를 생성하도록 훈련되었다. GPT-2 모델은 15억 개의 파라미터를 가지며, 800만 개의 웹 페이지 데이터 세트로 훈련되었다. GPT-2는 주어진 텍스트 샘플에서 단어들의 순서를 파악하고, 가장 가능성이 높은 다음 단어를 예측하는 방식으로 작동한다. 이 과정을 반복하여 완전한 문장이나 단락을 생성하며, 이는 자연어로 이해 가능하고 의미론적으로도 의미 있는 결과물을 만들어낸다. 특히, GPT-2는 제로 샷 학습 설정에서의 성능으로 평가되었다.GPT-2의 모델 아키텍처는 GPT-1에서 몇 가지 변경 사항이 적용된 버전이다. 주요 아키텍처 변경점은 다음과 같다.

- 기존의 Post LN(Layer Normalization) 방식을 Pre LN 방식으로 변경하였다.[52]

- 모델의 마지막 어텐션 블록 이후에 추가적인 LN 계층을 배치하였다.[53]

- 잔차 레이어(Residual Layer)의 가중치를 초기화할 때, 레이어의 깊이(N)를 고려하여 1/√N 비율로 조정하였다.[54]

아키텍처는 GPT-1과 거의 유사하지만, 모델의 규모는 훨씬 커졌다. 모델의 주요 스펙 변경점은 다음과 같다.

- 모델 파라미터 크기: 약 15억 개로, GPT-1 대비 약 13배 증가하였다.[44]

- 어휘 크기: 50,257개로 확장되었다.[55]

- 컨텍스트 토큰 길이: 처리할 수 있는 최대 토큰 길이가 512개에서 1024개로 두 배 늘어났다.[56]

4. 3. 훈련 (Training)

GPT-2는 GPT 모델을 확장한 것으로, 파라미터 수와 데이터 세트 크기를 모두 10배 늘렸다. GPT-2와 GPT-1 모두 비지도 학습의 트랜스포머 모델이며, 일련의 토큰 배열에서 다음 단어를 예측하도록 훈련되어 텍스트를 생성한다. GPT-2 모델은 15억 개의 파라미터를 가지며, 800만 개의 웹 페이지 데이터 세트로 훈련되었다. 모델은 텍스트 샘플에서 다음 단어를 예측하는 단순한 기준을 강화하여, 자연어로 완전히 이해할 수 있고 의미론적으로 의미 있는 문장이나 단락을 생성하도록 설계되었다. 특히, GPT-2는 제로 샷 학습(Zero-shot learning) 설정에서의 성능으로 평가되었다.훈련 데이터셋 구축을 위해 처음에는 웹 크롤링으로 생성된 대규모 코퍼스인 ''CommonCrawl''이 고려되었으나, 검토 결과 이해하기 어려운 내용이 많아 사용되지 않았다.[20][23] 대신 OpenAI는 ''WebText''라는 새로운 코퍼스를 자체 개발했다. WebText는 월드 와이드 웹에서 무작위로 콘텐츠를 스크래핑하는 대신, 2017년 12월 이전에 3개 이상의 추천을 받은 Reddit 게시물에 링크된 페이지만을 스크래핑하여 생성되었다. 수집된 데이터는 HTML 문서를 일반 텍스트로 변환하고, 중복 페이지를 제거했으며, 다른 데이터 세트와의 중복으로 인한 과적합 가능성을 줄이기 위해 위키백과 페이지를 제거하는 방식으로 정제되었다.[20]

트랜스포머 아키텍처는 대규모 병렬 처리를 가능하게 하여 이전의 자연어 처리(NLP) 모델보다 훨씬 큰 코퍼스에서 훈련하는 것을 가능하게 했다. GPT-1 모델이 이 접근 방식의 가능성을 입증했고, GPT-2는 매우 큰 코퍼스에서 훈련된 네트워크의 새로운 속성을 더 탐구하는 것을 목표로 했다. 모델 학습 과정에서는 배치 크기를 512로 설정하여 훈련을 진행했다.[57]

GPT-2의 훈련 비용은 시간당 256USD로 알려져 있지만,[31][30] 훈련 완료까지 소요된 총 시간은 공개되지 않아 전체 훈련 비용을 정확하게 추정하기는 어렵다.[32] 참고로, 유사한 트랜스포머 아키텍처를 사용하는 다른 대규모 언어 모델인 BERT와 XLNet의 훈련 과정에는 각각 약 6912USD와 24.5만달러의 비용이 소요된 것으로 보고되었다.[30]

4. 4. 성능 (Performance)

GPT-2는 방대한 데이터 세트와 기술을 바탕으로 단순한 텍스트 생성을 넘어 다양한 작업을 수행할 수 있다. 예를 들어, 질문에 답하고, 긴 글을 요약하며, 기계 번역까지 가능하다. 이는 단순히 다음에 올 단어를 예측하도록 훈련받았을 뿐인데도 특정 지시 없이 여러 특정 영역의 작업을 처리할 수 있음을 보여준다.[26][24] 특히, GPT-2는 제로 샷 학습 환경에서의 작업 수행 능력으로 평가되었다.

이러한 일반화된 학습 능력의 한 예로 프랑스어와 영어 간의 기계 번역을 들 수 있다. WMT-14 번역 데이터셋을 이용한 평가에서 GPT-2의 성능이 측정되었다. GPT-2 훈련 데이터에는 프랑스어 텍스트가 거의 포함되지 않았다. 훈련 데이터 정제 과정에서 비영어 텍스트가 의도적으로 제거되었기 때문에, 전체 40,000 MB 중 프랑스어 데이터는 10 MB에 불과했다. 이는 대부분 영어 게시물이나 기사에 포함된 외국어 인용문 형태였다.[20]

적은 프랑스어 데이터에도 불구하고, GPT-2는 WMT-14 영어-프랑스어 테스트 세트에서 5 BLEU 점수를 기록했다. 이는 단어 대 단어 번역보다 약간 낮은 수준이다. 반면, 프랑스어-영어 테스트 세트에서는 11.5 BLEU를 달성하여, 당시(2017년)의 여러 비지도 기계 번역 기준치를 능가했다. 하지만 2019년 기준으로 가장 성능이 뛰어난 비지도 방식(33.5 BLEU 달성)에는 미치지 못했다.[20] 주목할 점은, 다른 모델들이 좋은 성능을 내기 위해 방대한 양의 프랑스어 텍스트를 사용한 반면, GPT-2는 비교 대상 모델들이 사용한 프랑스어 코퍼스의 약 1/500 크기만으로 이러한 결과를 얻었다는 점이다.[20]

5. 공개 (Release)

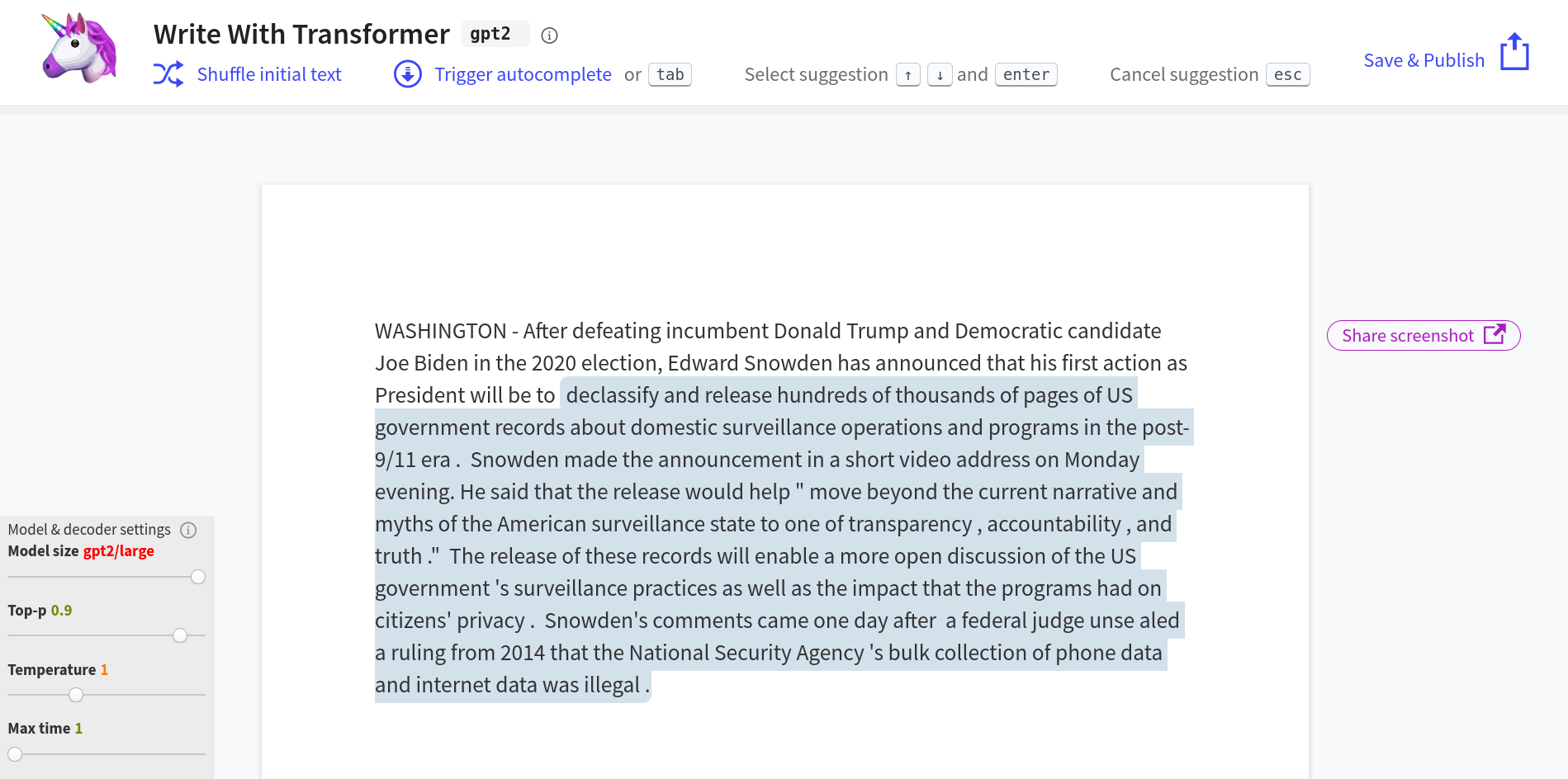

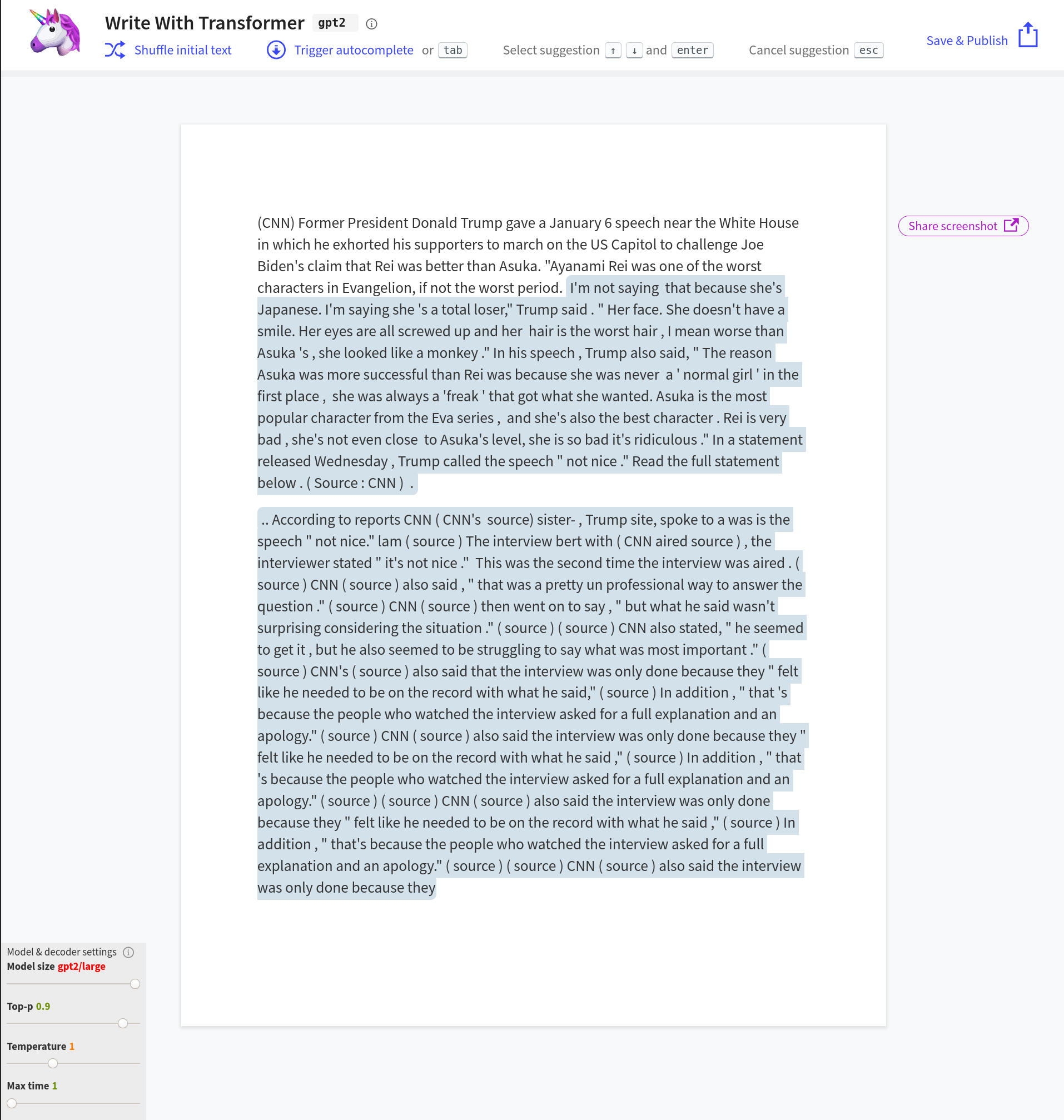

GPT-2는 2019년 2월 14일에 처음 발표되었다.[26] 발표 초기, The Verge는 GPT-2가 생성한 글이 때로는 비인간적인 티가 나지만, 언어 생성 프로그램의 "가장 흥미로운 예시 중 하나"라고 평가하며 가짜 헤드라인으로 기사를 완성하고, 이야기의 첫 문장으로 뒷이야기를 이어가며, 팬 픽션까지 쓸 수 있는 능력을 언급했다.[26] The Guardian은 그 결과물을 "그럴듯한 신문 기사"로,[25] 복스 미디어(Vox)는 "내가 본 가장 멋진 AI 시스템 중 하나"라고 평가하며[24] 언어 간 텍스트 번역, 긴 기사 요약, 퀴즈 질문 답변 능력 등 GPT-2의 유연성에 주목했다.[26]

암스테르담 대학교의 한 연구에서는 수정된 튜링 테스트를 통해, 특정 상황에서 사람들이 GPT-2가 생성한 시와 인간이 쓴 시를 구별하지 못한다는 결과를 발표하기도 했다.[2][58]

그러나 OpenAI는 이전 모델들과 달리, GPT-2 발표 당시 악의적인 사용 위험(스팸 필터 회피, 음란 및 인종차별적 텍스트 생성 가능성 등)을 이유로 소스 코드 공개를 처음에는 거부했다.[25] 이러한 비공개 결정은 기술의 잠재적 위협과 투명성에 대한 논쟁을 불러일으켰다.[37][38]

5. 1. 제한과 부분 공개 (Restrictions and partial release)

이전의 OpenAI 모델들은 즉시 대중에게 공개되었지만, OpenAI는 2019년 2월 GPT-2를 발표하면서 악의적인 사용 위험을 이유로 소스 코드 공개를 거부했다.[25] 발표 당시 일부 언론 매체에만 모델에 대한 제한적인 접근(소스 코드 자체가 아닌, 입력 및 출력을 제공하는 인터페이스)이 허용되었다.[25]OpenAI가 공개를 거부한 주된 이유는 GPT-2가 생성하는 텍스트가 대부분 완전히 새로운 내용이기 때문에, 스팸 발송자들이 자동 스팸 필터를 피하는 데 악용될 수 있다는 우려 때문이었다. OpenAI는 실제로 GPT-2를 미세 조정하여 "제품에 대한 긍정적 또는 부정적 리뷰를 무한히 생성"하는 시연을 하기도 했다.[25]

또 다른 우려는 GPT-2가 음란하거나 인종차별적인 내용을 담은 텍스트를 대량 생성하는 데 사용될 수 있다는 점이었다. 제레미 하워드와 같은 연구자들은 "이 기술이 트위터, 이메일, 웹을 그럴듯한 내용으로 가득 채워 다른 모든 목소리를 묻어버리고, 필터링조차 불가능하게 만들 수 있다"고 경고했다.[26] 이러한 우려에 대응하여, 앨런 인공지능 연구소는 GPT-2와 같은 모델이 생성한 "신경망 가짜 뉴스"를 탐지하는 도구를 발표하기도 했다.[29]

그러나 OpenAI의 이러한 결정에 대해 비판적인 목소리도 높았다. 2019년 2월 The Verge는 GPT-2가 제기하는 위협이 과장되었다고 주장했다.[37] 캘리포니아 공과대학교(Caltech) 교수이자 엔비디아(Nvidia)의 머신러닝 연구 책임자인 애니마 아난드쿠마르(Anima Anandkumar)는 OpenAI가 주장하는 위험에 대한 증거가 부족하며, 그들의 폐쇄적인 태도는 "열린 연구와 정반대"라고 비판했다. 그녀는 모델 전체 공개를 거부하는 것을 "악의적인 허튼 소리(bullshit)"라고 강하게 표현했다.[37]

''The Gradient''는 OpenAI에 모델 공개를 촉구하는 공개 서한을 보냈다. 이 서한에서는 텍스트 생성 AI의 위험성을 과거 인쇄기가 등장했을 때의 우려와 비교하며, 포토샵처럼 사회가 기술에 적응할 수 있다고 주장했다. 서한은 "포토샵이 등장한 지 30년이 지나 고등학생도 쉽게 사용하고 일상적인 용어가 될 정도로 보편화되었지만, 사회는 비교적 큰 문제 없이 유지되고 있다. 이는 모든 사람이 포토샵에 대해 알고 있기 때문"이라며 기술 공개의 중요성을 강조했다.[38]

5. 2. 774M 공개 (774M release)

2019년 8월 20일, OpenAI는 7억 7,400만 개의 매개변수를 가진 GPT-2의 부분 버전을 공개했다. 이는 전체 15억 매개변수 모델의 약 절반 크기에 해당한다.[27]OpenAI는 완전히 훈련된 모델이나 훈련 말뭉치를 공개하지 않았지만, 기존에 발표된 기술 문서와 기반 기술의 접근성 덕분에 다른 개발자들이 자유 소프트웨어 형태로 GPT-2를 복제할 수 있었다. 이러한 복제본 중 하나인 OpenGPT-2는 2019년 8월, 자유 라이선스 버전의 WebText인 OpenWebText와 함께 공개되었다. OpenGPT-2를 개발하는 데 사용된 클라우드 컴퓨팅 비용은 약 5만달러로 추산되었다.[33]

5. 3. 완전판 1.5B 공개 (Full 1.5B release)

GPT-2가 광범위하게 악용될 것이라는 초기 우려는 현실화되지 않았다. ''The Verge''는 "AI 기술이 일종의 '정보 종말'을 가져올 것이라는 주장에 대해 회의적인 시각을 가져야 할 이유가 있다. 우선, 우리는 이미 적은 비용으로 대량의 그럴듯한 텍스트를 생성할 수 있는 프로그램, 즉 인간을 가지고 있다."[36]라고 지적했다. 2019년 11월, OpenAI는 "지금까지 악용에 대한 강력한 증거를 발견하지 못했다"고 밝혔으며, 15억 개의 파라미터를 가진 전체 버전 모델을 2019년 11월 5일에 공개했다. 이 모델은 40GB의 데이터(이는 "셰익스피어 전집보다 약 8천 배 큰" 규모)로 학습되었다.[28]5. 4. 소형 및 중간 릴리스 (Small and Medium Releases)

GPT-2는 1억 2,400만 개의 매개변수를 가진 소형 버전과 3억 5,500만 개의 매개변수를 가진 중간 크기 버전도 출시되었다. 이 두 버전은 허깅 페이스에서 다운로드할 수 있다.[4][5]6. 한계 (Limitations)

GPT-2가 그럴듯한 자연어 텍스트를 생성하는 능력은 긍정적인 평가를 받지만, 특히 여러 문단 이상의 긴 글을 만들 때 한계가 지적된다. 복스는 "산문이 꽤 거칠고, 때로는 비합리적이며, 기사가 길어질수록 일관성이 떨어진다"고 평가했다.[75][24] 더 버지 역시 GPT-2로 작성된 긴 글은 "주제에서 벗어나는" 경향이 있고 전반적인 일관성이 부족하다고 지적했다.[76][26] 더 레지스터는 "사람이 그것을 읽으면 잠시 후에 무언가 문제가 있음을 깨달아야 한다"고 언급하며, GPT-2가 정보를 추출하고 검색하는 알고리즘에 의존하는 다른 시스템만큼 질문에 잘 답하지 못한다고 덧붙였다.[77][31] 암스테르담 대학교의 연구에서는 수정된 튜링 테스트를 통해, 일부 시나리오에서 참가자들이 GPT-2가 생성한 시와 사람이 쓴 시를 구별하지 못했다는 결과를 발표하기도 했다.[2]

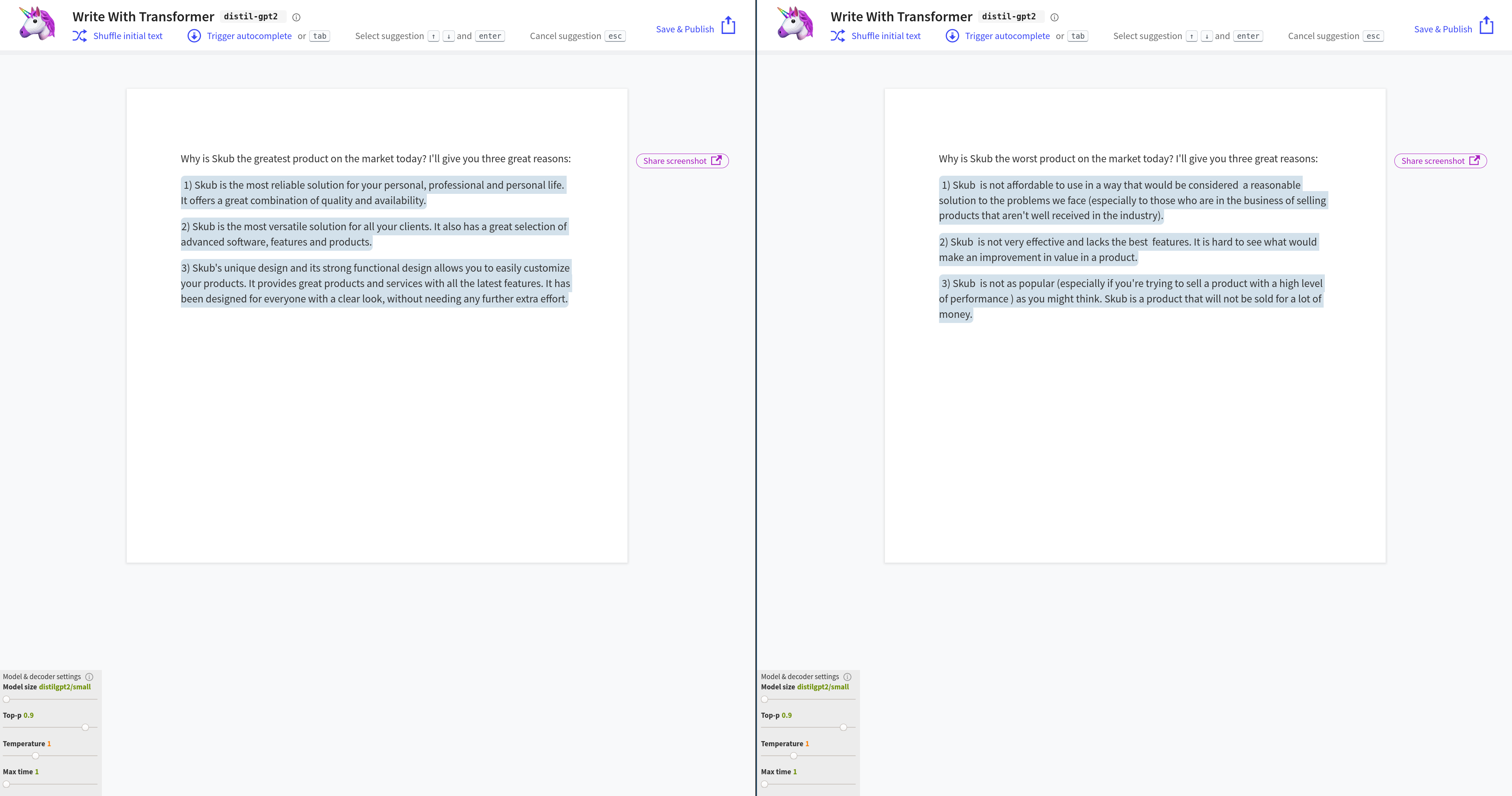

GPT-2를 실제 서비스에 적용하는 것은 많은 리소스를 필요로 한다. 모델의 정식 버전은 5기가바이트가 넘어 로컬 애플리케이션에 내장하기 어렵고, 많은 양의 RAM을 소비한다. 또한, 단일 예측을 수행하는 데 CPU 사용률이 100%에 달하며 몇 분이 소요될 수 있고, GPU를 사용하더라도 예측 하나에 몇 초가 걸릴 수 있다.[68] 이러한 문제를 완화하기 위해 허깅 페이스는 지식 증류 기법을 사용하여 '''DistilGPT2'''라는 더 작은 모델을 개발했다. DistilGPT2는 일부 품질 평가 기준에서 점수가 다소 낮지만, 원본 모델보다 "33% 더 작고 두 배 빠르다".[68]

7. 구현 및 차기 연구 (Application and subsequent research)

언론에서 설명한 GPT-2의 잠재적 응용 분야에는 뉴스 기사와 같은 텍스트를 작성하는 데 인간을 돕는 것이 포함된다.[78] GPT-2는 정식 버전 출시 이전부터 엔터테인먼트뿐만 아니라 다양한 애플리케이션과 서비스에 활용되었다.[79] 2019년 6월에는 'r/SubSimulatorGPT2'라는 서브레딧이 만들어졌는데, 이곳에서는 서로 다른 서브레딧에서 훈련된 여러 GPT-2 인스턴스가 게시물을 작성하고 서로의 댓글에 응답하는 모습을 볼 수 있었다. 예를 들어 "r/비트코인의 AI 의인화가 r/ShittyFoodPorn에서 파생된 머신러닝 정신과 논쟁을 벌이는" 상황이 연출되기도 했다.[79][36] 같은 해 7월에는 다양한 프로그래밍 언어의 코드 라인을 자동 완성하는 GPT-2 기반 소프트웨어 프로그램이 출시되어 사용자들로부터 "획기적인 변화(게임 체인저)"라는 평가를 받았다.[80][35]

2019년에는 사용자 입력을 기반으로 동적인 텍스트 어드벤처 게임을 생성하는 AI Dungeon이 출시되었다.[81][41] AI Dungeon은 현재 선택적인 유료 업그레이드를 통해 가장 큰 규모의 GPT-3 API 접근을 제공하며, 무료 버전에서는 GPT-3의 두 번째로 큰 규모의 릴리스를 사용한다.[82][40] AI Dungeon을 중심으로 설립된 회사인 래티튜드(Latitude)는 2021년에 시드 자금으로 330만달러를 유치했다.[83][39] 여러 웹사이트에서는 GPT-2 및 다른 트랜스포머 모델의 다양한 인스턴스에 대한 대화형 데모를 제공하고 있다.[84][85][86][6][7][8]

2021년 2월, 어려움을 겪는 십대를 위한 위기 센터에서는 상담사 훈련을 돕기 위해 GPT-2에서 파생된 챗봇을 활용하기 시작했다고 발표했다. 이 챗봇은 시뮬레이션된 십대와의 대화 연습에 사용되며, 실제 청소년과 직접 소통하는 데 사용되지는 않고 순전히 내부 교육 목적으로만 활용된다.[87][34]

2023년 5월 9일, OpenAI는 GPT-2의 매핑된 버전을 출시했다. OpenAI는 후속 모델인 GPT-4를 사용하여 GPT-2의 각 뉴런을 매핑하고 그 기능을 분석했다.[88][9]

8. 성능 및 평가 (Performance and evaluation)

GPT-2는 방대한 데이터 세트와 기술 덕분에 단순한 텍스트 생성 외에도 다양한 작업을 수행할 수 있게 되었다. 즉, 질문에 답하고 요약하며, 심지어 일련의 단어에서 다음 단어를 예측하는 방법 외에는 별다른 지시 없이도 다양한 도메인별(specific domains) 언어 간의 기계 번역까지 수행할 수 있었다.[26][24]

2019년 2월 The Verge의 제임스 빈센트(James Vincent)는 GPT-2가 생성한 글이 일반적으로 비인간적인 것으로 쉽게 식별될 수 있다고 평가하면서도, 언어 생성 프로그램의 "가장 흥미로운 예시 중 하나"라고 언급했다.[26] 그는 "가짜 헤드라인을 입력하면 가짜 인용문과 통계가 포함된 기사의 나머지 부분을 작성합니다. 짧은 이야기의 첫 줄을 입력하면 다음에 등장인물에게 무슨 일이 일어날지 알려줍니다. 적절한 프롬프트가 주어지면 팬픽션도 쓸 수 있습니다."라고 덧붙였다.[26] The Guardian은 GPT-2의 결과물을 "그럴듯한 신문 기사"라고 묘사했으며,[25] 복스 미디어(Vox)의 켈시 파이퍼(Kelsey Piper)는 "내가 본 가장 멋진 AI 시스템 중 하나가 나를 해고할 수도 있다"고 평가했다.[24] GPT-2의 유연성은 The Verge에 의해 "인상적"이라고 평가되었으며, 특히 언어 간 텍스트 번역, 긴 기사 요약, 퀴즈 질문에 답하는 능력이 주목받았다.[26]

암스테르담 대학교의 한 연구에서는 수정된 튜링 테스트를 사용하여, 적어도 일부 상황에서는 참가자들이 GPT-2가 생성한 시와 인간이 쓴 시를 구별하지 못한다는 사실을 발견했다.[2]

GPT-2는 일반화된 학습 능력의 한 예로 프랑스어와 영어 간의 기계 번역을 수행할 수 있었다. 이 성능은 WMT-14 번역 작업을 통해 평가되었다. GPT-2의 훈련 데이터에는 프랑스어 텍스트가 거의 포함되지 않았다. 훈련 데이터 정제 과정에서 비영어 텍스트가 의도적으로 제거되었기 때문에, 전체 40,000MB 중 약 10MB의 프랑스어 텍스트(대부분 영어 게시물 내 외국어 인용문)만이 학습에 사용될 수 있었다.[20]

이러한 제약에도 불구하고, GPT-2는 WMT-14 영어-프랑스어 테스트 세트에서 5 BLEU 점수를 달성했다. 이는 단어 대 단어 대체 번역 점수보다는 약간 낮은 수준이다. 프랑스어-영어 테스트 세트에서는 11.5 BLEU 점수를 기록하여, 2017년 당시의 여러 비지도 기계 번역 모델들의 성능을 능가했다. 하지만 2019년 당시 최고 성능의 비지도 번역 모델이 달성한 33.5 BLEU 점수보다는 낮았다.[20] 그럼에도 불구하고, 다른 모델들이 상당한 양의 프랑스어 텍스트를 사용하여 이러한 결과를 얻은 반면, GPT-2는 비교 대상 모델들이 사용한 단일 언어 프랑스어 코퍼스 크기의 약 1/500 수준의 데이터만으로 해당 성능을 달성한 것으로 추정된다.[20]

참조

[1]

웹사이트

gpt-2

https://github.com/o[...]

2023-03-13

[2]

논문

Artificial intelligence versus Maya Angelou: Experimental evidence that people cannot differentiate AI-generated from human-written poetry

2021-01-01

[3]

웹사이트

Language & Coding Creativity {{!}} American Academy of Arts and Sciences

https://www.amacad.o[...]

2022-04-13

[4]

웹사이트

GPT-2 Small

https://huggingface.[...]

2024-10-29

[5]

웹사이트

Openai-community/Gpt2-medium · Hugging Face

https://huggingface.[...]

[6]

웹사이트

Write With Transformer

https://transformer.[...]

2019-12-04

[7]

웹사이트

Talk to Transformer

https://talktotransf[...]

2019-12-04

[8]

웹사이트

CreativeEngines

https://creativeengi[...]

2021-06-25

[9]

웹사이트

Language models can explain neurons in language models

https://openai.com/r[...]

2023-05-13

[10]

논문

Aligning Books and Movies: Towards Story-Like Visual Explanations by Watching Movies and Reading Books

https://www.cv-found[...]

2023-02-05

[11]

웹사이트

Language & Coding Creativity {{!}} American Academy of Arts and Sciences

https://www.amacad.o[...]

2022-04-13

[12]

웹사이트

GPT-2: 1.5B Release

https://openai.com/b[...]

2019-11-14

[13]

웹사이트

GPT-3: An AI that's eerily good at writing almost anything

https://arr.am/2020/[...]

2020-07-09

[14]

간행물

OpenAI is giving Microsoft exclusive access to its GPT-3 language model

https://www.technolo[...]

2020-09-25

[15]

논문

Attention is All you Need

https://proceedings.[...]

Curran Associates, Inc.

2017

[16]

arXiv

Neural Machine Translation by Jointly Learning to Align and Translate

2014-09-01

[17]

arXiv

Effective Approaches to Attention-based Neural Machine Translation

2015-08-17

[18]

논문

Attention and Augmented Recurrent Neural Networks

https://distill.pub/[...]

2021-01-22

[19]

웹사이트

Improving Language Understanding by Generative Pre-Training

https://cdn.openai.c[...]

OpenAI

2021-01-23

[20]

논문

Language models are unsupervised multitask learners

https://cdn.openai.c[...]

2020-12-19

[21]

arXiv

Unsupervised Paraphrase Generation using Pre-trained Language Models

2020-06-09

[22]

웹사이트

Better Language Models and Their Implications

https://openai.com/b[...]

OpenAI

2020-12-19

[23]

arXiv

A Simple Method for Commonsense Reasoning

2018-06-07

[24]

웹사이트

An AI helped us write this article

https://www.vox.com/[...]

2019-02-14

[25]

웹사이트

New AI fake text generator may be too dangerous to release, say creators

https://www.theguard[...]

2020-12-19

[26]

웹사이트

OpenAI's new multitalented AI writes, translates, and slanders

https://www.theverge[...]

2020-12-19

[27]

웹사이트

OpenAI releases curtailed version of GPT-2 language model

https://venturebeat.[...]

VentureBeat

2020-12-19

[28]

웹사이트

OpenAI has published the text-generating AI it said was too dangerous to share

https://www.theverge[...]

2020-12-19

[29]

뉴스

Could 'fake text' be the next global political threat?

https://www.theguard[...]

2019-07-04

[30]

웹사이트

The Staggering Cost of Training SOTA AI Models

https://syncedreview[...]

null

2021-02-27

[31]

웹사이트

Roses are red, this is sublime: We fed OpenAI's latest chat bot a classic Reg headline

https://www.theregis[...]

null

2021-02-27

[32]

웹사이트

Google open-sources framework that reduces AI training costs by up to 80%

https://venturebeat.[...]

null

2021-02-27

[33]

웹사이트

OpenGPT-2: We Replicated GPT-2 Because You Can Too

https://blog.usejour[...]

Noteworthy

2021-02-27

[34]

웹사이트

An AI is training counselors to deal with teens in crisis

https://www.technolo[...]

MIT Technology Review

2021-02-27

[35]

웹사이트

This AI-powered autocompletion software is Gmail's Smart Compose for coders

https://www.theverge[...]

null

2021-02-27

[36]

웹사이트

There's a subreddit populated entirely by AI personifications of other subreddits

https://www.theverge[...]

2021-02-27

[37]

웹사이트

AI researchers debate the ethics of sharing potentially harmful programs

https://www.theverge[...]

The Verge

2021-02-27

[38]

웹사이트

OpenAI: Please Open Source Your Language Model

https://thegradient.[...]

The Gradient

2021-02-28

[39]

웹사이트

AI Dungeon-maker Latitude raises $3.3M to build games with 'infinite' story possibilities

https://techcrunch.c[...]

TechCrunch

2021-02-27

[40]

웹사이트

This AI-Powered Choose-Your-Own-Adventure Text Game Is Super Fun and Makes No Sense

https://gizmodo.com/[...]

2021-02-27

[41]

웹사이트

AI Dungeon 2, the Text Adventure Where You Can do Nearly Anything, Is Now on Mobile

https://www.usgamer.[...]

2021-02-27

[42]

ArXiv

Language Models are Few-Shot Learners

2020-07-22

[43]

간행물

Aligning Books and Movies: Towards Story-Like Visual Explanations by Watching Movies and Reading Books

https://www.cv-found[...]

2015

[44]

문서

Our largest model, GPT-2, is a 1.5B parameter Transformer

[45]

문서

a new dataset of millions of webpages called WebText ... which emphasizes document quality.

[46]

문서

Our approach motivates building as large and diverse a dataset as possible in order to collect natural language demonstrations of tasks in as varied of domains and contexts as possible.

[47]

문서

Common Crawl ... they have significant data quality issues ... We observed similar data issues in our initial experiments with Common Crawl.

[48]

문서

emphasizes document quality. To do this we only scraped web pages which have been curated/filtered by humans.

[49]

문서

we scraped all outbound links from Reddit, a social media platform, which received at least 3 karma.

[50]

문서

他の多くのデータセットに含まれているので、[[過剰適合]]の原因となる可能性があった

[51]

문서

a preliminary version of WebText ... which ... contains slightly over 8 million documents for a total of 40 GB of text.

[52]

문서

Layer normalization ... was moved to the input of each sub-block

[53]

문서

an additional layer normalization was added after the final self-attention block.

[54]

문서

A modified initialization which accounts for the accumulation on the residual path with model depth ... scale the weights of residual layers at initialization by a factor of 1/√N where N is the number of residual layers.

[55]

문서

The vocabulary is expanded to 50,257.

[56]

문서

We also increase the context size from 512 to 1024 tokens

[57]

문서

a larger batchsize of 512 is used.

[58]

간행물

Artificial intelligence versus Maya Angelou: Experimental evidence that people cannot differentiate AI-generated from human-written poetry

2021-01-01

[59]

웹사이트

Write With Transformer

https://transformer.[...]

2019-12-04

[60]

웹사이트

Talk to Transformer

https://talktotransf[...]

2019-12-04

[61]

웹사이트

CreativeEngines

https://creativeengi[...]

2021-06-25

[62]

웹인용

gpt-2

https://github.com/o[...]

2023-03-13

[63]

웹인용

A poetry-writing AI has just been unveiled. It's ... pretty good.

https://www.vox.com/[...]

2020-12-19

[64]

웹인용

OpenAI releases curtailed version of GPT-2 language model

https://venturebeat.[...]

VentureBeat

2020-12-19

[65]

웹인용

OpenAI has published the text-generating AI it said was too dangerous to share

https://www.theverge[...]

2020-12-19

[66]

웹인용

Better Language Models and Their Implications

https://openai.com/b[...]

OpenAI

2020-12-19

[67]

ArXiv

Unsupervised Paraphrase Generation using Pre-trained Language Models

2020-06-09

[68]

웹인용

Too big to deploy: How GPT-2 is breaking servers

https://towardsdatas[...]

2021-02-27

[69]

웹인용

Improving Language Understanding by Generative Pre-Training

https://cdn.openai.c[...]

OpenAI

2021-01-23

[70]

ArXiv

Attention Is All You Need

2017-06-12

[71]

저널

Attention and Augmented Recurrent Neural Networks

https://distill.pub/[...]

2021-01-22

[72]

ArXiv

Neural Machine Translation by Jointly Learning to Align and Translate

2014-09-01

[73]

ArXiv

Effective Approaches to Attention-based Neural Machine Translation

2015-08-17

[74]

웹인용

GPT-2: 1.5B Release

https://openai.com/b[...]

2019-11-14

[75]

웹인용

An AI helped us write this article

https://www.vox.com/[...]

2020-12-19

[76]

웹인용

OpenAI's new multitalented AI writes, translates, and slanders

https://www.theverge[...]

2020-12-19

[77]

웹인용

Roses are red, this is sublime: We fed OpenAI's latest chat bot a classic Reg headline

https://www.theregis[...]

2021-02-27

[78]

웹인용

New AI fake text generator may be too dangerous to release, say creators

https://www.theguard[...]

2020-12-19

[79]

웹인용

There's a subreddit populated entirely by AI personifications of other subreddits

https://www.theverge[...]

2021-02-27

[80]

웹인용

This AI-powered autocompletion software is Gmail's Smart Compose for coders

https://www.theverge[...]

2021-02-27

[81]

웹인용

AI Dungeon 2, the Text Adventure Where You Can do Nearly Anything, Is Now on Mobile

https://www.usgamer.[...]

2021-02-27

[82]

웹인용

This AI-Powered Choose-Your-Own-Adventure Text Game Is Super Fun and Makes No Sense

https://gizmodo.com/[...]

2021-02-27

[83]

웹인용

AI Dungeon-maker Latitude raises $3.3M to build games with 'infinite' story possibilities

https://techcrunch.c[...]

TechCrunch

2021-02-27

[84]

웹인용

Write With Transformer

https://transformer.[...]

2019-12-04

[85]

웹인용

Talk to Transformer

https://talktotransf[...]

2019-12-04

[86]

웹인용

CreativeEngines

https://creativeengi[...]

2021-06-25

[87]

웹인용

An AI is training counselors to deal with teens in crisis

https://www.technolo[...]

MIT Technology Review

2021-02-27

[88]

웹인용

Language models can explain neurons in language models

https://openai.com/r[...]

2023-05-13

관련 사건 타임라인

( 최근 20개의 뉴스만 표기 됩니다. )

딥시크에 자극 받은 오픈AI, 6년 만에 개방형 모델 공개

오픈AI, 오픈웨이트 추론모델 ‘gpt-oss’ 공개 – 바이라인네트워크

오픈AI 6년 만에 ‘개방형 모델’…중국과 생태계 확보 경쟁

오픈AI, 다시 소스코드 공개하나? – 바이라인네트워크

오픈AI 400억달러 투자 유치···기업가치, 5개월 사이 2배 껑충

네이버의 생성AI는 챗GPT가 안 부럽다 – 바이라인네트워크

두 기자가 만난 이루다, 그리고 뒷담화 – 바이라인네트워크

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com