교차 엔트로피

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

교차 엔트로피는 동일한 확률 공간에서 정의된 두 확률 분포 p와 q 사이의 관계를 나타내는 개념이다. 이는 q의 p에 대한 정보 엔트로피와 쿨백-라이블러 발산의 합으로 표현되며, 이산 및 연속 확률 분포에 따라 다르게 정의된다. 교차 엔트로피는 정보 이론에서 데이터 압축 효율성을 평가하는 데 사용되며, 머신 러닝에서 손실 함수를 정의하는 데 활용된다. 특히 로지스틱 회귀 모델에서 교차 엔트로피 손실은 모델의 예측과 실제 값 간의 차이를 측정하는 데 사용되며, 최대 가능도 추정과 밀접한 관련이 있다. 또한, 앙상블 모델의 성능 향상을 위해 교차 엔트로피를 수정하여 사용할 수도 있다.

더 읽어볼만한 페이지

- 정보 엔트로피 - 최대 엔트로피 원리

최대 엔트로피 원리는 주어진 제약 조건에서 정보 엔트로피를 최대화하는 확률 분포를 선택하는 원리로, 불완전한 정보나 불확실성 하에서 시스템의 확률 분포를 추정하거나 최적의 결정을 내리는 데 활용되며 다양한 분야에 응용된다. - 정보 엔트로피 - 쿨백-라이블러 발산

쿨백-라이블러 발산은 두 확률 분포의 차이를 측정하는 비대칭적인 척도로, 정보 이론, 통계학, 기계 학습 등에서 활용되며, 두 분포가 동일할 때만 0의 값을 갖는다.

| 교차 엔트로피 | |

|---|---|

| 개요 | |

| 유형 | 정보 이론적 측정 |

| 세부 사항 | |

| 사용 분야 | 기계 학습 패턴 인식 특징 선택 교차 엔트로피 방법 인공 신경망 확률 모델 |

| 정의 | |

| 확률 변수 (이산) | H(p, q) = - Σx p(x) log q(x) |

| 확률 변수 (연속) | - ∫X p(x) log q(x) dx |

2. 정의

동일한 확률 공간에서 정의된 두 확률 분포 p와 q에 대해, q의 p에 대한 교차 엔트로피는 다음과 같이 정의된다.

:

여기서 는 분포 에 대한 기댓값 연산자이다.

이는 쿨백-라이블러 발산 (q에 대한 p의 상대 엔트로피)를 사용하여 다음과 같이 나타낼 수 있다.

:

여기서 는 의 엔트로피이다.

이산 및 연속 확률 분포에 대한 교차 엔트로피 공식은 하위 섹션에서 각각 확인할 수 있다.

참고: 는 결합 엔트로피에도 사용되는 표기법이므로 주의해야 한다.

2. 1. 이산 확률 분포

동일한 지지 집합 을 갖는 이산 확률 변수 와 에 대한 확률 분포의 경우, 교차 엔트로피는 다음과 같이 계산된다.:

2. 2. 연속 확률 분포

연속 확률 변수의 경우, 교차 엔트로피는 다음과 같이 계산된다.:

와 가 특정 기준 측도 에 대해 절대 연속이라고 가정해야 한다. (일반적으로 은 보렐 집합 σ-대수에 대한 르베그 측도이다.) 와 를 에 대한 와 의 확률 밀도 함수라고 하면, 다음이 성립한다.

참고: 는 와 의 결합 엔트로피와 같은 다른 개념에도 사용된다.

2. 3. 쿨백-라이블러 발산과의 관계

분포 에 대한 분포 의 교차 엔트로피는 쿨백-라이블러 발산을 사용하여 다음과 같이 나타낼 수 있다.:

여기서 는 의 엔트로피이고, 는 에서 로의 쿨백-라이블러 발산(상대 엔트로피)이다.

만약 와 가 이산 확률 변수라면, 위 식은 다음과 같다.

:

연속 확률 변수의 경우에도 유사하게 다음과 같다.

:

라는 표기법은 결합 엔트로피에도 사용되므로 주의해야 한다.

3. 정보 이론에서의 의미

정보 이론에서 크라프트-맥밀란 정리는 일련의 가능성 중 하나의 값 를 식별하기 위해 메시지를 코딩하는 모든 직접 디코딩 가능한 코딩 방식이 에 대한 암시적 확률 분포 를 나타내는 것으로 볼 수 있음을 확립한다. 여기서 는 에 대한 코드의 길이(비트 단위)이다. 따라서 교차 엔트로피는 실제 데이터가 분포 를 따르는 동안 잘못된 분포 가 가정될 때 데이터당 예상 메시지 길이로 해석될 수 있다. 따라서 기대값은 참 확률 분포 에 대해 취해지며 에 대해 취해지지 않는다. 실제로 참 분포 에 따른 예상 메시지 길이는 다음과 같다.

4. 추정

실제 분포 를 알 수 없는 경우가 많다. 언어 모델링이 그 예시인데, 학습 세트 를 기반으로 모델을 만들고, 모델이 테스트 데이터를 얼마나 정확하게 예측하는지 평가하기 위해 테스트 세트에서 교차 엔트로피를 측정한다. 이 예에서, 는 모든 말뭉치에서 단어의 실제 분포이고, 는 모델이 예측한 단어의 분포이다. 실제 분포를 알 수 없으므로 교차 엔트로피를 직접 계산할 수 없다. 이러한 경우, 교차 엔트로피의 추정치는 다음 공식을 사용하여 계산된다.

:

여기서 은 테스트 세트의 크기이고, 는 학습 세트에서 추정된 이벤트 의 확률이다. 즉, 는 텍스트의 i번째 단어가 일 확률에 대한 모델의 확률 추정치이다. 합은 테스트의 개 단어에 대해 평균이 계산된다. 이것은 실제 교차 엔트로피의 몬테 카를로 추정으로, 테스트 세트를 에서 추출한 표본으로 취급한다.

5. 최대 가능도 추정과의 관계

교차 엔트로피는 로그 가능도 함수의 형태로 로그를 도입할 때 분류 문제에서 발생한다.

분류 문제에서 서로 다른 사건의 확률을 추정한다고 가정하자. N개의 샘플로 구성된 훈련 집합 내에서 사건 의 빈도(경험적 확률)가 이고, 사건 의 확률이 로 추정되었다고 하면, 훈련 집합의 우도는 다음과 같다.

:

이 로그 우도를 N으로 나누면,

:

가 되며, 이 우도를 최대화하는 것은 교차 엔트로피를 최소화하는 것과 동일하다.

로그는 단조 증가 함수이므로 극대화에 영향을 미치지 않는다. 따라서 가능도 최대화는 교차 엔트로피의 최소화와 같다.

6. 교차 엔트로피 최소화

교차 엔트로피 최소화는 최적화 문제와 희소 사건의 예측에 자주 사용되는 기법이다(교차 엔트로피 방법).[1][2]

확률 분포 $q$를 참조용 고정 확률 분포 $p$와 비교했을 때, 교차 엔트로피와 쿨백-라이블러 발산은 ($p$가 고정되어 있으므로) 부가적인 상수를 제외하면 동일하다. 둘 다 $p = q$일 때 최소값을 가지며, 쿨백-라이블러 발산 값은 $0$, 교차 엔트로피 값은 $\mathrm{H}(p)$가 된다.

깁스 부등식에 따르면, 쿨백-라이블러 발산의 경우 $p=q$일 때 최소값 0을 가지며, 교차 엔트로피의 경우 $\mathrm{H}(p)$를 갖는다. 공학 문헌에서 쿨백-라이블러 발산 최소화 원리(최소 차별 정보 원리)는 종종 최소 교차 엔트로피 원리(MCE), 또는 민젠트라고 불린다.

단, 쿨백-라이블러 발산에서 보듯이, ''q''를 고정된 참조용 확률 분포로 하고, ''p''를 최적화하여 ''q''에 가깝게 하는 경우도 있다. 이 경우의 최소화는 교차 엔트로피의 최소화가 아니다. 문헌에서 어느 기법으로 설명하고 있는지 주의할 필요가 있다.

7. 교차 엔트로피 손실 함수

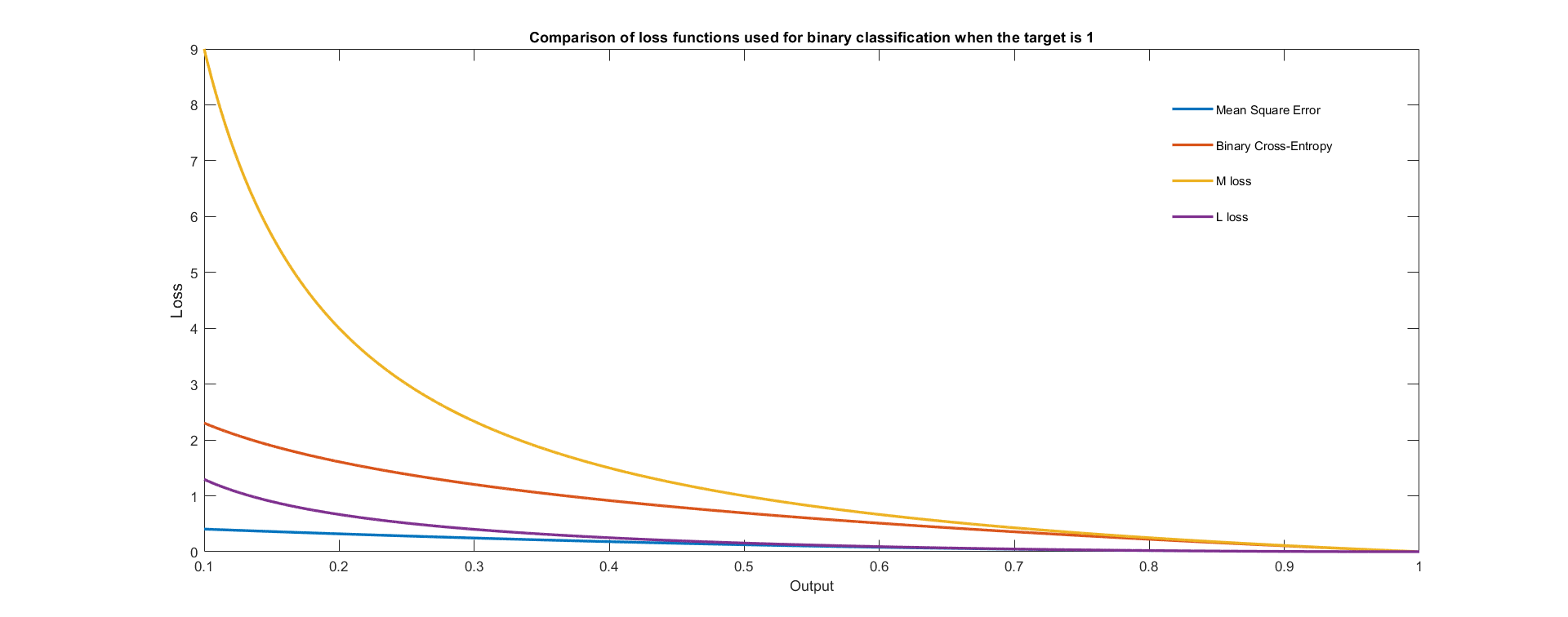

교차 엔트로피는 머신 러닝 및 최적화에서 모델의 예측 값과 실제 값 사이의 차이를 나타내는 손실 함수로 사용된다. 참 확률 는 참 레이블이고, 주어진 분포 는 현재 모델의 예측값이다.[3] 이는 로그 손실(로지스틱 손실)이라고도 하며,[4][5] "로그 손실"과 "교차 엔트로피 손실"이라는 용어는 서로 바꿔서 사용된다.[6]

7. 1. 로지스틱 회귀

머신 러닝에서 이진 회귀 모델, 특히 로지스틱 회귀는 로지스틱 함수(시그모이드 함수) 를 사용하여 확률을 모델링한다. 여기서 는 입력 벡터 의 함수이며, 일반적으로 선형 함수이다. 출력 의 확률은 다음과 같이 주어진다.[3][4][5][6]:

여기서 가중치 벡터 는 경사 하강법과 같은 알고리즘을 통해 최적화된다. 출력 을 찾을 수 있는 보완 확률은 다음과 같다.

:

및 를 사용하여, 교차 엔트로피를 통해 와 사이의 비유사성을 측정할 수 있다.

:

로지스틱 회귀는 일반적으로 훈련된 모든 관측치에 대해 로그 손실을 최적화하며, 이는 샘플의 평균 교차 엔트로피를 최적화하는 것과 같다.[7] 각 샘플이 으로 인덱싱된 개의 샘플이 있다고 가정하면, 손실 함수의 평균은 다음과 같다.

:

여기서 이며, 는 로지스틱 함수이다.

로지스틱 손실은 교차 엔트로피 손실 또는 로그 손실이라고도 불린다.[8] 로지스틱 회귀에 대한 교차 엔트로피 손실의 기울기는 선형 회귀에 대한 제곱 오차 손실의 기울기와 같다.

8. 수정된 교차 엔트로피

모델 앙상블을 훈련시켜 결합하면 예측 정확도가 향상될 수 있다.[9][10]

개 분류기 앙상블의 출력을 평균하여 수정된 교차 엔트로피를 구성한다고 가정하면, 수정된 교차 엔트로피는 다음과 같이 주어진다.

:

여기서 는 분류기의 비용 함수이고, 는 분류기의 출력 확률이며, 는 추정할 참 확률이고, 는 앙상블 간에 설정하려는 '다양성'을 정의하는 0과 1 사이의 매개변수이다. 일 때, 각 분류기는 앙상블과 관계없이 최선을 다하기를 원하며, 일 때, 분류기가 가능한 한 다양하기를 원한다.

참조

[1]

서적

Elements of Information Theory

Wiley

[2]

논문

Maximum entropy for hypothesis formulation, especially for multidimensional contingency tables

1963

[3]

논문

Cross-entropy loss functions: Theoretical analysis and applications

https://arxiv.org/pd[...]

2023

[4]

서적

The Mathematics of Information Coding, Extraction and Distribution

https://books.google[...]

1999

[5]

서적

Probability for Machine Learning: Discover How To Harness Uncertainty With Python

2019

[6]

웹사이트

sklearn.metrics.log_loss

https://scikit-learn[...]

[7]

arXiv

Alternate loss functions for classification and robust regression can improve the accuracy of artificial neural networks

2023-03-17

[8]

서적

Machine Learning: A Probabilistic Perspective

MIT

2012

[9]

conference

Cyber Security Cryptography and Machine Learning – Third International Symposium, CSCML 2019, Beer-Sheva, Israel, June 27–28, 2019, Proceedings

Springer

[10]

arXiv

Amended Cross Entropy Cost: Framework For Explicit Diversity Encouragement

2020

[11]

서적

Machine Learning: A Probabilistic Perspective

MIT

2012

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com