최소제곱법

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

최소제곱법은 관측된 데이터와 가장 잘 일치하는 모델을 찾는 데 사용되는 통계적 방법이다. 18세기에 천문학 및 측지학 분야에서 발전했으며, 여러 관측값을 결합하여 참값에 가장 가까운 추정치를 얻는 데 기여했다.

최소제곱법은 회귀 모델의 매개변수를 추정하기 위해 사용되며, 선형 최소제곱법과 비선형 최소제곱법으로 나뉜다. 선형 최소제곱법은 모델이 매개변수의 선형 결합으로 표현될 때 사용되며, 정규 방정식을 통해 해를 구할 수 있다. 비선형 최소제곱법은 모델이 비선형적인 경우에 사용되며, 반복적인 수치 알고리즘을 통해 해를 찾아야 한다.

가중 최소제곱법은 잔차의 분산이 다른 경우에 사용되며, 정규화는 과적합 문제를 해결하기 위해 사용된다. 최소제곱법은 이상치에 민감하고 독립 변수의 오차를 고려하지 않는다는 한계가 있으며, 상수도 시설 규모 결정 및 인구수 추정 등 다양한 분야에 응용된다.

더 읽어볼만한 페이지

- 최소제곱법 - 평균 제곱 오차

평균 제곱 오차(MSE)는 추정량 또는 예측 변수의 정확성을 평가하는 척도로, 추정값과 실제 값 또는 예측값과 실제 관측값 사이의 오차 제곱 평균으로 계산되며, 추정량의 분산과 편향 제곱의 합으로 분해될 수 있고, 모델 적합성 평가 및 추정기 효율성 비교에 사용된다. - 최소제곱법 - 잔차 제곱합

잔차 제곱합(RSS)은 통계학에서 회귀 모델의 적합도를 평가하는 지표로, 예측값과 실제 값의 차이를 제곱하여 합산한 값이며, 결정 계수가 1에 가까울수록 회귀 모델이 데이터를 더 잘 설명한다. - 최적화 알고리즘 - 기댓값 최대화 알고리즘

- 최적화 알고리즘 - 유전 알고리즘

유전 알고리즘은 생물 진화 과정을 모방하여 최적해를 탐색하는 계산 최적화 기법으로, 해를 유전자로 표현하고 적합도 함수를 통해 평가하며 선택, 교차, 돌연변이 연산을 반복하여 최적해에 근접하는 해를 생성하며, 성능은 매개변수에 영향을 받고 초기 수렴 문제 해결을 위한 다양한 변형 기법과 관련 기법이 존재한다. - 수학적 최적화 - 제약된 최적화

제약된 최적화는 제약 조건을 만족하는 해 중에서 목적 함수를 최적화하는 해를 찾는 문제로, 자원 할당, 스케줄링 등에 활용되며, 다양한 제약 조건과 해법을 통해 해결될 수 있습니다. - 수학적 최적화 - 모서리해

모서리 해는 경제학에서 소비자가 예산 제약 하에 효용을 극대화할 때, 두 상품 중 하나만 소비하는 경우를 의미하며, 이는 소비자의 극단적인 선택이나 완전 대체재 관계에서 가격이 낮은 상품만 구매하는 경우 등에 나타나는 현상입니다.

2. 역사

대항해시대에 선박의 항해를 위해 천체의 정확한 위치를 파악하는 것은 매우 중요했는데, 이를 위해 과학자들은 천문학과 측지학 분야에서 정확한 관측과 계산 방법을 연구했다. 최소제곱법은 이러한 과정에서 발전하게 되었다.[6]

1805년 아드리앵마리 르장드르는 최소제곱법에 대한 최초의 명확한 설명을 출판했다.[7] 르장드르는 선형 방정식을 데이터에 맞추는 대수적 절차로 최소제곱법을 설명하고, 지구 모양에 대한 데이터를 분석하여 새로운 방법을 시연했다. 르장드르의 출판 이후, 최소제곱법은 프랑스, 이탈리아, 프로이센 등에서 천문학과 측지학의 표준 도구로 빠르게 채택되었다.

1809년 카를 프리드리히 가우스는 천체의 궤도를 계산하는 방법을 발표하면서, 1795년부터 최소제곱법을 알고 있었다고 주장했다.[8] 이로 인해 르장드르와 가우스 사이에 누가 먼저 최소제곱법을 개발했는지에 대한 논쟁이 벌어졌다. 가우스는 르장드르의 연구를 발전시켜 최소제곱법을 확률 이론 및 정규 분포와 연결하여 이론적 토대를 강화했다. 그는 산술 평균이 위치 매개변수에 대한 최상의 추정치임을 증명하고, 정규 분포를 사용하여 오차를 설명했다.

가우스의 방법은 세레스의 미래 위치를 예측하는 데 사용되면서 그 유용성이 입증되었다. 1801년 주세페 피아치가 발견한 세레스는 태양 빛 때문에 관측이 어려웠는데, 가우스는 최소제곱법을 이용하여 세레스의 위치를 정확하게 예측하여 헝가리 천문학자 프란츠 자버 폰 츠아흐가 세레스를 다시 찾는 데 도움을 주었다.

1810년 가우스의 저서를 읽은 피에르시몽 라플라스는 중심 극한 정리를 증명하고, 이를 통해 최소제곱법과 정규 분포에 대한 대규모 표본 정당성을 제시했다. 1822년 가우스는 최소제곱법이 오차가 평균이 0이고 상관관계가 없으며 정규 분포를 따르는 선형 모델에서 계수의 최상의 선형 불편 추정치를 제공한다는 것을 밝혔다. 이 결과는 가우스-마르코프 정리로 알려져 있다.

1808년 미국의 로버트 에이드리언은 최소제곱 분석에 대한 아이디어를 독자적으로 공식화하기도 했다. 이후 2세기 동안 오차 이론과 통계학 연구자들은 최소제곱법을 구현하는 다양한 방법을 발견했다.[9]

2. 1. 18세기 최소제곱법 발전에 기여한 주요 인물

1722년 로저 코츠는 여러 관측 결과를 결합하여 진정한 값의 최상의 추정치를 얻는 방법을 제시하고, 오차는 증가하는 대신 집계될수록 감소한다는 아이디어를 처음으로 표현했을 가능성이 있다.[6]토비아스 마이어는 1750년 달의 천칭동 연구에서, 피에르시몽 라플라스는 1788년 목성과 토성의 운동 차이를 설명하는 연구에서 동일한 조건에서 수행된 여러 관측 결과를 결합하는 '평균법'을 사용했다.[6]

로제프 보스코비치는 1757년 지구의 모양에 대한 연구에서, 피에르시몽 라플라스는 1789년과 1799년에 같은 문제에 대해 다른 조건에서 수행된 여러 관측 결과를 결합하는 '최소 절대 편차' 방법을 사용했다.[6]

라플라스는 최소 오차를 가진 해가 달성되었을 때를 결정하기 위해 평가할 수 있는 기준을 개발했다. 그는 오차에 대한 확률 밀도의 수학적 형태를 지정하고 추정 오차를 최소화하는 추정 방법을 정의하려고 시도했다. 이를 위해 라플라스는 현재 라플라스 분포라고 부르는 대칭적인 양면 지수 분포를 사용하여 오차 분포를 모델링하고, 추정 오차로 절대 편차의 합을 사용했다. 그는 이것이 그가 할 수 있는 가장 단순한 가정이라고 느꼈으며, 산술 평균을 최상의 추정치로 얻기를 바랐다. 대신 그의 추정량은 사후 중앙값이었다.[6]

3. 문제 정의

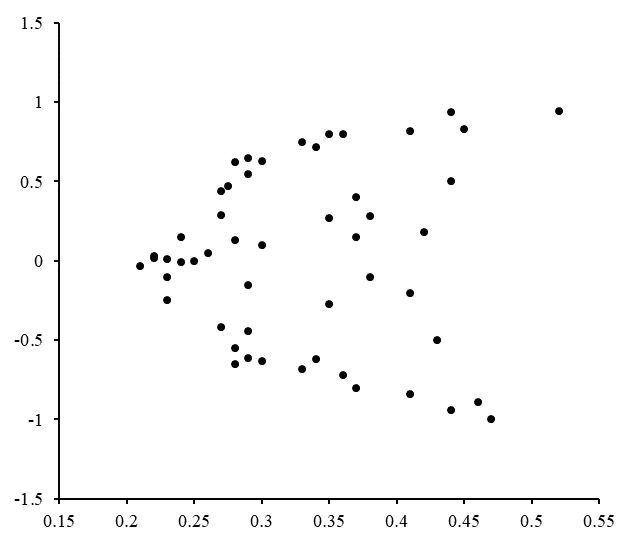

어떤 계에서 $n$개의 관측값 $(X_i, y_i)$ ($1 \le i \le n$)가 있을 때, 설명변수와 종속변수 간의 관계식을 추정하고자 한다. 회귀식의 설명변수는 $m$개가 있다고 가정한다. 설명변수 $x_{ij}$는 표본의 $i$번째 관측값의 $j$번 설명변수의 값으로 표기한다. 이 경우 회귀식은 다음과 같이 표현할 수 있다.

:$y_i=\beta_0 + \beta_1 x_{i1} +\beta_2 x_{i2}+ ...+\beta_m x_{im}+\epsilon$

이 식을 행렬의 꼴로 축약해 나타내면 다음과 같은 형태로 표현할 수 있다.

:$\mathbf{y}=\mathbf{X}\boldsymbol{\beta}+\boldsymbol{\epsilon}$

여기서 $\mathbf{y}$는 종속변수 관측값을 나타낸 벡터이고, $\mathbf{X}$는 설명변수를 모아 둔 디자인 행렬이다. $\boldsymbol{\beta}$는 모수 벡터이고, $\boldsymbol{\epsilon}$은 오차항을 모은 벡터이다. 이들을 행렬로 나타내면 다음과 같다.

:$\mathbf{y}=\begin{bmatrix} y_1 \\ y_2 \\ \vdots \\ y_n \end{bmatrix}$, $\mathbf{X}=\begin{bmatrix} 1 & x_{11} & x_{12} & \cdots & x_{1m} \\

1 & x_{21} & x_{22} & \cdots & x_{2m} \\

\vdots & \vdots & \vdots & \cdots & \vdots \\

1 & x_{n1} & x_{n2} & \cdots & x_{nm} \\

\end{bmatrix}$, $\boldsymbol{\beta}=\begin{bmatrix} \beta_0 \\ \beta_1 \\ \beta_2 \\ \vdots \\ \beta_m \end{bmatrix}$, $\boldsymbol{\epsilon}=\begin{bmatrix} \epsilon_1 \\ \epsilon_2 \\ \vdots \\ \epsilon_n \end{bmatrix}$

오차항의 제곱합 $S(\boldsymbol{\beta})=\sum_i \left[y_i - (\beta_0 + \beta_1 x_{i1} +\beta_2 x_{i2}+ ...+\beta_m x_{im})\right]^2$ 의 값을 최소로 만드는 $\boldsymbol \beta$를 구하는 것이 문제의 목표이다.

4. 선형 최소제곱법

선형 최소제곱법은 모델 함수가 매개변수들의 선형 결합으로 표현되는 경우에 적용된다. 예를 들어, 모델 함수는 다음과 같이 표현할 수 있다.

:

여기서 함수 는 의 함수이다.[12]

로 놓고 독립 변수와 종속 변수를 각각 행렬 와 에 넣으면, 최소 제곱법을 행렬을 사용하여 표현할 수 있다.[12][13]

:

손실 함수의 기울기를 0으로 설정하고 에 대해 풀면 다음을 얻는다.[13][12]

:

최소제곱법은 잔차의 제곱합을 최소화하는 방식으로 작동한다. 잔차는 실제 값과 모델 예측 값의 차이를 의미한다. 제곱합의 최소값은 기울기를 0으로 설정하여 찾는다. 모델에 ''m''개의 매개변수가 포함되어 있으므로, ''m''개의 기울기 방정식이 있다.[12]

:

그리고 이므로, 기울기 방정식은 다음과 같다.[12]

:

이 방정식은 모든 최소제곱 문제에 적용된다.

간단한 예시로, 용수철의 늘어남이 가해지는 힘 ''F''에 비례한다는 후크의 법칙을 생각해보자.

:

여기서 ''F''는 독립 변수이고, ''k''는 힘 상수이다. ''k''를 추정하기 위해 최소 제곱을 사용하며, 최소화할 제곱합은 다음과 같다.[12]

:

힘 상수 ''k''의 최소 제곱 추정값은 다음과 같다.

:

일반적으로, 측정값은 의 이차원 평면에 분포하고, 예상되는 분포(모델 함수)가 형태인 경우, 예상 함수 는 알려진 함수 의 선형 결합으로 표시된다.

:

예를 들어 ''''일 때는 라는 직선에 의한 근사(선형 회귀)가 된다.

측정으로 얻어진 수치 집합 이 있고, 이들의 분포가 라는 모델 함수를 따른다고 가정했을 때, 이론값으로부터의 오차의 분산의 추정값은 잔차의 제곱합으로 주어진다.

:

''''가 최소가 되도록 예상 분포 를 정하면 된다. ''''를 ''''에 대해 편미분한 것을 0으로 놓고, 이렇게 얻어진 ''''개의 연립 방정식(정규 방정식)을 풀어 ''''를 결정한다.

적합하려는 함수 ''''와 최소화해야 할 함수 ''''는 다음과 같다.

:

:

''''를 의 각 성분으로 편미분하여 0으로 둔 ''''개의 식(정규 방정식)은 행렬을 사용하여 나타낼 수 있다.

:

이것을 '''정규 방정식'''()이라고 부른다. 이 정규 방정식을 풀면 계수 해 를 구할 수 있다.

계수 해 는 역행렬, 콜레스키 분해, QR 분해, 특이값 분해 등을 사용하여 정규 방정식을 풀어 구할 수 있다.[29][30] 유사 역행렬을 사용하는 방법도 있지만,[31] 계산 효율이 좋지 않아 잘 사용되지 않는다.

4. 1. 1차 방정식의 경우

x에 대응하는 y의 자료들이 있을 때, 이에 맞는 일차방정식은 이다. 여기서 a, b의 값을 알기 위해서는 다음의 '정규방정식(normal equation)'을 연립한다.:

:

모델 함수를 1차 함수 라고 두면, a, b는 다음 식으로 구할 수 있다.

:

:

5. 비선형 최소제곱법

모델 함수가 매개변수들의 선형 결합으로 표현되지 않는 경우(예: β^2, e^(βx) 등)에는 비선형 최소제곱법을 사용한다. 비선형 최소제곱법은 일반적으로 반복적인 수치 알고리즘을 통해 해를 구하며, 가우스-뉴턴 알고리즘[33], 레벤베르크-마쿼트 알고리즘[34][35][36][37][38] 등이 사용된다.

어떤 경우에는 비선형 최소제곱 문제에 대한 폐쇄형 해가 존재하지만, 일반적으로는 그렇지 않다. 폐쇄형 해가 없는 경우, 목표를 최소화하는 매개변수 의 값을 찾기 위해 수치 알고리즘이 사용된다. 대부분의 알고리즘은 매개변수의 초기 값을 선택하는 것을 포함한다. 그런 다음 매개변수는 반복적으로 개선된다. 즉, 값은 연속적인 근사로 얻어진다.

:

여기서 위첨자 ''k''는 반복 횟수이고, 증가 벡터 는 이동 벡터라고 한다. 일반적으로 사용되는 일부 알고리즘에서는 각 반복에서 모델을 에 대한 1차 테일러 급수 확장을 통해 선형화할 수 있다.

:

야코비 행렬 '''J'''는 상수, 독립 변수, 매개변수의 함수이므로 반복마다 변경된다. 잔차는 다음과 같다.

:

의 제곱합을 최소화하기 위해, 기울기 방정식을 0으로 설정하고 에 대해 풀면, '''정규 방정식'''이 되는 ''m''개의 연립 선형 방정식이 된다.

:

정규 방정식은 행렬 표기법으로 다음과 같이 쓸 수 있다.

:

이것들은 가우스-뉴턴 알고리즘의 정의 방정식이다.

선형 최소제곱법(LLSQ)과 비선형 최소제곱법(NLLSQ)의 주요 차이점은 다음과 같다.[12]

- 모델 함수: LLSQ에서 모델 함수는 매개변수들의 선형 결합이다. NLLSQ에서는 매개변수가 등과 같은 함수로 나타난다.

- 초기값: NLLSQ는 매개변수의 초기값이 필요하지만, LLSQ는 그렇지 않다.

- 해법 알고리즘: NLLSQ는 반복적인 알고리즘을 사용해야 하는 경우가 많다.

- 비수렴: NLLSQ에서는 알고리즘이 최솟값을 찾지 못하는 비수렴 문제가 발생할 수 있다.

- 최솟값: NLLSQ에서는 제곱합에 여러 개의 최솟값이 존재할 수 있다.

비선형 최소 제곱 문제의 해를 구하려는 경우에는 이러한 차이점을 반드시 고려해야 한다.

6. 가중 최소제곱법

'''가중 최소 제곱법'''은 각 관측값의 오차 분산이 다른 경우(이분산성)에 사용되는 방법이다. 이 방법은 오차가 큰 관측값보다 오차가 작은 관측값에 더 큰 가중치를 부여하여 모수를 추정한다. 즉, 잔차 제곱합 대신 가중 잔차 제곱합을 최소화하는 방식으로 동작한다.[10]

예를 들어, ''n''회 측정에서 오차가 미리 알려져 있고, 각 측정마다 오차가 다른 경우가 있을 수 있다. 이때, 오차의 크기를 표준 편차 로 나타낸다면, 오차가 큰 측정보다 오차가 작은 측정 결과에 더 가중치를 두는 것이 합리적이다. 따라서, 다음과 같은 가중 잔차 제곱합 ''J' ''를 최소화하는 함수 ''f''를 찾는 것이 더 정확한 근사를 제공한다.

:

매회의 측정이 독립이고 오차가 정규 분포를 따른다면, 측정값의 우도는 에 비례한다. 따라서 위의 ''J' ''를 최소화하는 ''f''는 최대 우도 추정이기도 하다. 또한, ''J' ''는 자유도 ''n-m''의 카이제곱 분포[32]를 따르므로, 이를 사용하여 모델 ''f''의 타당성을 검정할 수도 있다.

만약 매회 측정 오차가 같다면, 가중 잔차 제곱합 ''J' ''를 최소화하는 것은 일반적인 잔차 제곱합 ''J''를 최소화하는 것과 같은 의미가 된다.

7. 정규화

티호노프 정규화(릿지 회귀)는 파라미터 벡터의 제곱 -노름인 이 주어진 값보다 크지 않다는 제약 조건을 최소제곱법 공식에 추가하여 제약된 최소화 문제를 유도한다.[17] 이는 목적 함수가 잔차 제곱합과 페널티 항 의 합이고 가 튜닝 파라미터인 비제약 최소화 문제와 동일하다. 베이즈 맥락에서 이는 파라미터 벡터에 평균이 0인 정규 분포 사전을 배치하는 것과 동일하다.

Lasso (최소 절대 수축 및 선택 연산자)는 파라미터 벡터의 L1-노름인 이 주어진 값보다 크지 않다는 제약 조건을 사용한다.[18][19][20] 이는 이 추가된 최소제곱 벌점의 제약 없는 최소화와 동일하다. 베이즈 맥락에서 이는 파라미터 벡터에 평균이 0인 라플라스 사전 분포를 적용하는 것과 동일하다.[21] 최적화 문제는 2차 계획법 또는 더 일반적인 볼록 최적화 방법뿐만 아니라 최소 각도 회귀 알고리즘과 같은 특정 알고리즘을 사용하여 해결할 수 있다.

Lasso와 릿지 회귀의 주요 차이점 중 하나는 릿지 회귀에서는 벌점을 증가시키면 모든 파라미터가 0이 아닌 상태로 감소하는 반면, Lasso에서는 벌점을 증가시키면 점점 더 많은 파라미터가 0으로 수렴된다는 것이다. 이는 Lasso가 릿지 회귀보다 갖는 장점인데, 파라미터를 0으로 수렴시키면 회귀에서 특징을 선택 해제하기 때문이다. 따라서 Lasso는 자동으로 더 관련 있는 특징을 선택하고 다른 특징은 버리는 반면, 릿지 회귀는 어떠한 특징도 완전히 버리지 않는다. Bolasso(샘플을 부트스트랩한다.)를 포함하여 LASSO를 기반으로 개발된 일부 특징 선택 기술이 있다.[22]

''L''1-정규화 공식은 더 적은 변수에 의존하는 솔루션을 제공하여, 더 많은 파라미터가 0인 솔루션을 선호하는 경향이 있기 때문에 일부 맥락에서 유용하다.[18] 이러한 이유로 Lasso와 그 변형은 압축 센싱 분야의 기본이다. 이 접근 방식의 확장은 엘라스틱 넷 정규화이다.

8. 최소제곱법의 한계

최소제곱법은 종속 변수의 오차만을 고려하며, 독립 변수의 오차는 무시한다.[11] 독립 변수에 오차가 있는 경우에는 측정 오차 모델을 사용하거나, 총 최소 자승법 등을 고려할 수 있다.[11]

또한, 최소제곱법은 이상치에 민감하게 반응하여 모델의 정확도를 크게 떨어뜨릴 수 있다. 따라서 이상치 제거 등의 전처리 과정이 필요할 수 있다.[39] 예를 들어, 수정된 톰슨-τ 방법 등을 통해 이상치를 제거할 수 있다.[39]

최소제곱법의 이론적 기반에는 다음과 같은 전제가 있다.[26][24][25]

- 측정값의 오차에는 편향이 없다. 즉, 오차의 평균값은 0이다.

- 측정값의 오차의 분산은 알려져 있다. (단, 측정 데이터마다 달라도 된다.)

- 각 측정은 서로 독립이며, 오차의 공분산은 0이다.

- 오차는 정규 분포한다.

- ''m''개의 파라미터[27]를 포함하는 모델 함수 *f*가 알려져 있으며, 측정량의 참값을 근사 오차 없이 재현할 수 있는 파라미터가 존재한다.

만약 오차가 정규 분포를 따르지 않는다면, 최소제곱법으로 얻어진 모델 함수는 적절하지 않을 수 있다. 예를 들어, 우연 오차가 정규 분포를 따르지 않거나, 계통 오차가 커서 모델 함수에 포함되지 않은 경우, 또는 측정 데이터에 이상치가 포함된 경우가 이에 해당한다.

9. 응용

상수도 시설의 규모를 결정할 때, 해당 상수도를 이용하게 될 도시의 장래 인구수를 추정해야 한다. 최소제곱법은 과거의 인구 통계 자료를 바탕으로 장래 인구수를 예측하는 방법 중 하나이다. 이 방법을 통해 연도에 따른 인구수의 방정식을 구하고, 이를 이용하여 장래 인구수를 계산할 수 있다.[12]

n개의 연도와 인구 수 자료가 있을 때, 구하고자 하는 방정식은 형태이다. 여기서 상수 a와 b를 계산하여 장래 연도 x를 대입하면 장래 인구수 y를 예측할 수 있다.

예를 들어, 1990년부터 1996년까지 기록된 인구 자료를 바탕으로 최소제곱법을 적용하면 다음과 같다.

위 표와 같이 연도를 치환하고, 최소제곱법을 통해 계산하면 다음과 같은 방정식을 얻을 수 있다.

:

1993년을 X=0으로 설정했으므로, 2000년은 X=7에 해당한다. 이 값을 방정식에 대입하면 2000년의 인구수는 220,650명으로 예측된다.

이처럼 최소제곱법은 상수도 시설 규모 결정, 도시의 장래 인구수 추정 등 다양한 분야에 응용될 수 있다. 급수(상하수도 공학)에서 최소제곱법을 활용하여 과거 인구 통계 자료를 바탕으로 장래 인구수를 예측하고, 이를 기반으로 상수도 시설의 적정 규모를 결정할 수 있다.

참조

[1]

논문

The Equivalence of Generalized Least Squares and Maximum Likelihood Estimates in the Exponential Family

[2]

문서

A List of Writings Relating to the Method of Least Squares

[3]

서적

Linear Algebra With Applications

Prentice Hall

[4]

논문

Gauss and the Invention of Least Squares

[5]

논문

The discovery of the method of least squares

https://hedibert.org[...]

1972

[6]

서적

The History of Statistics: The Measurement of Uncertainty Before 1900

https://archive.org/[...]

Belknap Press of Harvard University Press

[7]

간행물

Nouvelles méthodes pour la détermination des orbites des comètes

https://books.google[...]

F. Didot

[8]

웹사이트

The Discovery of Statistical Regression

https://priceonomics[...]

2023-04-04

[9]

논문

Doing Least Squares: Perspectives from Gauss and Yule

[10]

서적

A modern introduction to probability and statistics: understanding why and how

Springer

2005

[11]

서적

Measurement Error Models

John Wiley & Sons

[12]

서적

Quantifying measurement: the tyranny of numbers

2016-11

[13]

서적

Methods of Multivariate Analysis

https://books.google[...]

John Wiley & Sons

2012-08-15

[14]

서적

Mechanics of Materials

Cengage Learning

2013

[15]

백과사전

Gauss-Markov Theorem

https://onlinelibrar[...]

Wiley

2023-10-18

[16]

논문

A New Approach to Least-Squares Estimation, with Applications

1987-06

[17]

arXiv

Lecture notes on ridge regression

[18]

논문

Regression shrinkage and selection via the lasso

[19]

서적

The Elements of Statistical Learning

http://www-stat.stan[...]

Springer-Verlag

2009

[20]

서적

Statistics for High-Dimensional Data: Methods, Theory and Applications

Springer

2011

[21]

논문

The Bayesian Lasso

2008

[22]

논문

Proceedings of the 25th international conference on Machine learning - ICML '08

2008

[23]

논문

Scoring relevancy of features based on combinatorial analysis of Lasso with application to lymphoma diagnosis

2013

[24]

서적

Solving Least Squares Problems

https://epubs.siam.o[...]

Society for Industrial and Applied Mathematics

[25]

서적

Numerical Methods for Least Squares Problems

https://epubs.siam.o[...]

Society for Industrial and Applied Mathematics

[26]

서적

最小二乗法による実験データ解析

東京大学出版会

[27]

문서

[28]

문서

[29]

서적

数値解析入門

サイエンス社

2003-06

[30]

논문

The truncated SVD as a method for regularization

https://doi.org/10.1[...]

Springer

[31]

문서

[32]

웹사이트

Chi-Squared Distribution

https://mathworld.wo[...]

[33]

서적

A contemporary study of iterative methods: convergence, dynamics and applications

https://books.google[...]

Academic Press

[34]

웹사이트

Levenberg-Marquardt Method

https://mathworld.wo[...]

[35]

논문

The Levenberg-Marquardt algorithm : Implementation and theory

https://link.springe[...]

[36]

간행물

Levenberg-marquardt training

2011

[37]

학술지

The levenberg-marquardt algorithm

https://sites.cs.ucs[...]

[38]

학술지

Levenberg-Marquardt法の局所収束性について (最適化の数理科学)

https://hdl.handle.n[...]

京都大学数理解析研究所

2000-10

[39]

Matlab

Find Outliers with Thompson Tau

https://www.mathwork[...]

2020-05-17

[40]

서적

The total least squares problem: computational aspects and analysis

SIAM

1991

[41]

학술지

An analysis of the total least squares problem

https://doi.org/10.1[...]

SIAM

[42]

서적

The coordinate-free approach to Gauss-Markov estimation

Springer Science & Business Media

2012

[43]

서적

Fitting models to biological data using linear and nonlinear regression: a practical guide to curve fitting

Oxford University Press

2004

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com